—Tate Ryan-Mosley, reportero sénior de políticas tecnológicas

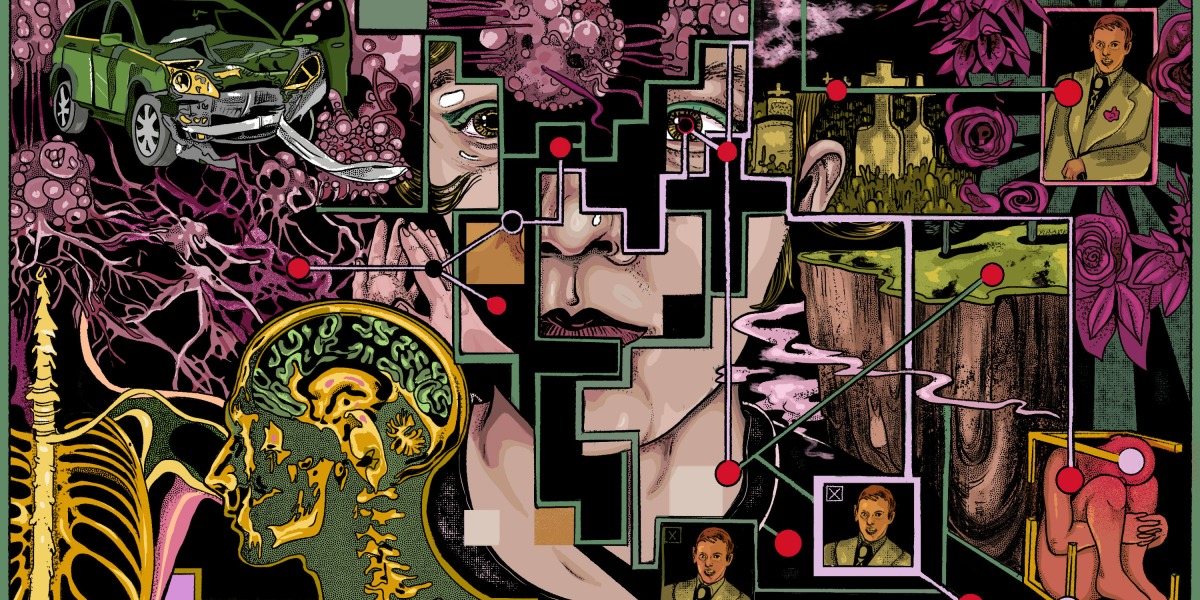

Siempre he sido un súper Googler, lidiando con la incertidumbre tratando de aprender todo lo que pueda sobre lo que pueda venir. Eso incluía el cáncer de garganta de mi padre.

Empecé a buscar en Google las etapas del duelo y los libros y la investigación académica sobre la pérdida, desde la aplicación en mi iPhone, consumiendo intencionalmente y sin querer las experiencias de duelo y tragedia de las personas a través de videos de Instagram, varias fuentes de noticias y testimonios de Twitter.

Sin embargo, con cada búsqueda y clic, sin darme cuenta creé una telaraña pegajosa de dolor digital. En última instancia, resultaría casi imposible desenredarme de lo que me estaban sirviendo los algoritmos. Salí, eventualmente. Pero, ¿por qué es tan difícil cancelar la suscripción y optar por no recibir contenido que no queremos, incluso cuando es dañino para nosotros? Lea la historia completa.

Los modelos de IA escupen fotos de personas reales e imágenes con derechos de autor

Las noticias: Se puede pedir a los modelos de generación de imágenes que produzcan fotos identificables de personas reales, imágenes médicas y obras de artistas con derechos de autor, según una nueva investigación.

Cómo lo hicieron: Los investigadores solicitaron Stable Diffusion e Imagen de Google con subtítulos para las imágenes, como el nombre de una persona, muchas veces. Luego analizaron si alguna de las imágenes generadas coincidía con las imágenes originales en la base de datos del modelo. El grupo logró extraer más de 100 réplicas de imágenes en el conjunto de entrenamiento de la IA.

Por qué importa: El hallazgo podría fortalecer el caso de los artistas que actualmente están demandando a las empresas de IA por violaciones de derechos de autor y podría amenazar potencialmente la privacidad de los sujetos humanos. También podría tener implicaciones para las empresas emergentes que deseen utilizar modelos generativos de IA en el cuidado de la salud, ya que muestra que estos sistemas corren el riesgo de filtrar información privada confidencial. Lea la historia completa.