Ars Technica

Modelo de síntesis de texto a imagen líder en China, Baidu ERNIE-ViLGcensura texto político como “Plaza de Tiananmen” o nombres de líderes políticos, informes Zeyi Yang para ..

La síntesis de imágenes ha demostrado ser popular (y controvertida) recientemente en las redes sociales y en las comunidades de arte en línea. H erramientas como Stable Diffusion y DALL-E 2 permiten a las personas crear imágenes de casi cualquier cosa que puedan imaginar escribiendo una descripción de texto llamada “mensaje”.

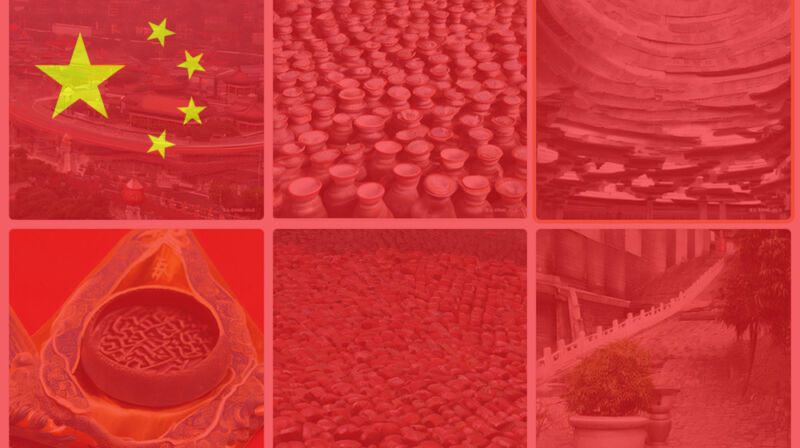

En 2021, la empresa tecnológica china Baidu desarrolló su propio modelo de síntesis de imágenes llamado ERNIE-ViLGy mientras probaban demostraciones públicas, algunos usuarios fundar que censura frases políticas. Siguiendo las recomendaciones de . reporte detalladohicimos nuestra propia prueba de un demostración de ERNIE-ViLG alojado en Hugging Face y confirmó que frases como “democracia en China” y “bandera china” no generan imágenes. En su lugar, producen una advertencia en idioma chino que dice aproximadamente (traducido): “El contenido de entrada no cumple con las reglas relevantes, ajústelo e inténtelo de nuevo”.

Ars Technica

Encontrar restricciones en la síntesis de imágenes no es exclusivo de China, aunque hasta ahora ha tomado una forma diferente a la censura estatal. En el caso de DALL-E 2, la empresa estadounidense OpenAI política de contenido restringe algunas formas de contenido, como desnudez, violencia y contenido político. Pero esa es una elección voluntaria por parte de OpenAI, no debido a presión del gobierno de los EE.UU. Midjourney también voluntariamente filtra algunos contenidos por palabra clave.

Stable Diffusion, de Stability AI, con sede en Londres, viene con un “Filtro de seguridad” incorporado que se puede desactivado debido a su naturaleza de código abierto, casi todo vale con ese modelo, dependiendo de dónde lo ejecute. En particular, el jefe de Stability AI, Emad Mostaque, ha hablado sobre querer evitar la censura gubernamental o corporativa de los modelos de síntesis de imágenes. “Creo que la gente debería ser libre de hacer lo que mejor le parezca al hacer estos modelos y servicios”, dijo. escribió en una respuesta de Reddit AMA la semana pasada.

No está claro si Baidu censura su modelo ERNIE-ViLG voluntariamente para evitar posibles problemas del gobierno chino o si está respondiendo a una posible regulación (como una regla del gobierno con respecto a las falsificaciones profundas). propuesto en Enero). Pero considerando a China historia con la censura de los medios tecnológicosno sería sorprendente ver pronto una restricción oficial en algunas formas de contenido generado por IA.