La pandemia que se ha extendido por todo el mundo durante el año pasado ha arrojado una luz fría y dura sobre muchas cosas: los diversos niveles de preparación para responder; actitudes colectivas hacia la salud, la tecnología y la ciencia; y vastas desigualdades financieras y sociales. A medida que el mundo continúa navegando por la crisis de salud del covid-19, y algunos lugares incluso comienzan un regreso gradual al trabajo, la escuela, los viajes y la recreación, es fundamental resolver las prioridades en competencia de proteger la salud pública de manera equitativa y al mismo tiempo garantizar la privacidad.

La crisis prolongada ha provocado un cambio rápido en el comportamiento laboral y social, así como una mayor dependencia de la tecnología. Ahora es más importante que nunca que las empresas, los gobiernos y la sociedad tengan cuidado al aplicar la tecnología y manejar la información personal. La adopción expandida y rápida de la inteligencia artificial (IA) demuestra cómo las tecnologías adaptativas son propensas a cruzarse con los seres humanos y las instituciones sociales de formas potencialmente riesgosas o inequitativas.

“Nuestra relación con la tecnología en su conjunto habrá cambiado drásticamente después de la pandemia”, dice Yoav Schlesinger, director de la práctica ética de IA en Salesforce. “Habrá un proceso de negociación entre personas, empresas, gobierno y tecnología; cómo sus datos fluyen entre todas esas partes se renegociarán en un nuevo contrato de datos sociales “.

IA en acción

A medida que la crisis del covid-19 comenzó a desarrollarse a principios de 2020, los científicos recurrieron a la inteligencia artificial p ara respaldar una variedad de usos médicos, como identificar posibles candidatos a fármacos para vacunas o tratamientos, ayudar a detectar posibles síntomas del covid-19 y asignar recursos escasos como -Camas y ventiladores de la unidad de cuidados. Específicamente, se apoyaron en el poder analítico de los sistemas aumentados por IA para desarrollar vacunas y tratamientos de vanguardia.

Si bien las herramientas avanzadas de análisis de datos pueden ayudar a extraer conocimientos de una gran cantidad de datos, el resultado no siempre ha sido resultados más equitativos. De hecho, las herramientas impulsadas por la inteligencia artificial y los conjuntos de datos con los que trabajan pueden perpetuar el sesgo inherente o la inequidad sistémica. A lo largo de la pandemia, agencias como los Centros para el Control y la Prevención de Enfermedades y la Organización Mundial de la Salud han recopilado enormes cantidades de datos, pero los datos no representan necesariamente con precisión las poblaciones que se han visto afectadas de manera desproporcionada y negativa, incluidas las personas de raza negra, marrón e indígena. personas, ni tampoco algunos de los avances diagnósticos que han logrado, dice Schlesinger.

Por ejemplo, los wearables biométricos como Fitbit o Apple Watch demuestran ser prometedores en su capacidad para detectar posibles síntomas del covid-19, como cambios en la temperatura o la saturación de oxígeno. Sin embargo, esos análisis se basan en conjuntos de datos a menudo defectuosos o limitados y pueden introducir sesgos o injusticias que afectan de manera desproporcionada a las personas y comunidades vulnerables.

“Hay algunas investigaciones que muestran luz LED verde tiene más dificultades para leer el pulso y la saturación de oxígeno en tonos de piel más oscuros ”, dice Schlesinger, refiriéndose a la fuente de luz semiconductora. “Por lo tanto, es posible que no sea igualmente bueno para detectar los síntomas de la covidumbre en personas de piel negra y morena”.

La IA ha demostrado una mayor eficacia para ayudar a analizar enormes conjuntos de datos. Un equipo de la Escuela de Ingeniería Viterbi de la Universidad del Sur de California desarrolló un marco de inteligencia artificial para ayudar a analizar los candidatos a la vacuna covid-19. Después de identificar a 26 candidatos potenciales, redujo el campo a 11 que tenían más probabilidades de tener éxito. La fuente de datos para el análisis fue la base de datos de epítopos inmunes, que incluye más de 600.000 determinantes de contagio que surgen de más de 3.600 especies.

Otros investigadores de Viterbi están aplicando IA para descifrar códigos culturales con mayor precisión y comprender mejor las normas sociales que guían el comportamiento de los grupos étnicos y raciales. Eso puede tener un impacto significativo en cómo le va a cierta población durante una crisis como la pandemia, debido a ceremonias religiosas, tradiciones y otras costumbres sociales que pueden facilitar la propagación viral.

Los científicos líderes Kristina Lerman y Fred Morstatter han basado su investigación en Teoría de los fundamentos morales, que describe la “ética intuitiva” que forman las construcciones morales de una cultura, como el cuidado, la justicia, la lealtad y la autoridad, que ayudan a informar el comportamiento individual y grupal.

“Nuestro objetivo es desarrollar un marco que nos permita comprender la dinámica que impulsa el proceso de toma de decisiones de una cultura a un nivel más profundo”, dice Morstatter en un informe publicado por USC. “Y al hacerlo, generamos pronósticos más informados culturalmente”.

La investigación también examina cómo implementar la IA de una manera ética y justa. “La mayoría de las personas, pero no todas, están interesadas en hacer del mundo un lugar mejor”, dice Schlesinger. “Ahora tenemos que pasar al siguiente nivel: ¿qué metas queremos lograr y qué resultados nos gustaría ver? ¿Cómo mediremos el éxito y cómo será? “

Aliviar las preocupaciones éticas

Es fundamental cuestionar las suposiciones sobre los datos recopilados y los procesos de inteligencia artificial, dice Schlesinger. “Hablamos de lograr la equidad a través de la conciencia. En cada paso del proceso, usted hace juicios de valor o suposiciones que ponderarán sus resultados en una dirección particular ”, dice. “Ese es el desafío fundamental de la construcción de una IA ética, que es mirar todos los lugares donde los humanos están predispuestos”.

Parte de ese desafío es realizar un examen crítico de los conjuntos de datos que informan a los sistemas de IA. Es esencial comprender las fuentes de datos y la composición de los datos, y responder preguntas como: ¿Cómo se componen los datos? ¿Abarca una gama diversa de partes interesadas? ¿Cuál es la mejor manera de implementar esos datos en un modelo para minimizar el sesgo y maximizar la equidad?

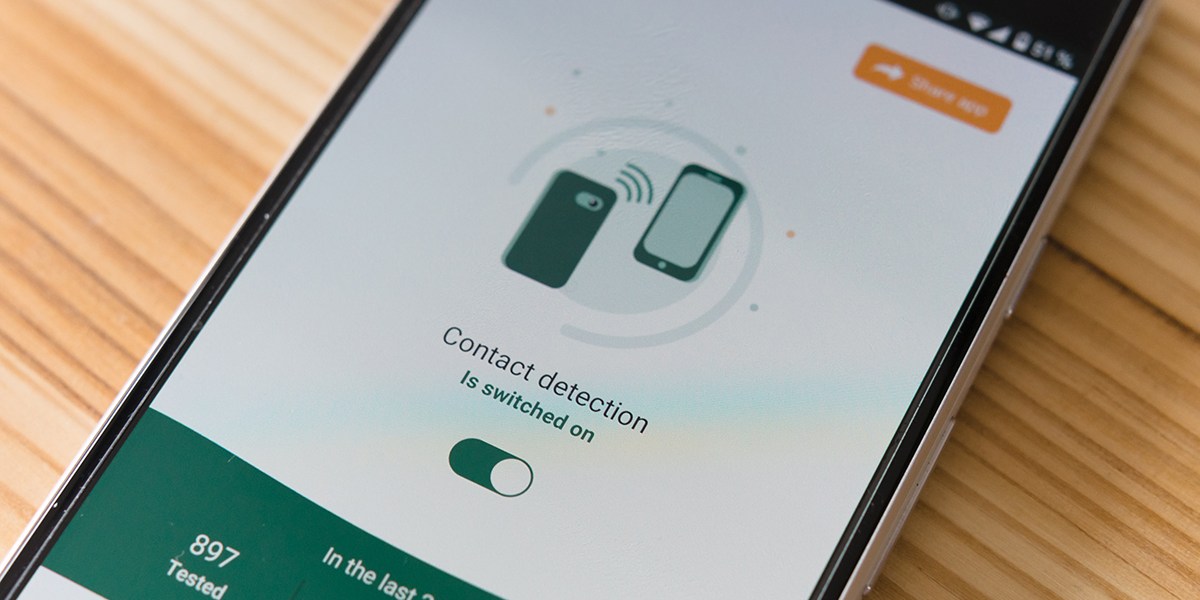

A medida que la gente regresa al trabajo, los empleadores pueden utilizando tecnologías de detección con IA incorporada, incluidas cámaras térmicas para detectar altas temperaturas; sensores de audio para detectar toses o voces elevadas, que contribuyen a la propagación de gotitas respiratorias; y transmisiones de video para monitorear los procedimientos de lavado de manos, las regulaciones de distancia física y los requisitos de máscaras.

Dichos sistemas de seguimiento y análisis no solo presentan desafíos de precisión técnica, sino que plantean riesgos fundamentales para derechos humanos, privacidad, seguridad y confianza. El ímpetu para una mayor vigilancia ha sido un efecto secundario preocupante de la pandemia. Las agencias gubernamentales han utilizado imágenes de cámaras de vigilancia, datos de ubicación de teléfonos inteligentes, registros de compras con tarjetas de crédito e incluso escaneos pasivos de temperatura en áreas públicas abarrotadas como aeropuertos para ayudar a rastrear los movimientos de las personas que pueden haber contraído o haber estado expuestas al covid-19 y establecer la transmisión del virus. cadenas

“La primera pregunta que debe responderse no es solo ¿podemos hacer esto, sino que debemos hacerlo?” dice Schlesinger. “Escanear a las personas en busca de sus datos biométricos sin su consentimiento genera preocupaciones éticas, incluso si se posiciona como un beneficio para el bien común. Deberíamos tener una conversación sólida como sociedad sobre si hay una buena razón para implementar estas tecnologías en primer lugar “.

Como se ve el futuro

A medida que la sociedad regresa a algo que se aproxima a la normalidad, es hora de reevaluar fundamentalmente la relación con los datos y establecer nuevas normas para la recopilación de datos, así como el uso apropiado, y el posible uso indebido, de los datos. Al construir e implementar IA, los tecnólogos continuarán haciendo esas suposiciones necesarias sobre los datos y los procesos, pero los fundamentos de esos datos deben cuestionarse. ¿Se obtienen los datos de forma legítima? ¿Quién lo montó? ¿En qué supuestos se basa? ¿Se presenta con precisión? ¿Cómo se puede preservar la privacidad de los ciudadanos y los consumidores?

A medida que la IA se implementa más ampliamente, es esencial considerar cómo también generar confianza. El uso de la inteligencia artificial para aumentar la toma de decisiones humanas y no reemplazar por completo la participación humana es un enfoque.

“Habrá más preguntas sobre el papel que debería desempeñar la IA en la sociedad, su relación con los seres humanos y cuáles son las tareas apropiadas para los humanos y cuáles son las tareas apropiadas para una IA”, dice Schlesinger. “Hay ciertas áreas en las que las capacidades de la IA y su capacidad para aumentar las capacidades humanas acelerarán nuestra confianza y dependencia. En lugares donde la IA no reemplaza a los humanos, sino que aumenta sus esfuerzos, ese es el próximo horizonte “.

Siempre habrá situaciones en las que un ser humano deba participar en la toma de decisiones. “En industrias reguladas, por ejemplo, como la atención médica, la banca y las finanzas, es necesario que haya un ser humano en el circuito para mantener el cumplimiento”, dice Schlesinger. “No se puede simplemente implementar IA para tomar decisiones de atención sin la participación de un médico. Por mucho que nos encantaría creer que la IA es capaz de hacer eso, la IA todavía no tiene empatía y probablemente nunca la tendrá “.

Es fundamental que los datos recopilados y creados por la IA no exacerben, sino que minimicen la inequidad. Debe haber un equilibrio entre encontrar formas para que la IA ayude a acelerar el progreso humano y social, promover acciones y respuestas equitativas y simplemente reconocer que ciertos problemas requerirán soluciones humanas.

Este contenido fue producido por Insights, el brazo de contenido personalizado de .. No fue escrito por el personal editorial de ..