Ahora la respuesta está ahí, y no está nada cerca. Cuatro años después de anunciar un proyecto “increíblemente loco” para construir una interfaz de “habla silenciosa” utilizando tecnología óptica para leer pensamientos, Facebook está archivando el proyecto, diciendo que la lectura del cerebro de los consumidores aún está muy lejos.

En una publicación de blog, Facebook dijo que está descontinuando el proyecto y, en cambio, se enfocará en un controlador de muñeca experimental para realidad virtual que lee señales musculares en el brazo. “Si bien todavía creemos en el potencial a largo plazo de los dispositivos ópticos montados en la cabeza [brain-computer interface] tecnologías, hemos decidido centrar nuestros esfuerzos inmediatos en un enfoque de interfaz neuronal diferente que tiene un camino a corto plazo al mercado ”, dijo la compañía.

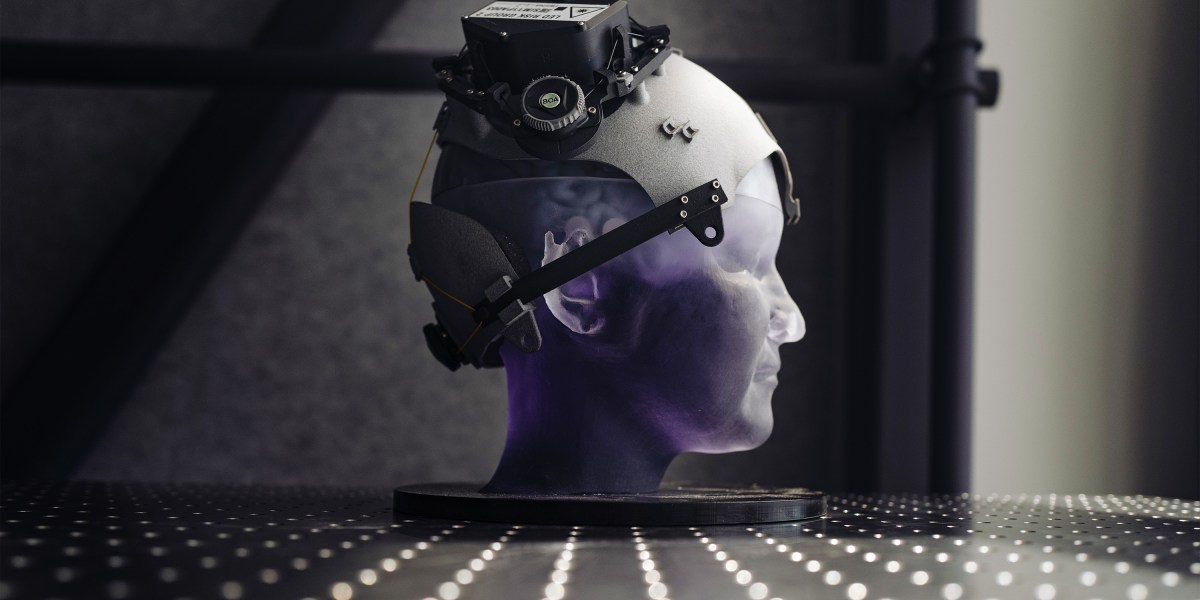

El proyecto de mecanografía cerebral de Facebook lo había llevado a un territorio inexplorado, incluida la financiación de cirugías cerebrales en un hospital de California y la construcción de prototipos de cascos que pudieran disparar luz a través del cráneo, y a duros debates sobre si las empresas de tecnología deberían acceder a información privada del cerebro. Sin embargo, en última instancia, la empresa parece haber decidido que la investigación simplemente no conducirá a un producto lo suficientemente pronto.

“Tenemos mucha experiencia práctica con estas tecnologías”, dice Mark Chevillet, el físico y neurocientífico que hasta el año pasado dirigió el proyecto del habla silenciosa, pero recientemente cambió de roles para estudiar cómo Facebook maneja las elecciones. “Es por eso que podemos decir con confianza, como interfaz de consumidor, un dispositivo óptico de voz silencioso montado en la cabeza todavía está muy lejos. Posiblemente más de lo que hubiéramos previsto “.

Lectura de la mente

La razón de la locura en torno a las interfaces cerebro-computadora es que las empresas ven el software controlado por la mente como un gran avance, tan importante como el mouse de la computadora, la interfaz gráfica de usuario o la pantalla deslizante. Además, los investigadores ya han demostrado que si colocan electrodos directamente en el cerebro para captar neuronas individuales, los resultados son notables. Los pacientes paralizados con tales “implantes” pueden mover hábilmente brazos robóticos y jugar videojuegos o tipo a través del control mental.

El objetivo de Facebook era convertir esos hallazgos en una tecnología de consumo que cualquiera pudiera usar, lo que significaba un casco o auriculares que podía ponerse y quitarse. “Nunca tuvimos la intención de hacer un producto de cirugía cerebral”, dice Chevillet. Dados los muchos problemas regulatorios del gigante social, el director ejecutivo Mark Zuckerberg dijo una vez que lo último que debería hacer la empresa es romper cráneos abiertos. “No quiero ver las audiencias del Congreso sobre ese”, él bromeó

De hecho, a medida que avanzan las interfaces cerebro-computadora, surgen nuevas preocupaciones serias. ¿Qué pasaría si las grandes empresas tecnológicas pudieran conocer los pensamientos de las personas? En Chile, los legisladores incluso están considerando un proyecto de ley de derechos humanos para proteger datos cerebrales, libre albedrío y privacidad mental de empresas tecnológicas. Dado el pobre historial de Facebook en materia de privacidad, la decisión de detener esta investigación puede tener el beneficio adicional de poner cierta distancia entre la empresa y las crecientes preocupaciones sobre los “neurorights”.

El proyecto de Facebook apuntaba específicamente a un controlador cerebral que pudiera encajar con sus ambiciones en la realidad virtual; compró Oculus VR en 2014 por $ 2 mil millones. Para llegar allí, la empresa adoptó un enfoque doble, dice Chevillet. Primero, necesitaba determinar si era posible una interfaz de pensamiento a voz. Para eso, patrocinó una investigación en la Universidad de California, San Francisco, donde un investigador llamado Edward Chang colocó electrodos en la superficie del cerebro de las personas.

Mientras que los electrodos implantados leen datos de neuronas individuales, esta técnica, llamada electrocorticografía o ECoG, mide a la vez grupos bastante grandes de neuronas. Chevillet dice que Facebook esperaba que también fuera posible detectar señales equivalentes desde fuera de la cabeza.

El equipo de UCSF logró un progreso sorprendente y hoy informa en el New England Journal of Medicine que usó esos electrodos para decodificar el habla en tiempo real. El sujeto era un hombre de 36 años al que los investigadores se refieren como “Bravo-1”, quien después de un derrame cerebral grave ha perdido su capacidad para formar palabras inteligibles y solo puede gruñir o gemir. En su informe, el grupo de Chang dice que con los electrodos en la superficie de su cerebro, Bravo-1 ha podido formar oraciones en una computadora a una velocidad de aproximadamente 15 palabras por minuto. La tecnología consiste en medir señales neuronales en la parte de la corteza motora asociada con los esfuerzos de Bravo-1 para mover su lengua y tracto vocal mientras se imagina hablando.

Para alcanzar ese resultado, el equipo de Chang le pidió a Bravo-1 que se imaginara diciendo una de las 50 palabras comunes casi 10,000 veces, alimentando las señales neuronales del paciente a un modelo de aprendizaje profundo. Después de entrenar el modelo para relacionar palabras con señales neuronales, el equipo pudo determinar correctamente la palabra que Bravo-1 pensaba decir el 40% del tiempo (los resultados de probabilidad habrían sido de aproximadamente el 2%). Aun así, sus frases estaban llenas de errores. “¿Hola como estas?” podría salir “Hambriento, ¿cómo estás?”

Pero los científicos mejoraron el rendimiento al agregar un modelo de lenguaje, un programa que juzga qué secuencias de palabras son más probables en inglés. Eso aumentó la precisión al 75%. Con este enfoque de cyborg, el sistema podría predecir que la oración de Bravo-1 “Tengo razón en mi enfermera” en realidad significaba “Me gusta mi enfermera”.

Por notable que sea el resultado, hay más de 170.000 palabras en inglés, por lo que el rendimiento se desplomaría fuera del vocabulario restringido de Bravo-1. Eso significa que la técnica, aunque podría ser útil como ayuda médica, no se acerca a lo que Facebook tenía en mente. “Vemos aplicaciones en el futuro previsible en tecnología de asistencia clínica, pero no es ahí donde está nuestro negocio”, dice Chevillet. “Nos centramos en las aplicaciones para el consumidor y hay un largo camino por recorrer para lograrlo”.

Fallo óptico

La decisión de Facebook de abandonar la lectura del cerebro no sorprende a los investigadores que estudian estas técnicas. “No puedo decir que esté sorprendido, porque habían insinuado que estaban considerando un período de tiempo corto y que iban a reevaluar las cosas”, dice Marc Slutzky, profesor de Northwestern cuya ex alumna Emily Mugler fue una contratada clave para la que Facebook hizo su proyecto. “Simplemente hablando por experiencia, el objetivo de decodificar el habla es un gran desafío. Todavía estamos muy lejos de una solución práctica que lo abarque todo “.

Aún así, Slutsky dice que el proyecto UCSF es un “siguiente paso impresionante” que demuestra tanto posibilidades notables como algunos límites de la ciencia de la lectura del cerebro. “Queda por ver si puede decodificar el habla de forma libre”, dice. “Un paciente que dice ‘Quiero un trago de agua’ versus ‘Quiero mi medicamento’, bueno, esos son diferentes”. Él dice que si los modelos de inteligencia artificial pudieran entrenarse durante más tiempo y en el cerebro de más de una persona, podrían mejorar rápidamente.

Mientras se realizaba la investigación de la UCSF, Facebook también pagaba a otros centros, como el Laboratorio de Física Aplicada en Johns Hopkins, para descubrir cómo bombear luz a través del cráneo para leer neuronas de forma no invasiva. Al igual que la resonancia magnética, esas técnicas se basan en detectar la luz reflejada para medir la cantidad de flujo sanguíneo a las regiones del cerebro.

Son estas técnicas ópticas las que siguen siendo el mayor obstáculo. Incluso con las mejoras recientes, incluidas algunas de Facebook, no pueden captar señales neuronales con suficiente resolución. Otro problema, dice Chevillet, es que el flujo sanguíneo que detectan estos métodos ocurre cinco segundos después de que se activa un grupo de neuronas, lo que hace que sea demasiado lento para controlar una computadora.