El miércoles, Google presentó PALMA 2, una familia de modelos de lenguaje fundamentales comparables a GPT-4 de OpenAI. En su evento Google I/O en Mountain View, Google reveló que ya está utilizando PaLM 2 para potenciar 25 productos diferentes, incluido su asistente de IA conversacional Bard.

Como una familia de modelos de lenguaje grande (LLM), PaLM 2 ha sido entrenado en un enorme volumen de datos y hace predicción de la siguiente palabra, lo que genera el texto más probable después de una entrada rápida por parte de humanos. PaLM significa “Pathways Language Model” y, a su vez, “caminos” es una técnica de aprendizaje automático creada en Google. PaLM 2 sigue el palma originalque Google anunció en abril de 2022.

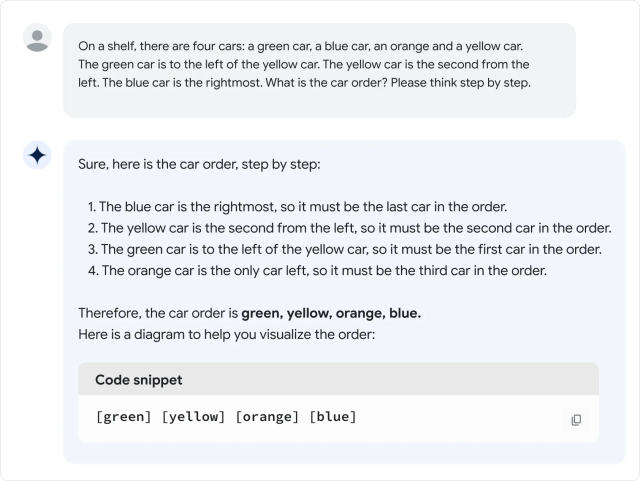

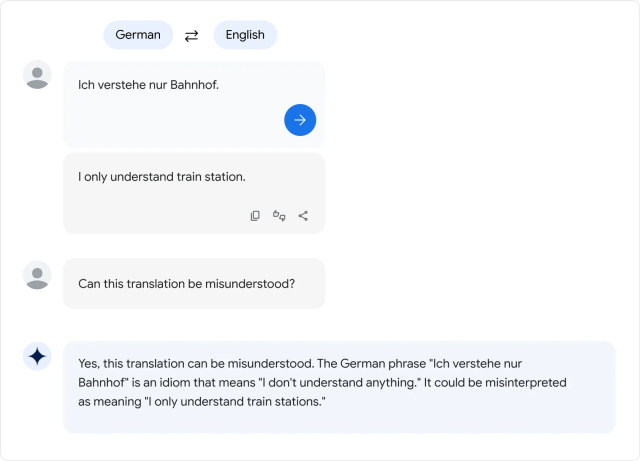

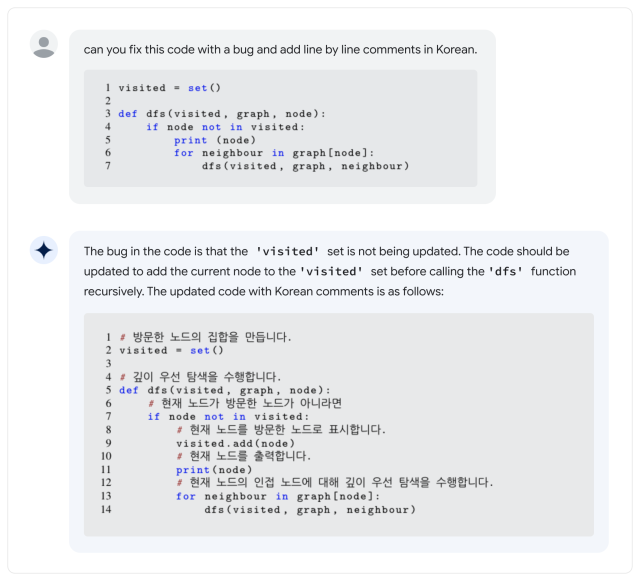

Según Google, PaLM 2 admite más de 100 idiomas y puede realizar “razonamiento”, generación de código y traducción multilingüe. Durante su discurso de apertura de Google I/O de 2023, el CEO de Google, Sundar Pichai, dijo que PaLM 2 viene en cuatro tamaños: Gecko, Otter, Bison, Unicorn. Gecko es el más pequeño y, según se informa, puede ejecutarse en un dispositivo móvil. Aparte de Bard, PaLM 2 está detrás de las funciones de IA en Documentos, Hojas de cálculo y Presentaciones.

Todo eso está muy bien, pero ¿cómo se compara PaLM 2 con GPT-4? En el Informe técnico de PaLM 2Palma 2 aparece para vencer a GPT-4 en algunas tareas matemáticas, de traducción y de razonamiento. Pero la realidad podría no coincidir con los puntos de referencia de Google. En una evaluación superficial de la versión PaLM 2 de Bard realizada por Ethan Mollick, un profesor de Wharton que suele escribir sobre IA, Mollick descubre que el rendimiento de PaLM 2 parece peor que GPT-4 y Bing en una variedad de pruebas de lenguaje informales, que él detallado en un hilo de Twitter.

Hasta hace poco, la familia de modelos de lenguaje PaLM ha sido un producto interno de Google Research sin exposición al consumidor, pero Google comenzó ofreciendo acceso limitado a la API en marzo. Aún así, el primer PaLM se destacó por su enorme tamaño: 540 mil millones de parámetros. Los parámetros son variables numéricas que sirven como el “conocimiento” aprendido del modelo, permitiéndole hacer predicciones y generar texto basado en la entrada que recibe.

Más parámetros significan aproximadamente más complejidad, pero no hay garantía de que se usen de manera eficiente. En comparación, el GPT-3 de OpenAI (desde 2020) tiene 175 mil millones de parámetros. OpenAI nunca ha revelado la cantidad de parámetros en GPT-4.

Eso lleva a la gran pregunta: ¿Qué tan “grande” es PaLM 2 en términos de recuento de parámetros? Google no dicey eso ha frustrado a algunos expertos de la industria que a menudo luchan por una mayor transparencia en lo que hace que los modelos de IA funcionen.

Esa no es la única propiedad de PaLM 2 sobre la que Google no ha hablado. La empresa dice que PaLM 2 ha sido entrenado en “un conjunto diverso de fuentes: documentos web, libros, código, matemáticas y datos conversacionales”, pero no entra en detalles sobre qué son exactamente esos datos.

Al igual que con otros conjuntos de datos de modelos de lenguaje grandes, el conjunto de datos de PaLM 2 probablemente incluye una amplia variedad de material con copyright usado sin permiso y también material potencialmente dañino raspado de La Internet. Los datos de entrenamiento influyen decisivamente en el resultado de cualquier modelo de IA, por lo que algunos expertos han estado defendiendo el uso de conjuntos de datos abiertos que pueden brindar oportunidades para la reproducibilidad científica y el escrutinio ético.

“Ahora que los LLM son productos (no solo investigación), estamos en un punto de inflexión: las empresas con fines de lucro serán cada vez menos transparentes *específicamente* sobre los componentes que son más importantes”. tuiteó Jesse Dodge, científico investigador de la Instituto Allen de IA. “¡Solo si la comunidad de código abierto puede organizarse juntos podremos seguir el ritmo!”

Hasta ahora, las críticas por ocultar su salsa secreta no han impedido que Google busque un amplio despliegue de modelos de IA, a pesar de la tendencia en todos los LLM a inventar cosas de la nada. Durante Google I/O, los representantes de la compañía demostraron las funciones de IA en muchos de sus principales productos, lo que significa que una gran parte del público podría estar luchando contra las confabulaciones de IA pronto.

Y en lo que respecta a los LLM, PaLM 2 está lejos del final de la historia: en el discurso de apertura de I/O, Pichai mencionó que un nuevo modelo de IA multimodal llamado “Gemini” estaba actualmente en entrenamiento. A medida que continúa la carrera por el dominio de la IA, los usuarios de Google en EE. UU. y 180 otros países (extrañamente Excluyendo Canadá y Europa continental) pueden probar PaLM 2 ellos mismos como parte de Google Bard, el asistente experimental de IA.