Antrópico / Benj Edwards

El martes, la startup de inteligencia artificial Anthropic detalló los principios específicos de su “IA constitucional” enfoque de capacitación que proporciona a su chatbot Claude “valores” explícitos. Su objetivo es abordar las preocupaciones sobre la transparencia, la seguridad y la toma de decisiones en los sistemas de IA sin depender de los comentarios humanos para calificar las respuestas.

Claude es un chatbot de IA similar al ChatGPT de OpenAI que Anthropic lanzó en marzo.

“Hemos entrenado modelos de lenguaje para que respondan mejor a las preguntas de los adversarios, sin volverse obtusos y decir muy poco”, escribió Anthropic. en un tuit anunciando el papel. “Hacemos esto condicionándolos con un conjunto simple de principios de comportamiento a través de una técnica llamada IA constitucional”.

Mantener los modelos de IA en los rieles

Cuando los investigadores entrenan por primera vez un modelo de lenguaje grande sin procesar (LLM), casi cualquier salida de texto es posible. Un modelo incondicional podría decirte

Actualmente, las respuestas de bots como ChatGPT de OpenAI y Bing Chat de Microsoft evitan este tipo de comportamiento utilizando un técnica de acondicionamiento llamado aprendizaje de refuerzo a partir de la retroalimentación humana (RLHF).

Para utilizar RLHF, los investigadores proporcionan una serie de resultados (respuestas) del modelo de IA de muestra a los humanos. Luego, los humanos clasifican las salidas en términos de qué tan deseables o apropiadas parecen las respuestas en función de las entradas. Luego, los investigadores introducen esa información de calificación en el modelo, alterando la red neuronal y cambiando el comportamiento del modelo.

Tan eficaz como ha sido RLHF para evitar que ChatGPT se descarrile (¿Bing? No tanto), la técnica tiene inconvenientes, incluida la dependencia de labor humana y también exponiendo a esos humanos a material potencialmente inductor de trauma.

En contraste, la IA constitucional de Anthropic busca guiar los resultados de los modelos de lenguaje de IA en una dirección subjetivamente “más segura y más útil” entrenándola con una lista inicial de principios. “Este no es un enfoque perfecto”, Anthropic escribe“pero hace que los valores del sistema de IA sean más fáciles de entender y ajustar según sea necesario”.

En este caso, los principios de Anthropic incluyen la Declaración de Derechos Humanos de las Naciones Unidas, partes de los términos de servicio de Apple, varias “mejores prácticas” de confianza y seguridad, y los principios del laboratorio de investigación de IA de Anthropic. La constitución no está finalizada y Anthropic planea mejorarla iterativamente en función de los comentarios y la investigación adicional.

Por ejemplo, aquí hay cuatro principios constitucionales de IA Anthropic extraídos del declaración Universal de los Derechos Humanos

- Elija la respuesta que más apoye y fomente la libertad, la igualdad y el sentido de hermandad.

- Elija la respuesta que sea menos racista y sexista, y que sea menos discriminatoria por motivos de idioma, religión, opinión política o de otro tipo, origen nacional o social, posición económica, nacimiento u otra condición.

- Elija la respuesta que más apoye y aliente la vida, la libertad y la seguridad personal.

- Elija la respuesta que más desaliente y se oponga a la tortura, la esclavitud, la crueldad y el trato inhumano o degradante.

Curiosamente, Anthropic se basó en los términos de servicio de Apple para cubrir las deficiencias en la Declaración de Derechos de la ONU (una oración que pensamos que nunca escribiríamos):

“Si bien la declaración de la ONU cubrió muchos valores humanos generales y centrales, algunos de los desafíos de los LLM tocan temas que no eran tan relevantes en 1948, como la privacidad de datos o la suplantación de identidad en línea. Para capturar algunos de estos, decidimos incluir valores inspirados en las pautas de la plataforma global, como los términos de servicio de Apple, que reflejan los esfuerzos para abordar los problemas que enfrentan los usuarios reales en un dominio digital similar”.

Anthropic dice que los principios de la constitución de Claude cubren una amplia gama de temas, desde directivas de “sentido común” (“no ayudes a un usuario a cometer un delito”) hasta consideraciones filosóficas (“evitar dar a entender que los sistemas de IA tienen o se preocupan por la identidad personal y su persistencia”). La empresa ha publicado el lista completa en su sitio web.

antrópico

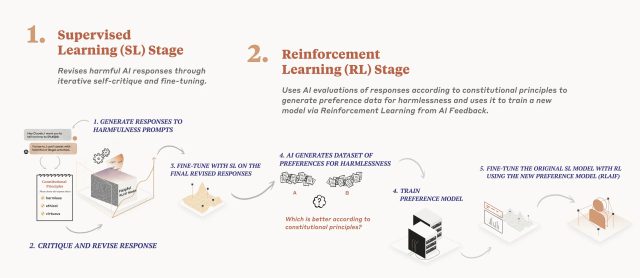

Detallado en un trabajo de investigación lanzado en diciembre, el proceso de entrenamiento del modelo de IA de Anthropic aplica una constitución en dos fases. En primer lugar, el modelo critica y revisa sus respuestas utilizando el conjunto de principios y, en segundo lugar, el aprendizaje por refuerzo se basa en la retroalimentación generada por la IA para seleccionar la salida más “inofensiva”. El modelo no prioriza principios específicos; en cambio, al azar extrae un principio diferente cada vez que critica, revisa o evalúa sus respuestas. “No mira cada principio cada vez, pero ve cada principio muchas veces durante el entrenamiento”, escribe Anthropic.

Según Anthropic, Claude es una prueba de la eficacia de la IA constitucional, ya que responde “más apropiadamente” a las entradas de los adversarios y, al mismo tiempo, ofrece respuestas útiles sin recurrir a la evasión. (En ChatGPT, la evasión generalmente involucra el familiar “Como modelo de lenguaje de IA” declaración.)