El gran avance detrás de los nuevos modelos está en la forma en que se generan las imágenes. La primera versión de DALL-E usó una extensión de la tecnología detrás del modelo de lenguaje GPT-3 de OpenAI, produciendo imágenes al predecir el siguiente píxel en una imagen como si fueran palabras en una oración. Esto funcionó, pero no bien. “No fue una experiencia mágica”, dice Altman. “Es increíble que haya funcionado”.

En cambio, DALL-E 2 usa algo llamado modelo de difusión. Los modelos de difusión son redes neuronales entrenadas para limpiar imágenes eliminando el ruido pixelado que agrega el proceso de entrenamiento. El proceso implica tomar imágenes y cambiar algunos píxeles en ellas a la vez, en muchos pasos, hasta que las imágenes originales se borran y solo te quedan píxeles aleatorios. “Si haces esto mil veces, eventualmente la imagen parecerá que has arrancado el cable de la antena de tu televisor: es solo nieve”, dice Björn Ommer, quien trabaja en IA generativa en la Universidad de Munich en Alemania y quien ayudó a construir el modelo de difusión que ahora impulsa Stable Diffusion.

Luego, la red neuronal se entrena para revertir ese proceso y predecir cómo se vería la versión menos pixelada de una imagen dada. El resultado es que si le das un desorden de píxeles a un modelo de difusión, intentará generar algo un poco más limpio. Vuelva a conectar la imagen limpia y el modelo producirá algo aún más limpio. Haga esto suficientes veces y el modelo puede llevarlo desde la nieve de la televisión hasta una imagen de alta resolución.

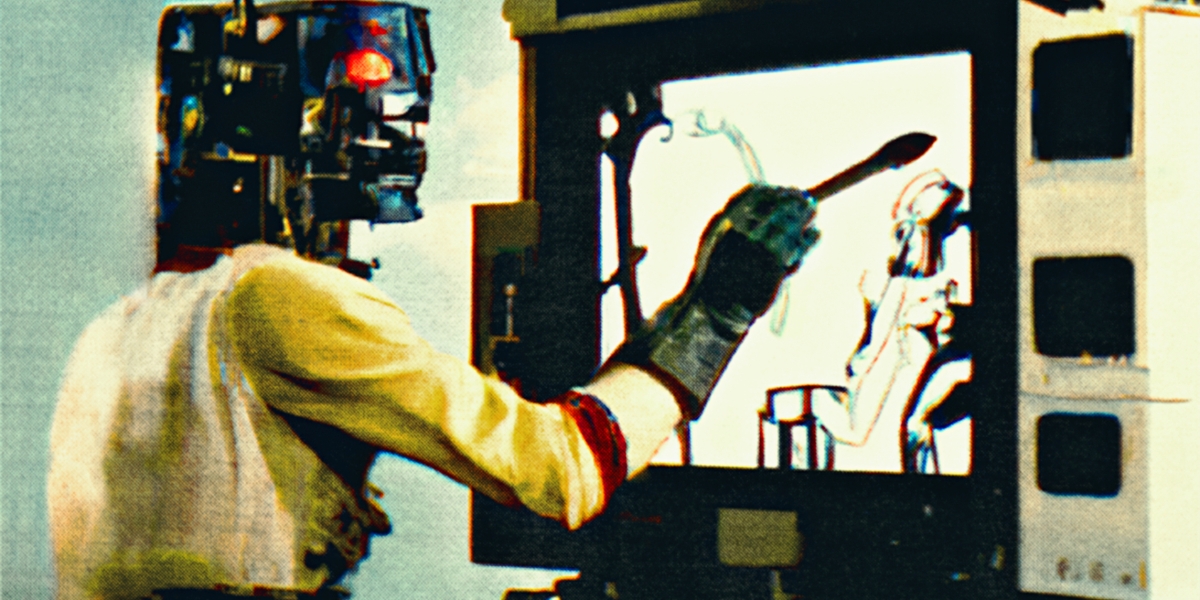

Los generadores de arte de IA nunca funcionan exactamente como usted quiere que lo hagan. A menudo producen resultados espantosos que, en el mejor de los casos, pueden parecerse a obras de arte distorsionadas. En mi experiencia, la única forma de hacer que el trabajo se vea realmente bien es agregar un descriptor al final con un estilo que se vea estéticamente agradable.

~ErikCarter

El truco con los modelos de texto a imagen es que este proceso está guiado por el modelo de lenguaje que intenta hacer coincidir un aviso con las imágenes que produce el modelo de difusión. Esto empuja el modelo de difusión hacia imágenes que el modelo de lenguaje considera una buena combinación.

Pero los modelos no están extrayendo los vínculos entre el texto y las imágenes de la nada. La mayoría de los modelos de texto a imagen actuales están entrenados en un gran conjunto de datos llamado LAION, que contiene miles de millones de pares de texto e imágenes extraídos de Internet. Esto significa que las imágenes que obtienes de un modelo de texto a imagen son una destilación del mundo tal como se representa en línea, distorsionado por los prejuicios (y la pornografía).

Una última cosa: hay una pequeña pero crucial diferencia entre los dos modelos más populares, DALL-E 2 y Stable Diffusion. El modelo de difusión de DALL-E 2 funciona en imágenes de tamaño completo. La difusión estable, por otro lado, utiliza una técnica llamada difusión latente, inventada por Ommer y sus colegas. Funciona en versiones comprimidas de imágenes codificadas dentro de la red neuronal en lo que se conoce como espacio latente, donde solo se conservan las características esenciales de una imagen.

Esto significa que Stable Diffusion requiere menos potencia informática para funcionar. A diferencia de DALL-E 2, que se ejecuta en los potentes servidores de OpenAI, Stable Diffusion puede ejecutarse en (buenas) computadoras personales. Gran parte de la explosión de la creatividad y el rápido desarrollo de nuevas aplicaciones se debe al hecho de que Stable Diffusion es de código abierto (los programadores son libres de cambiarlo, desarrollarlo y ganar dinero con él) y lo suficientemente liviano para que la gente lo ejecute. en casa.

Redefiniendo la creatividad

Para algunos, estos modelos son un paso hacia la inteligencia artificial general, o AGI, una palabra de moda exagerada que se refiere a una futura IA que tiene habilidades de propósito general o incluso similares a las humanas. OpenAI ha sido explícito sobre su objetivo de lograr AGI. Por esa razón, a Altman no le importa que DALL-E 2 ahora compita con una gran cantidad de herramientas similares, algunas de ellas gratuitas. “Estamos aquí para hacer AGI, no generadores de imágenes”, dice. “Encajará en una hoja de ruta de productos más amplia. Es un elemento pequeño de lo que hará un AGI”.