En la gran y larga lista de ideas desagradables, la posibilidad de entablar conversaciones “divertidas e interactivas” con AI Hitler podría no llegar a la cima. Pero podría decirse que está ahí arriba.

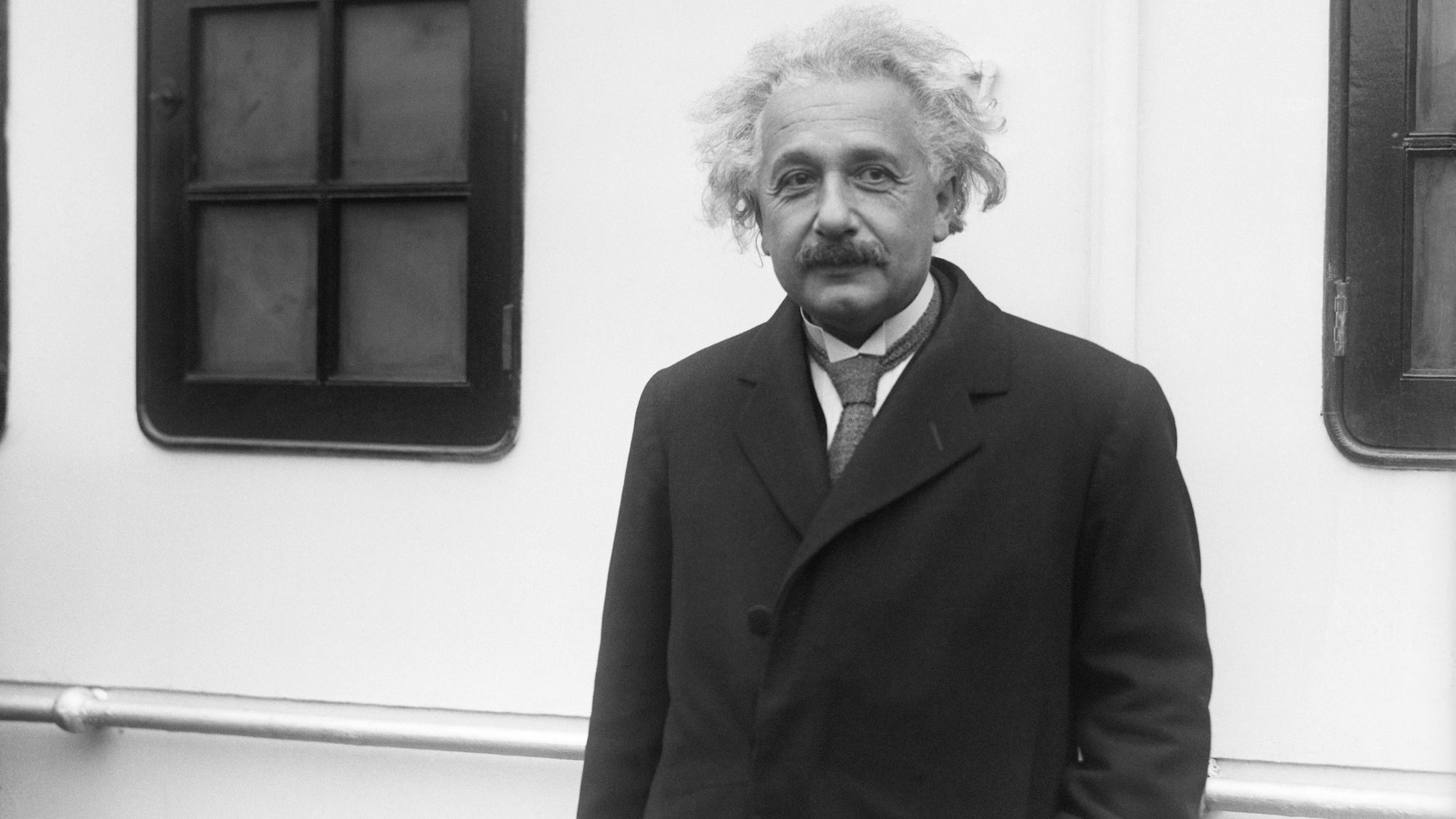

Y, sin embargo, innumerables personas ya lo han intentado a través de la aplicación de chatbot. Personajes historicos. El proyecto, actualmente todavía disponible en la App Store de Apple, se volvió viral la semana pasada por su lista exhaustiva y con frecuencia controvertida de perfiles de IA, incluidos Gandhi, Einstein, la princesa Diana y Charles Manson. A pesar de que se anuncia a sí misma como una aplicación educativa (la 76 más popular en la categoría, al momento de escribir) apropiada para cualquier persona mayor de 9 años, los críticos rápidamente ridiculizado la idea como apresurada, truco frecuentemente inexacto en el mejor y en el peor, un apalancamiento cínico del floreciente, ya cargado tecnología que es ChatGPT.

[Related: Building ChatGPT’s AI content filters devastated workers’ mental health, says new report.]

Incluso sidhant chadhael ingeniero de desarrollo de software de Amazon de 25 años que creó la aplicación, concedió a Piedra rodante

Algunos historiadores se hacen eco con vehemencia de ese sentimiento, incluyendo Ekaterina Babintseva, profesor asistente especializado en Historia de la Tecnología en la Universidad de Purdue. Para ella, el intento de usar ChatGPT en la educación histórica no solo es de mal gusto, es potencialmente incluso radicalmente dañino.

“Lo primero que pensé cuando se creó ChatGPT fue que, ‘Oh, esto es realmente peligroso'”, cuenta sobre Zoom. Para Babintseva, el peligro en cambio reside menos en preocupaciones de plagio académico

[Related: CEOs are already using ChatGPT to write their emails.]

“ChatGPT ni siquiera explica de dónde proviene este conocimiento. Pone en una caja negra sus fuentes”, dice ella.

Es importante tener en cuenta que OpenAI, el desarrollador detrás de ChatGPT y, por extensión, los derivados de terceros como Figuras históricas, ha hecho mucho de su investigacion y diseños fundacionales disponible para que cualquiera pueda examinar. Sin embargo, obtener una comprensión detallada de los vastos repositorios de texto de Internet que utiliza para entrenar la comprensión de su IA es mucho más complicado. Incluso pedirle a ChatGPT que cite sus fuentes no ofrece nada más específico que “fuentes disponibles públicamente” de las que “podría” extraer, como Wikipedia.

Como tal, los programas como la aplicación Figuras históricas de Chaddha proporcionan narraciones sesgadas, a veces completamente incorrectas, y tampoco explican cómo se construyó su narrativa en primer lugar. Compare eso con los artículos académicos históricos y el periodismo cotidiano, repletos de citas de fuentes, notas al pie y rastros de papel. “Hay historias. No hay una sola narrativa”, dice Babintseva. “Las narrativas únicas solo existen en los estados totalitarios, porque realmente están interesados en producir una narrativa y disminuir las narrativas de aquellos que quieren producir narrativas que divergen de la línea del partido aprobada”.

No siempre fue así. Hasta finales de los 90, la investigación en inteligencia artificial se centró en “IA explicable”, con creadores que se centran en cómo los expertos humanos, como psicólogos, genetistas y médicos, toman decisiones. Sin embargo, a fines de la década de 1990, los desarrolladores de IA comenzaron a alejarse de esta filosofía, considerándola en gran medida irrelevante para sus objetivos reales. En cambio, optaron por buscar redes neuronales, que a menudo llegan a conclusiones que incluso sus propios diseñadores no pueden explicar por completo.

[Related: Youth mental health service faces backlash after experimenting with AI-chatbot advice.]

Babintseva y otros estudiosos de estudios de ciencia y tecnología instan a volver a los modelos explicables de IA, al menos para los sistemas que tienen efectos reales en la vida y el comportamiento humanos. La IA debería ayudar a la investigación y al pensamiento humano, no reemplazarlo, dice, y espera que organizaciones como la Fundación Nacional de Ciencias impulsen becas y programas de subvenciones que conduzcan a la investigación en esta dirección.

Hasta entonces, es probable que sigan apareciendo aplicaciones como Figuras históricas, todas basadas en una lógica turbia y fuentes poco claras mientras se anuncian como alternativas educativas nuevas e innovadoras. Lo que es peor, programas como ChatGPT seguirán dependiendo de la mano de obra humana para producir las bases del conocimiento sin siquiera reconocer esas voces. “Representa este conocimiento como una especie de voz de IA única y misteriosa”, dice Babintseva, en lugar de un producto de múltiples experiencias y entendimientos humanos complejos.

[Related: This AI verifies if you actually LOL.]

Al final, los expertos advierten que las figuras históricas deben verse como nada más que el último truco de salón digital. Douglas Rushkoff, un futurista preeminente y autor más reciente de Supervivencia de los más ricos: fantasías de escape de los multimillonarios tecnológicos, trató de encontrar un revestimiento artificial plateado para la aplicación en un correo electrónico a Heaven32. “Bueno, prefiero usar la IA para… probar ideas en personas muertas [rather] que reemplazar a los vivos. Al menos eso es algo que no podemos hacer de otra manera. Pero la elección de los personajes parece más diseñada para generar noticias que para brindarle a la gente una experiencia directa de Hitler”, escribe.

“Y, viendo que me enviaste un correo electrónico para un comentario, ¡parece que el truco ha funcionado!”