¿Alguna vez ha ignorado a un abogado de LinkedIn aparentemente al azar y se ha quedado con la extraña sensación de que algo en el perfil simplemente parecía… fuera de lugar? Bueno, resulta que, en algunos casos, esos los representantes de ventas que lo acosan pueden no ser seres humanos en absoluto. Sí, generado por IA falsificaciones profundas han venido por LinkedIn y les gustaría conectarse.

Eso es según una investigación reciente Renée DiResta del Observatorio de Internet de Stanford detallada en un reciente NPR informe. DiResta, que se hizo un nombre caminando a través de torrentes de contenido de desinformación ruso a raíz de las elecciones de 2016, dijo que se dio cuenta de un aparente fenómeno de imágenes de perfil de LinkedIn falsas generadas por computadora por IA después de que una cuenta de aspecto particularmente extraño intentara conectarse con ella. El usuario, que supuestamente trató de convencer a DiResta de una pieza de software sin importancia, usó una imagen con extrañas incongruencias que le llamaron la atención. como extraño para una foto corporativa. En particular, DiResta dice que notó que los ojos de las figuras estaban perfectamente alineados en el medio de la imagen, un signo revelador de imágenes generadas por IA. Siempre miren a los ojos, compañeros humanos.

“La cara me llamó la atención como falsa”, dijo DiResta a NPR.

A partir de ahí, DiResta y su colega de Stanford, Josh Goldstein, llevaron a cabo una investigación que arrojó más de 1000 cuentas de LinkedIn utilizando imágenes que, según dicen, parecen haber sido creadas por una computadora. Aunque gran parte de la conversación pública en torno a las falsificaciones profundas ha advertido sobre el peligroso potencial de la tecnología para la desinformación política, DiResta dijo que las imágenes, en este caso, parecen abrumadoramente diseñadas para funcionar más como lacayos de ventas y estafas. Según los informes, las empresas usan las imágenes falsas para jugar con el sistema de LinkedIn, creando cuentas alternativas para enviar ventas. lanzamientos para evitar toparse con los límites de mensajes de LinkedIn, señala NPR.

“No es una historia de información errónea o desinformación, sino más bien la intersección de un caso de uso comercial bastante mundano con tecnología de inteligencia artificial y las cuestiones resultantes de ética y expectativas”, escribió DiResta en un Tweet. “¿Cuáles son nuestras suposiciones cuando nos encontramos con otros en las redes sociales? ¿Qué acciones cruzan la línea de la manipulación?

LinkedIn no respondió de inmediato a la solicitud de comentarios de Gizmodo, pero le dijo a NPR que había investigado y eliminado cuentas que violaban sus políticas sobre el uso de imágenes falsas.

“Nuestras políticas dejan en claro que cada perfil de LinkedIn debe representar a una persona real”, dijo un portavoz de LinkedIn a NPR. “Actualizamos constantemente nuestras defensas técnicas para identificar mejor los perfiles falsos y eliminarlos de nuestra comunidad, como lo hemos hecho en este caso”.

Creadores de Deepfake: ¿Dónde está el infierno de desinformación que nos prometieron?

Expertos en desinformación y comentaristas políticos advertido un tipo de falsificación profunda distopía durante años, pero los resultados del mundo real han sido, al menos por ahora, menos impresionantes. Internet se cautivó brevemente el año pasado con este video falso de TikTok presentando alguien que fingía ser Tom Cruise, aunque muchos usuarios pudieron detectar la falta de humanidad de inmediato. Esta y otras falsificaciones profundas populares (como Éste supuestamente protagonizada por Jim Carey en el resplandor, o Éste que representa una oficina llena de clones de Michael Scott) presenta un contenido claramente satírico y relativamente inocuo que no suena del todo los, “Peligro para la democraciaalarma.

Sin embargo, otros casos recientes han tratado de profundizar en el pantano político. Anterior vídeos, por ejemplo, han demostrado cómo los creadores pudieron manipular un video del expresidente Barack Obama para decir oraciones que en realidad nunca pronunció. Luego, a principios de este mes, un falso video

Deepfakes, incluso los de tendencia política, definitivamente están aquí, pero las preocupaciones de la sociedad sobre las imágenes atrofiadas aún no se han hecho realidad, un aparente fastidio que hace que algunos comentaristas posteriores a las elecciones de EE. UU. se pregunten: “¿Dónde están los deepfakes en esta elección presidencial?”

Los humanos están empeorando al detectar imágenes falsas

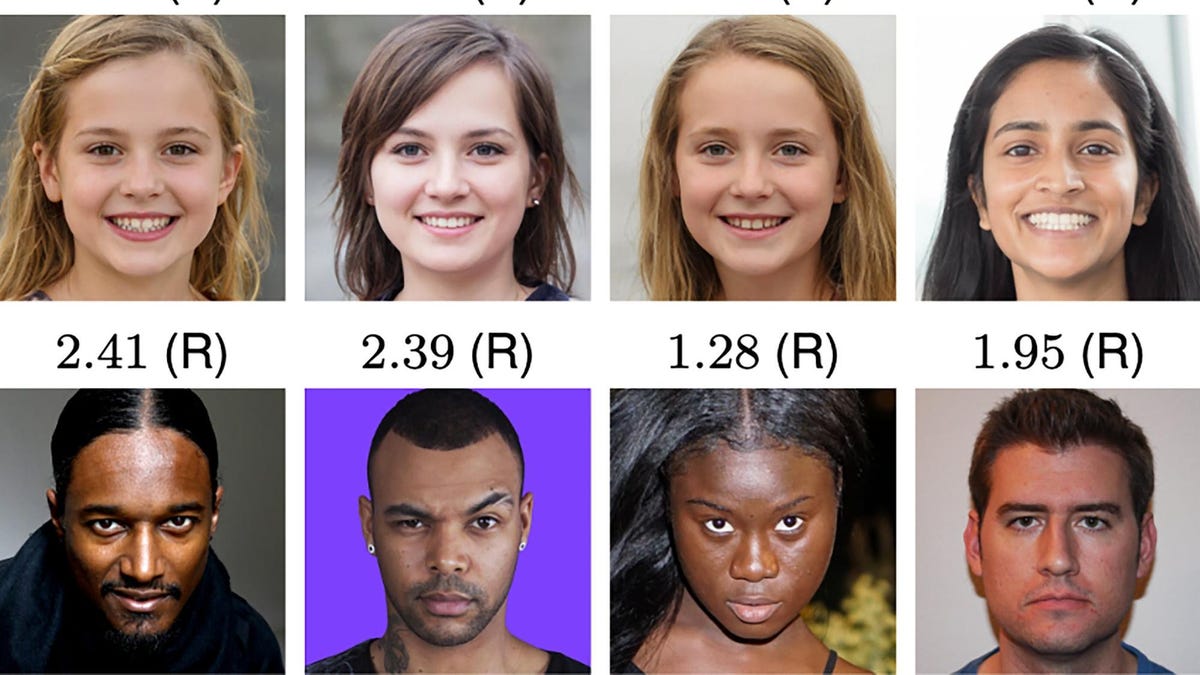

Aún así, hay una buena razón para creer que todo eso podría cambiar… eventualmente. Un estudio reciente publicado en las Actas de la Academia Nacional de Ciencias se encontró que los rostros generados por computadora (o “sintetizados”) en realidad se consideraban más confiables que las fotografías de personas reales. Para el estudio, los investigadores reunieron 400 rostros reales y generaron otros 400, extremadamente realistas. disparos a la cabeza mediante redes neuronales. Los investigadores utilizaron 128 de estas imágenes y probó a un grupo de participantes para ver si podían diferenciar entre una imagen real y una falsa. Se pidió a un grupo separado de encuestados que juzgaran qué tan confiables veían las caras sin insinuar que algunas de las imágenes no eran humanas en absoluto.

Los resultados no son un buen augurio para Team Human. En la primera prueba, los participantes solo pudieron identificar correctamente si una imagen era real o generada por computadora el 48,2% de las veces. Mientras tanto, el grupo de calificación de confiabilidad le dio a los rostros de IA una puntuación de confiabilidad más alta (4.82) que a los rostros humanos (4.48).

“El fácil acceso a imágenes falsas de tan alta calidad ha provocado y seguirá provocando varios problemas, incluidos perfiles falsos en línea más convincentes y, a medida que la generación de audio y video sintético continúa mejorando, problemas de imágenes íntimas no consensuadas, fraude y campañas de desinformación. ”, escribieron los investigadores. “Por lo tanto, alentamos a quienes desarrollan estas tecnologías a considerar si los riesgos asociados son mayores que sus beneficios”.

Vale la pena tomar en serio esos resultados y plantean la posibilidad de cierta incertidumbre pública significativa en torno a las falsificaciones profundas que corren el riesgo de abrir una caja de pandora de nuevas preguntas complicadas sobre la autenticidad, los derechos de autor, la desinformación política y la “T” mayúscula. verdad en los años y décadas venideros.

Sin embargo, a corto plazo, las fuentes más importantes de contenido políticamente problemático pueden no provenir necesariamente de deepfakes altamente avanzados impulsados por IA, sino más bien de los llamados “falsificaciones baratas” que puede manipular los medios con un software mucho menos sofisticado, o ninguno en absoluto. Ejemplos de estos incluyen un video viral de 2019 exposición una Nancy Pelosi supuestamente martillada arrastrando las palabras (ese video en realidad solo se ralentizó un 25%) y este de un aspirante a torpe Joe Biden tratando de vender seguros de automóviles estadounidenses. Ese caso era en realidad solo un hombre mal suplantando la voz del presidente doblada sobre el video real. Si bien esos son tremendamente menos sexys que algunos deepfake del Cinta para orinar de Trumpambos ganaron una gran cantidad de atención en línea.