Ars Technica

El jueves, investigadores de Google anunciaron un nuevo modelo generativo de IA llamado MúsicaLM que puede crear audio musical de 24 KHz a partir de descripciones de texto, como “una melodía relajante de violín respaldada por un riff de guitarra distorsionado”. También puede transformar una melodía tarareada en un estilo musical diferente y reproducir música durante varios minutos.

MusicLM usa un modelo de IA entrenado en lo que Google llama “un gran conjunto de datos de música sin etiquetar”, junto con subtítulos de MusicCaps, un nuevo conjunto de datos compuesto por 5521 pares de música y texto. MusicCaps obtiene sus descripciones de texto de expertos humanos y sus clips de audio correspondientes de Google. Conjunto de audiouna colección de más de 2 millones de clips de sonido de 10 segundos etiquetados extraídos de videos de YouTube.

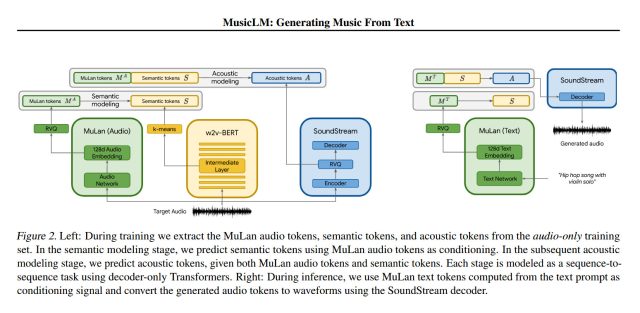

En términos generales, MusicLM funciona en dos partes principales: primero, toma una secuencia de tokens de audio (piezas de sonido) y los asigna a tokens semánticos (palabras que representan significado) en subtítulos para entrenamiento. La segunda parte recibe subtítulos del usuario y/o audio de entrada y genera tokens acústicos (piezas de sonido que componen la salida de la canción resultante). El sistema se basa en un modelo de IA anterior llamado AudioLM (introducido por Google en septiembre) junto con otros componentes como flujo de sonido y MuLan.

Google afirma que MusicLM supera anterior Generadores de música AI en calidad de audio y adherencia a descripciones de texto. En el MusicLM página de demostración, Google proporciona numerosos ejemplos del modelo de IA en acción, creando audio a partir de “subtítulos enriquecidos” que describen la sensación de la música e incluso las voces (que hasta ahora son un galimatías). Aquí hay un ejemplo de una leyenda enriquecida que proporcionan:

Canción de reggae de tempo lento, bajo y batería. Guitarra eléctrica sostenida. Bongos agudos con tonos de llamada. Las voces son relajadas con una sensación relajada, muy expresiva.

Google también muestra la “generación larga” de MusicLM (que crea clips de música de cinco minutos a partir de un mensaje simple), el “modo historia” (que toma una secuencia de mensajes de texto y los convierte en una serie cambiante de melodías musicales), “texto y melodía”. acondicionado” (que toma una entrada de audio humana que tararea o silba y la cambia para que coincida con el estilo establecido en un aviso), y genera música que coincide con el estado de ánimo de los subtítulos de las imágenes.

Investigación de Google

Más abajo en la página de ejemplo, Google se sumerge en la capacidad de MusicLM para recrear instrumentos particulares (por ejemplo, flauta, violonchelo, guitarra), diferentes géneros musicales, varios niveles de experiencia musical, lugares (escapar de prisión, gimnasio), períodos de tiempo (un club en la década de 1950), y más.

La música generada por IA no es una idea nueva de ninguna manera, pero los métodos de generación de música de IA de décadas anteriores a menudo creaban notación musical que luego se tocaba a mano o mediante un sintetizador, mientras que MusicLM genera las frecuencias de audio sin procesar de la música. Además, en diciembre, cubrimos Riffusion, un proyecto de IA de pasatiempo que puede crear música de manera similar a partir de descripciones de texto, pero no con alta fidelidad. Google hace referencia a Riffusion en su MusicLM artículo académicodiciendo que MusicLM lo supera en calidad.

En el artículo de MusicLM, sus creadores describen los impactos potenciales de MusicLM, incluida la “apropiación indebida potencial de contenido creativo” (es decir, problemas de derechos de autor), sesgos potenciales para las culturas subrepresentadas en los datos de capacitación y problemas potenciales de apropiación cultural. Como resultado, Google enfatiza la necesidad de trabajar más para abordar estos riesgos y está reteniendo el código: “No tenemos planes de lanzar modelos en este momento”.

Los investigadores de Google ya están mirando hacia futuras mejoras: “El trabajo futuro puede centrarse en la generación de letras, junto con la mejora del acondicionamiento del texto y la calidad vocal. Otro aspecto es el modelado de la estructura de la canción de alto nivel, como la introducción, el verso y el coro. Modelando el la música a una frecuencia de muestreo más alta es un objetivo adicional”.

Probablemente no sea demasiado exagerado sugerir que los investigadores de IA continuarán mejorando la tecnología de generación de música hasta que cualquiera pueda crear música con calidad de estudio en cualquier estilo simplemente describiéndola, aunque nadie puede predecir exactamente cuándo se logrará ese objetivo o cómo. exactamente tendrá un impacto en la industria de la música. Estén atentos para más desarrollos.