Pista

En un tuit publicado esta mañana, la empresa de inteligencia artificial Runway se burló de una nueva característica de su web basada en inteligencia artificial editor de video que puede editar videos a partir de descripciones escritas, a menudo llamadas “indicaciones”. Un video promocional parece mostrar los primeros pasos hacia la edición o generación de videos comerciales, haciéndose eco de la exageración sobre los modelos recientes de síntesis de texto a imagen como Stable Diffusion pero con un marco optimista para cubrir las limitaciones actuales.

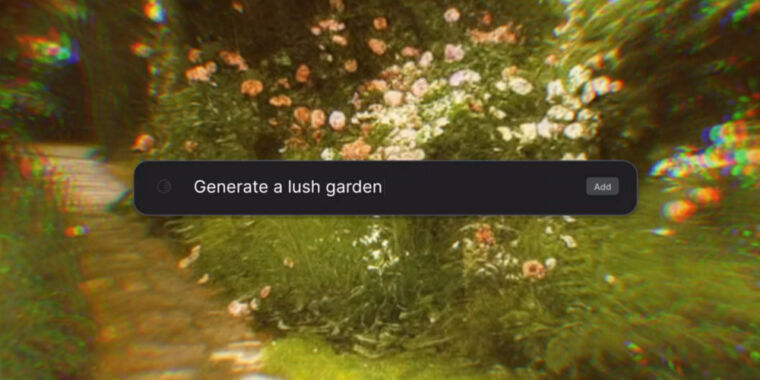

El carrete de demostración “Texto a video” de Runway muestra un cuadro de entrada de texto que permite editar comandos como “importar calle de la ciudad” (sugiriendo que el videoclip ya existía) o “hacer que se vea más cinematográfico” (aplicando un efecto). Representa a alguien escribiendo “eliminar objeto” y seleccionando una farola con una herramienta de dibujo que luego desaparece (según nuestras pruebas, Runway ya puede realizar un efecto similar usando su herramienta “repintar”, con resultados mixtos). El video promocional también muestra lo que parece ser una generación de texto a imagen de imagen fija similar a Stable Diffusion (tenga en cuenta que el video no muestra ninguna de estas escenas generadas en movimiento) y demuestra la superposición de texto, el enmascaramiento de caracteres (usando su “pantalla verde”). ” característica, también ya presente en Runway), y más.

Dejando a un lado las promesas de generación de video, lo que parece más novedoso sobre el anuncio Text to Video de Runway es la interfaz de comando basada en texto. Queda por ver si los editores de video querrán trabajar con indicaciones de lenguaje natural en el futuro, pero la demostración muestra que las personas en la industria de producción de video están trabajando activamente hacia un futuro en el que sintetizar o editar video es tan fácil como escribir un comando.

Ars Technica

La generación de video sin procesar basada en IA (a veces llamada “text2video”) se encuentra en un estado primitivo debido a sus altas demandas computacionales y la falta de un gran conjunto de entrenamiento de video abierto con metadatos que puedan entrenar modelos de generación de video equivalentes a LAION-5B para imágenes fijas. Uno de los modelos text2video públicos más prometedores, llamado CogVideo, puede generar videos simples en baja resolución con velocidades de cuadro entrecortadas. Pero considerando el estado primitivo de los modelos de texto a imagen hace apenas un año versus Este Diaparece razonable esperar que la calidad de la generación de video sintético aumente a pasos agigantados en los próximos años.

Runway está disponible como un producto comercial basado en la web que se ejecuta en el navegador Google Chrome por una tarifa mensual, que incluye almacenamiento en la nube por aproximadamente $35 por año. Pero la función Texto a video está en prueba cerrada de “Acceso anticipado”, y puede inscribirse en la lista de espera en sitio web de la pista.