La última investigación de OpenAI Pusieron a sus agentes de aprendizaje automático en un simple juego de escondite, donde persiguieron una carrera armamentista de ingenio, utilizando objetos de formas inesperadas para lograr su objetivo de ver o ser vistos. Este tipo de IA autodidacta también podría resultar útil en el mundo real.

El estudio pretendía, y con éxito, investigó la posibilidad de que los agentes de aprendizaje automático aprendieran técnicas sofisticadas y relevantes para el mundo real sin ninguna interferencia de sugerencias de los investigadores.

Las tareas como identificar objetos en fotos o inventar rostros humanos plausibles son difíciles y útiles, pero en realidad no reflejan acciones que uno podría tomar en un mundo real. Podrían decir que son altamente intelectuales y, como consecuencia, pueden alcanzar un alto nivel de efectividad sin tener que abandonar la computadora.

Considerando que intentar entrenar a una IA para que use un brazo robótico para agarrar una taza y ponerla en un platillo es mucho más difícil de lo que uno podría imaginar (y solo se ha logrado en circunstancias muy específicas); La complejidad del mundo real y físico hace que el aprendizaje de las tareas sea puramente intelectual e informático.

Al mismo tiempo, hay tareas intermedias que no necesariamente reflejan el mundo real por completo, pero que aún pueden ser relevantes para él. Una simple podría ser cómo cambiar la cara de un robot cuando se le presentan múltiples objetos o personas relevantes. No necesita mil pruebas físicas para saber que debe girar solo o la cámara para que pueda ver ambas, o cambiar entre ellas, o lo que sea.

OpenAI El desafío de esconder y buscar a sus pequeños agentes de ML fue en este sentido: un entorno de juego con reglas simples (llamado Polyworld) que, sin embargo, utiliza datos e información física adyacentes del mundo real. Si los AI pueden aprender a navegar esta realidad simplificada, tal vez puedan transferir esas habilidades, con alguna modificación, a la realidad en toda regla.

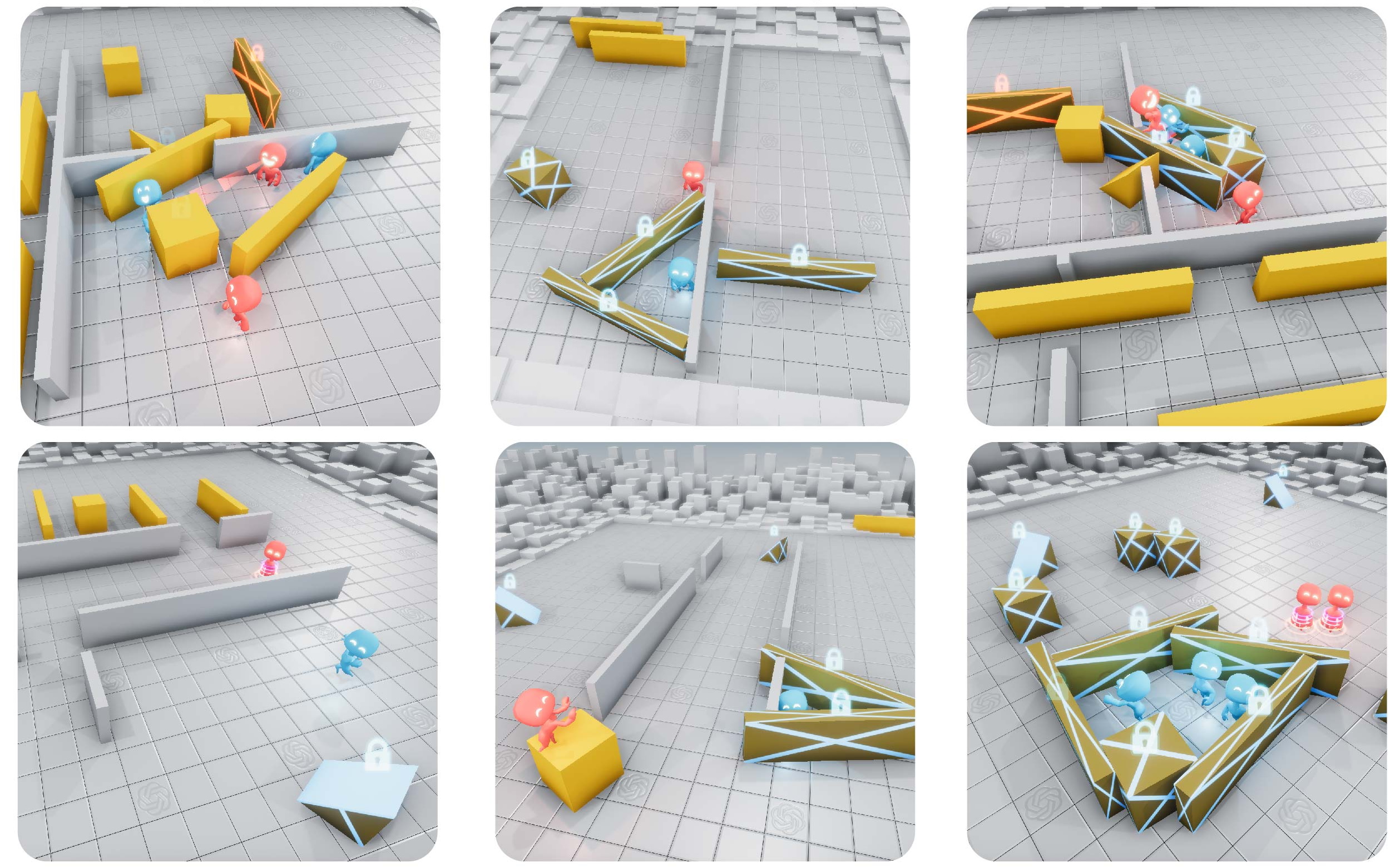

Tal es el pensamiento detrás del experimento, de todos modos, pero es lo suficientemente entretenido por sí solo. El juego enfrenta a dos equipos uno contra el otro en una pequeña arena 3D poblada con algunas paredes y objetos generados al azar. En él aparecen varios agentes y a los "ocultadores" se les dan unos segundos para familiarizarse con el entorno y esconderse. También pueden interactuar con los objetos, empujarlos y bloquearlos en su lugar. Una vez que el "buscador" mira hacia arriba, tiene un cierto tiempo para detectar los escondites.

Todo el programa de aprendizaje automático fue informado sobre los sentidos básicos: cada agente tiene una visión del mundo y una especie de "lidar" para decirles las posiciones de los objetos cercanos, y el conocimiento de que pueden mover objetos. Pero más allá de eso, simplemente se les dio un punto cuando tuvieron éxito en su trabajo, ya sea buscando u ocultándose, esa es su motivación.

De estos principios básicos surgieron resultados maravillosamente interesantes. Al principio, los equipos esencialmente se movieron al azar. Pero a lo largo de millones de juegos, los escondites descubrieron que al moverse de una manera determinada, huyendo "crudamente", podían aumentar sus puntos con mayor frecuencia. Y así comenzó la carrera armamentista.

Como los escondites se estaban escapando, los buscadores comenzaron a desarrollar comportamientos de búsqueda más estructurados. Pero luego vinieron las herramientas.

Hiders descubrió que podían empujar y tirar objetos en el campo, y comenzaron a construir fortalezas con ellos.

Los buscadores respondieron usando rampas encontradas en el campo para ascender sobre los objetos y estrellar los fuertes.

Hiders comenzó a buscar rampas mientras los buscadores seguían contando y robándolas o encerrándolas en su lugar (un agente del equipo contrario no puede abrir la cerradura). Curiosamente, esto implicó una cierta división del trabajo, porque a menudo no había suficiente tiempo para que ambos escondites salieran en busca de rampas; uno tenía que preparar el fuerte mientras el otro iba a patrullar en rampa.

El equipo de OpenAI pensó que tal vez ese era el final, pero los buscadores aprendieron a explotar una característica no deseada del mundo del juego. Descubrieron que podían "empujar" una caja mientras viajaban sobre ella, lo que significa que podían ponerla cerca de una rampa, subir a ella, luego "surfearla" por todo el campo y encontrar esos escondites traviesos.

Por supuesto, los ocultadores respondieron bloqueando cada objeto que no estaban usando para construir su fortaleza, y ese parece ser el final de la línea en cuanto a estrategia en este juego.

¿Entonces cuál es el punto? Como explican los autores del artículo, esta es la forma en que nosotros peleó.

La gran cantidad de complejidad y diversidad en la Tierra evolucionó debido a la coevolución y la competencia entre organismos, dirigida por la selección natural. Cuando surge una nueva estrategia o mutación exitosa, cambia la distribución implícita de tareas que los agentes vecinos deben resolver y crea una nueva presión para la adaptación. Estas carreras armamentistas evolutivas crean auto currículos implícitos mediante los cuales los agentes competidores crean continuamente nuevas tareas entre sí.

Inducir autocurricula en entornos físicamente conectados y abiertos podría eventualmente permitir a los agentes adquirir una cantidad ilimitada de habilidades relevantes para los humanos.

En otras palabras, hacer que los modelos de IA compitan de manera no supervisada puede ser una forma mucho mejor de desarrollar habilidades útiles y sólidas que dejar que jueguen solos, acumulando un número abstracto como porcentaje del entorno explorado o similar.

Cada vez es más difícil o incluso imposible para los humanos dirigir cada aspecto de las habilidades de una IA al parametrizarlo y controlar las interacciones que tiene con el entorno. Para tareas complejas como un robot que navega en un entorno abarrotado, hay tantos factores que hacer que los humanos diseñen comportamientos nunca produzca el tipo de sofisticación necesaria para que estos agentes tomen su lugar en la vida cotidiana.

Pero pueden enseñarse mutuamente, como hemos visto aquí y en las GAN, donde un par de IA en duelo trabajan para derrotar al otro en la creación o detección de medios realistas. Los investigadores de OpenAI afirman que los "autocurricula de múltiples agentes", o agentes de autoaprendizaje, son el camino a seguir en muchas circunstancias donde otros métodos son demasiado lentos o estructurados. Concluyen:

"Estos resultados inspiran la confianza de que en un entorno más abierto y diverso, la dinámica de múltiples agentes podría conducir a un comportamiento extremadamente complejo y relevante para los humanos".

Algunas partes de la investigación se han publicado como código abierto. Usted puede lea el artículo completo que describe el experimento aquí.