La votación de la Ley de IA fue aprobada con una abrumadora mayoría y ha sido anunciada como uno de los desarrollos más importantes del mundo en la regulación de la IA. La presidenta del Parlamento Europeo, Roberta Metsola, lo describió como “legislación que sin duda establecerá el estándar mundial en los años venideros”.

Sin embargo, no contenga la respiración para obtener una claridad inmediata. El sistema europeo es un poco complicado. A continuación, los miembros del Parlamento Europeo tendrán que discutir los detalles con el Consejo de la Unión Europea y el brazo ejecutivo de la UE, la Comisión Europea, antes de que el proyecto de normas se convierta en legislación. La legislación final será un compromiso entre tres borradores diferentes de las tres instituciones, que varían mucho. Es probable que pasen alrededor de dos años antes de que las leyes se implementen realmente.

Lo que se logró con la votación del miércoles fue aprobar la posición del Parlamento Europeo en las próximas negociaciones finales. Con una estructura similar a la Ley de Servicios Digitales de la UE, un marco legal para las plataformas en línea, la Ley de IA adopta un “enfoque basado en el riesgo” al introducir restricciones basadas en cuán peligrosas predicen los legisladores que podría ser una aplicación de IA. Las empresas también deberán presentar sus propias evaluaciones de riesgos sobre el uso de la IA.

Algunas aplicaciones de IA se prohibirán por completo si los legisladores consideran que el riesgo es “inaceptable”, mientras que las tecnologías consideradas de “alto riesgo” tendrán nuevas limitaciones en su uso y requisitos en torno a la transparencia.

Estas son algunas de las principales implicaciones:

- Prohibición de la IA de reconocimiento de emociones. El proyecto de texto del Parlamento Europeo prohíbe el uso de IA que intenta reconocer las emociones de las personas en la policía, las escuelas y los lugares de trabajo. Los fabricantes de software de reconocimiento de emociones afirman que la IA puede determinar cuándo un estudiante no comprende cierto material o cuándo el conductor de un automóvil podría quedarse dormido. El uso de IA para realizar detección y análisis faciales ha sido criticado por su inexactitud y sesgo, pero no ha sido prohibido en el borrador de texto de las otras dos instituciones, lo que sugiere que se avecina una lucha política.

- Prohibición de biometría en tiempo real y vigilancia predictiva en espacios públicos. esto sera un importante batalla legislativa , porque los distintos órganos de la UE tendrán que resolver si la prohibición se aplica por ley y cómo. Los grupos policiales no están a favor de prohibir las tecnologías biométricas en tiempo real, que dicen que son necesarias para la vigilancia moderna. Algunos países, como Francia, son en realidad planean aumentar su uso del reconocimiento facial.

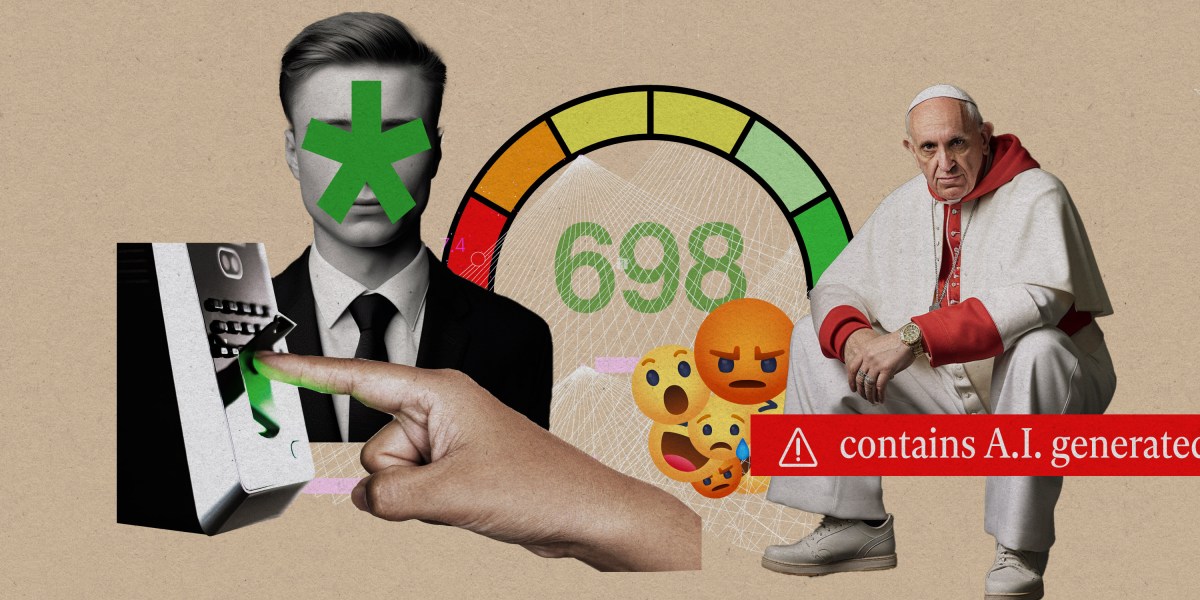

- Prohibición de puntuación social. Se prohibiría la calificación social por parte de las agencias públicas, o la práctica de utilizar datos sobre el comportamiento social de las personas para hacer generalizaciones y perfiles. Dicho esto, la perspectiva de la puntuación social, comúnmente asociada con China y otros gobiernos autoritarios, no es tan simple como parece. La practica de uso de datos de comportamiento social para evaluar a las personas es común en la concesión de hipotecas y la fijación de tarifas de seguros, así como en la contratación y la publicidad.

- Nuevas restricciones para gen AI. Este borrador es el primero en proponer formas de regular la IA generativa y prohibir el uso de cualquier material con derechos de autor en el conjunto de entrenamiento de grandes modelos de lenguaje como GPT-4 de OpenAI. OpenAI ya se encuentra bajo la escrutinio de los legisladores europeos por inquietudes sobre la privacidad de los datos y los derechos de autor. El proyecto de ley también requiere que el contenido generado por IA sea etiquetado como tal. Dicho esto, el Parlamento Europeo ahora tiene que vender su política a la Comisión Europea y a países individuales, que probablemente enfrenten la presión de cabildeo de la industria tecnológica.

- Nuevas restricciones a los algoritmos de recomendación en redes sociales. el nuevo borrador asigna los sistemas de recomendación a una categoría de “alto riesgo”, que es una escalada de los otros proyectos de ley propuestos. Esto significa que, si se aprueba, los sistemas de recomendación en las plataformas de redes sociales estarán sujetos a un escrutinio mucho mayor sobre cómo funcionan, y las empresas de tecnología podrían ser más responsables por el impacto del contenido generado por los usuarios.

Los riesgos de la IA, tal como los describe Margrethe Vestager, vicepresidenta ejecutiva de la Comisión de la UE, están muy extendidos. Ella ha enfatizado las preocupaciones sobre el futuro de la confianza en la información, la vulnerabilidad a la manipulación social por parte de malos actores y la vigilancia masiva.

“Si terminamos en una situación en la que no creemos nada, entonces habremos socavado nuestra sociedad por completo”, Vestager dijo a los periodistas el miércoles.

Lo que estoy leyendo esta semana.

- Un soldado ruso se rindió a un dron de asalto ucraniano, según imágenes de vídeo publicadas por el Wall Street Journal. La rendición tuvo lugar en mayo en la ciudad oriental de Bakhmut, Ucrania. El operador del dron decidió perdonar la vida del soldado, de acuerdo con el derecho internacional, al ver su declaración en video. Los drones han sido fundamentales en la guerra, y la rendición es una mirada fascinante al futuro de la guerra.

- Muchos usuarios de Reddit protestan por los cambios en la API del sitio que eliminarían o reducirían la función de las aplicaciones y herramientas de terceros que utilizan muchas comunidades. En protesta, esas comunidades se han “vuelto privadas”, lo que significa que las páginas ya no son de acceso público. Reddit es conocido por el poder que le da a su base de usuarios, pero la compañía ahora puede estar lamentando eso, según la aguda evaluación de Casey Newton.

- Los trabajadores contratados que capacitaron al modelo de lenguaje grande de Google, Bard, dicen que fueron despedidos después de plantear preocupaciones sobre sus condiciones de trabajo y problemas de seguridad con la propia IA. Los contratistas dicen que se vieron obligados a cumplir plazos irrazonables, lo que generó preocupaciones sobre la precisión. Google dice que la responsabilidad recae en Appen, la agencia contratada que emplea a los trabajadores. Si la historia nos dice algo, habrá un costo humano en la carrera por dominar la IA generativa.

Lo que aprendí esta semana

Esta semana, Human Rights Watch publicó un informe detallado sobre un algoritmo solía repartir beneficios sociales en Jordania. La agencia encontró algunos problemas importantes con el algoritmo, que fue financiado por el Banco Mundial, y dice que el sistema se basó en suposiciones incorrectas y demasiado simplificadas sobre la pobreza. Los autores del informe también denunciaron la falta de transparencia y advirtieron contra proyectos similares del Banco Mundial. Escribí una historia corta sobre los hallazgos.

Mientras tanto, la tendencia hacia el uso de algoritmos en los servicios gubernamentales está creciendo. Elizabeth Renieris, autora de Más allá de los datos: reclamando los derechos humanos en los albores del metaverso, me escribió sobre el informe y enfatizó el impacto que este tipo de sistemas tendrán en el futuro: “A medida que el proceso para acceder a los beneficios se vuelve digital por defecto, es menos probable que estos beneficios lleguen a quienes más los necesitan y solo se profundizan la brecha digital. Este es un excelente ejemplo de cómo la automatización expansiva puede afectar directa y negativamente a las personas, y es la conversación sobre el riesgo de la IA en la que debemos centrarnos ahora”.