Imágenes de Aurich Lawson / Getty

La multiplicación de matrices está en el corazón de muchos avances de aprendizaje automático, y se volvió más rápido, dos veces. La semana pasada, DeepMind Anunciado descubrió una forma más eficiente de realizar la multiplicación de matrices, conquistando un récord de 50 años. Esta semana, dos investigadores austriacos de la Universidad Johannes Kepler de Linz reclamar han superado ese nuevo récord por un paso.

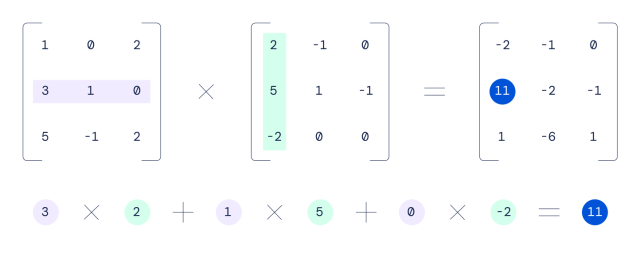

Multiplicación de matrices, que implica multiplicar dos matrices rectangulares de números, a menudo se encuentra en el corazón del reconocimiento de voz, el reconocimiento de imágenes, el procesamiento de imágenes de teléfonos inteligentes, la compresión y la generación de gráficos por computadora. Las unidades de procesami ento de gráficos (GPU) son particularmente buenas para realizar la multiplicación de matrices debido a su naturaleza masivamente paralela. Pueden dividir un gran problema matemático matricial en muchas piezas y atacar partes de él simultáneamente con un algoritmo especial.

En 1969, un matemático alemán llamado Volker Strassen descubierto el mejor algoritmo anterior para multiplicar matrices de 4 × 4, lo que reduce la cantidad de pasos necesarios para realizar un cálculo de matriz. Por ejemplo, multiplicar dos matrices de 4 × 4 usando un método escolar tradicional requeriría 64 multiplicaciones, mientras que el algoritmo de Strassen puede realizar la misma hazaña en 49 multiplicaciones.

Mente profunda

Usando una red neuronal llamada AlphaTensor, DeepMind descubrió una forma de reducir ese conteo a 47 multiplicaciones, y sus investigadores publicó un artículo sobre el logro en Nature la semana pasada.

Pasar de 49 pasos a 47 no parece mucho, pero cuando considera cuántos billones de cálculos matriciales se realizan en una GPU todos los días, incluso las mejoras incrementales pueden traducirse en grandes ganancias de eficiencia, lo que permite que las aplicaciones de IA se ejecuten más rápidamente en las existentes. hardware.

Cuando las matemáticas son solo un juego, la IA gana

AlphaTensor es un descendiente de AlphaGo (que superó al campeón mundial Vamos jugadores en 2017) y AlphaZero, que abordó el ajedrez y el shogi. DeepMind llama a AlphaTensor “el primer sistema de IA para descubrir algoritmos novedosos, eficientes y comprobablemente correctos para tareas fundamentales como la multiplicación de matrices”.

Para descubrir algoritmos matemáticos matriciales más eficientes, DeepMind configuró el problema como un juego para un solo jugador. La empresa escribi sobre el proceso con más detalle en una publicación de blog la semana pasada:

En este juego, el tablero es un tensor tridimensional (matriz de números), que captura qué tan lejos de corregir está el algoritmo actual. A través de un conjunto de movimientos permitidos, correspondientes a las instrucciones del algoritmo, el jugador intenta modificar el tensor y poner a cero sus entradas. Cuando el jugador logra hacerlo, esto da como resultado un algoritmo de multiplicación de matrices demostrablemente correcto para cualquier par de matrices, y su eficiencia se captura por el número de pasos tomados para poner a cero el tensor.

Luego, DeepMind entrenó a AlphaTensor utilizando el aprendizaje por refuerzo para jugar este juego matemático ficticio, similar a cómo AlphaGo aprendió a jugar. Vamos—y fue mejorando gradualmente con el tiempo. Eventualmente, redescubrió el trabajo de Strassen y el de otros matemáticos humanos, luego los superó, según DeepMind.

En un ejemplo más complicado, AlphaTensor descubrió una nueva forma de realizar la multiplicación de matrices de 5×5 en 96 pasos (frente a los 98 del método anterior). Esta semana, Manuel Kauers y Jakob Moosbauer de Johannes Universidad Kepler en Linz, Austria, publicó un artículo alegando que han reducido esa cuenta en uno, hasta 95 multiplicaciones. No es una coincidencia que este nuevo algoritmo aparentemente récord haya llegado tan rápido porque se basó en el trabajo de DeepMind. En su artículo, Kauers y Moosbauer escriben: “Esta solución se obtuvo del esquema de [DeepMind’s researchers] aplicando una secuencia de transformaciones que conducen a un esquema del que se puede eliminar una multiplicación”.

El progreso tecnológico se desarrolla a sí mismo, y con la IA ahora buscando nuevos algoritmos, es posible que otros récords matemáticos de larga data puedan caer pronto. Similar a cómo el diseño asistido por computadora (CANALLA) permitieron el desarrollo de computadoras más complejas y rápidas, la IA puede ayudar a los ingenieros humanos a acelerar su propio despliegue.