Esta historia apareció originalmente en The Algorithm, nuestro boletín semanal sobre IA. Para recibir historias como esta en su bandeja de entrada primero, Registrate aquí.

Si bien EE. UU. y la UE pueden diferir sobre cómo regular la tecnología, sus legisladores parecen estar de acuerdo en una cosa: Occidente debe prohibir la puntuación social impulsada por IA.

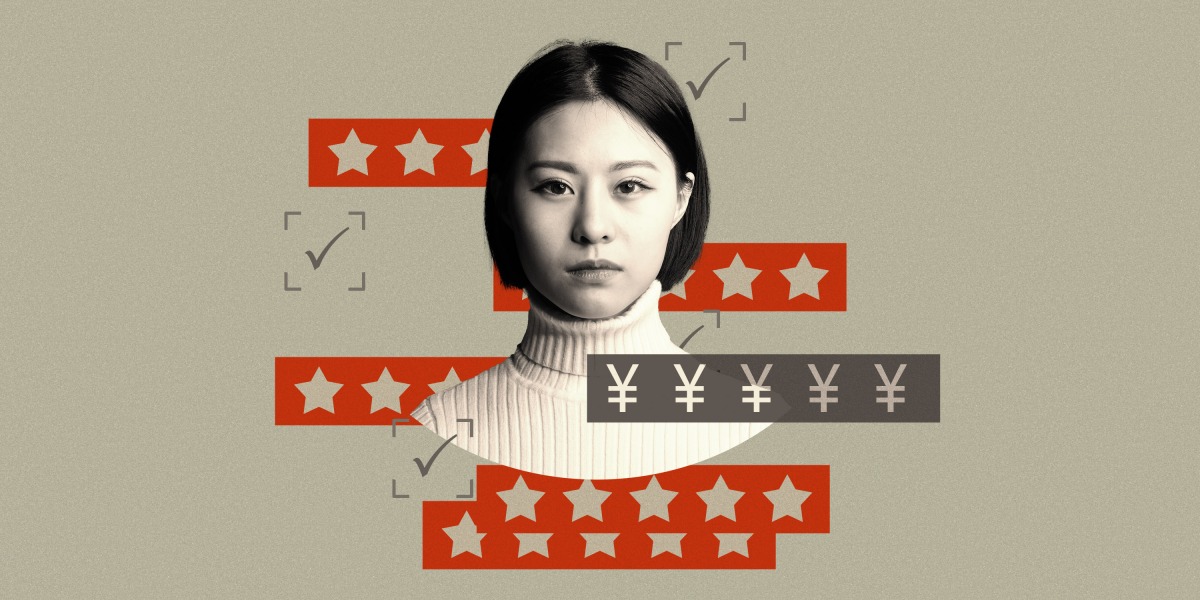

Como ellos comprender Para ello, la puntuación social es una práctica en la que los gobiernos autoritarios, específicamente China, califican la confiabilidad de las personas y las castigan por comportamientos indeseables, como robar o no pagar los préstamos. Esencialmente, se ve como una superpuntuación distópica asignada a cada ciudadano.

La UE está negociando actualmente una nueva ley denominadaLey de IAque prohibirá a los estados miembros, y tal vez incluso a las empresas privadas, implementar dicho sistema.

El problema es que “esencialmente está prohibiendo el aire enrarecido”, dice Vincent Brussee, analista del Instituto Mercator para Estudios de China, un grupo de expertos alemán.

En 2014, China anunció un plan de seis años para construir un sistema que premia las acciones que generan confianza en la sociedad y penaliza lo contrario. Ocho años después, acaba de publicarse un proyecto de ley que trata de codificar los programas piloto de crédito social anteriores y guiar la implementación futura.

Ha habido algunos experimentos locales polémicos, como uno en la pequeña ciudad de Rongcheng en 2013, que le dio a cada residente un puntaje de crédito personal inicial de 1,000 que puede aumentar o disminuir según cómo se juzguen sus acciones. Las personas ahora pueden optar por no participar y el gobierno local ha eliminado algunos criterios controvertidos.

Pero estos no han ganado una tracción más amplia en otros lugares y no se aplican a toda la población china. No existe un sistema de crédito social que todo lo vea en todo el país con algoritmos que clasifiquen a las personas.

Como explica mi colega Zeyi Yang, “la realidad es que ese sistema aterrador no existe, y el gobierno central tampoco parece tener muchas ganas de construirlo”.

Lo que se ha implementado es en su mayoría bastante de baja tecnología. Es una “mezcla de intentos de regular la industria d el crédito financiero, permitir que las agencias gubernamentales compartan datos entre sí y promover valores morales sancionados por el estado”, escribe Zeyi.

Kendra Schaefer, socia de Trivium China, una consultora de investigación con sede en Beijing, quien compiló unareportesobre el tema para el gobierno de EE. UU., no pudo encontrar un solo caso en el que la recopilación de datos en China condujera a sanciones automatizadas sin intervención humana. Correo de la mañana del sur de Chinafundarque en Rongcheng, los “recolectores de información” humanos caminaban por la ciudad y anotaban el mal comportamiento de la gente usando papel y lápiz.

El mito se origina en un programa piloto llamado Sesame Credit, desarrollado por la empresa tecnológica china Alibaba. Este fue un intento de evaluar la solvencia de las personas utilizando los datos de los clientes en un momento en que la mayoría de los chinos no tenían tarjeta de crédito, dice Brussee. El esfuerzo se combinó con el sistema de crédito social en su conjunto en lo que Brussee describe como un “juego de susurros chinos”. Y el malentendido cobró vida propia.

La ironía es que mientras los políticos estadounidenses y europeos describen esto como un problema derivado de los regímenes autoritarios, Los sistemas que clasifican y penalizan a las personas ya existen en Occidente. Los algoritmos diseñados para automatizar las decisiones se están implementando en masa y se utilizan para negar a las personas vivienda, empleo y servicios básicos.

Por ejemplo, en Ámsterdam, las autoridades han utilizado un algoritmo paraclasificar a los jóvenesde barrios desfavorecidos según su probabilidad de convertirse en delincuente. Afirman que el objetivo es prevenir el crimen y ayudar a ofrecer un apoyo mejor y más específico.

Pero en realidad, argumentan los grupos de derechos humanos, ha aumentado la estigmatización y la discriminación. Los jóvenes que terminan en esta lista se enfrentan a más paradas de la policía, visitas domiciliarias de las autoridades y una supervisión más estricta por parte de los trabajadores escolares y sociales.

yoEs fácil oponerse a un algoritmo distópico que en realidad no existe. Pero a medida que los legisladores tanto de la UE como de los EE. UU. se esfuerzan por construir una comprensión compartida de la gobernanza de la IA, harían mejor en mirar más cerca de casa. Los estadounidenses ni siquiera tienen una ley federal de privacidad que ofrezca algunas protecciones básicas contra la toma de decisiones algorítmica.

También existe una gran necesidad de que los gobiernos realicen auditorías honestas y exhaustivas sobre la forma en que las autoridades y las empresas utilizan la IA para tomar decisiones sobre nuestras vidas. Es posible que no les guste lo que encuentren, pero eso hace que sea aún más crucial para ellos buscar.

Aprendizaje más profundo

Un bot que vio 70,000 horas de Minecraft podría desbloquear la próxima gran cosa de AI

La empresa de investigación OpenAI ha creado una IA que se basó en 70,000 horas de videos de personas jugando Minecraft para jugar mejor que cualquier IA anterior. Es un gran avance para una nueva técnica poderosa, llamada aprendizaje por imitación, que podría usarse para entrenar máquinas para llevar a cabo una amplia gama de tareas al observar a los humanos hacerlas primero. También aumenta el potencial de que sitios como YouTube puedan ser una fuente vasta y sin explotar de datos de capacitación.

Por qué es un gran problema: El aprendizaje por imitación se puede utilizar para entrenar a la IA para controlar brazos robóticos, conducir automóviles o navegar por sitios web. Algunas personas, como el científico jefe de IA de Meta, Yann LeCun, piensan que ver videos eventualmente nos ayudará a entrenar una IA con inteligencia a nivel humano. Lea la historia de Will Douglas Heaven aquí.

Bits y bytes

La IA de juego de Meta puede hacer y deshacer alianzas como un humano

Diplomacy es un popular juego de estrategia en el que siete jugadores compiten por el control de Europa moviendo piezas en un mapa. El juego requiere que los jugadores hablen entre sí y detecten cuando otros están mintiendo. La nueva IA de Meta, llamada Cicero, logró engañar a los humanos para ganar.

Es un gran paso adelante hacia la IA que puede ayudar con problemas complejos, como la planificación de rutas en torno al tráfico intenso y la negociación de contratos. Pero no voy a mentir, también es un pensamiento desconcertante que una IA pueda engañar a los humanos con tanto éxito. (Revisión de tecnología del .)

Podríamos quedarnos sin datos para entrenar programas de lenguaje de IA

La tendencia de crear modelos de IA cada vez más grandes significa que necesitamos conjuntos de datos aún más grandes para entrenarlos. El problema es que podríamos quedarnos sin datos adecuados para 2026, según un artículo de investigadores de Epoch, una organización de investigación y pronóstico de IA. Esto debería impulsar a la comunidad de IA a idear formas de hacer más con los recursos existentes. (Revisión de tecnología del .)

La difusión estable 2.0 ya está disponible

La difusión estable de AI de texto a imagen de código abierto ha recibido unagran lavado de cara, y sus resultados se ven mucho más elegantes y realistas que antes. incluso puede hacermanos. El ritmo de desarrollo de Stable Diffusion es impresionante. Su primera versión solo se lanzó en agosto. Es probable que veamos aún más progreso en la IA generativa hasta bien entrado el próximo año.