nvidia

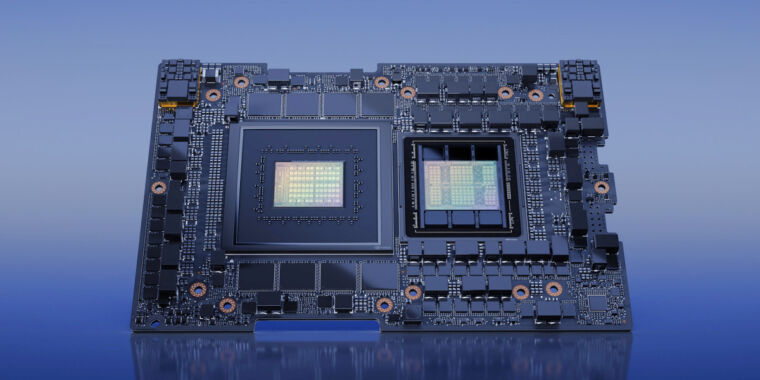

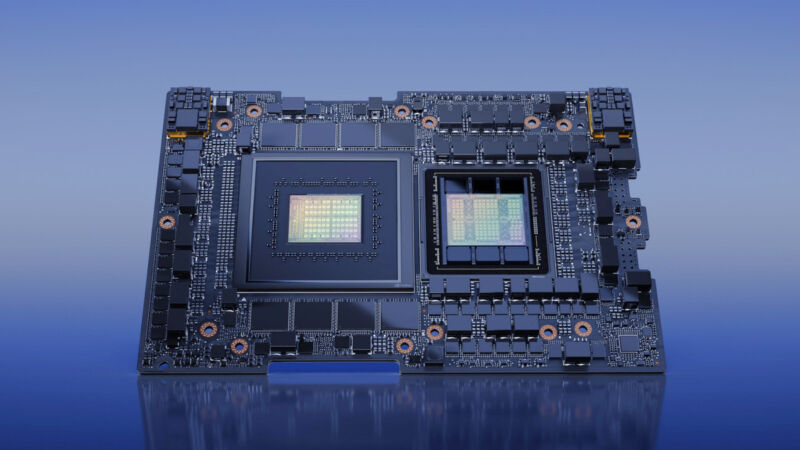

A principios de la semana pasada en COMPUTEX, Nvidia anunció que su nuevo GH200 Grace Hopper “Superchip”—una combinación de CPU y GPU creada específicamente para aplicaciones de IA a gran escala— ha entrado en plena producción. es una bestia Tiene 528 núcleos de tensor de GPU, admite hasta 480 GB de RAM de CPU y 96 GB de RAM de GPU, y cuenta con un ancho de banda de memoria de GPU de hasta 4 TB por segundo.

Anteriormente cubrimos el chip Nvidia H100 Hopper, que actualmente es la GPU de centro de datos más poderosa de Nvidia. Impulsa modelos de IA como ChatGPT de OpenAI, y marcó una mejora significativa con respecto al chip A100 de 2020, que impulsó la primera ronda de carreras de entrenamiento para muchos de los chatbots de IA generativos y generadores de imágenes de los que estamos hablando hoy.

Las GPU más rápidas se traducen aproximadamente en modelos de IA generativos más potentes porque pueden ejecutar más multiplicaciones de matriz en paralelo (y hacerlo más rápido), lo cual es necesario para que funcionen las redes neuronales artificiales actuales.

El GH200 toma esa base “Hopper” y la combina con la de Nvidia “Gracia” Plataforma de CPU (ambas nombradas en honor al pionero de la informática tolva de gracia), convirtiéndolo en un solo chip a través de la tecnología de interconexión de chip a chip (C2C) NVLink de Nvidia. Nvidia espera que la combinación acelere drásticamente las aplicaciones de inteligencia artificial y aprendizaje automático tanto en el entrenamiento (creación de un modelo) como en la inferencia (ejecutarlo).

“La IA generativa está transformando rápidamente los negocios, desbloqueando nuevas oportunidades y acelerando el descubrimiento en el cuidado de la salud, las finanzas, los servicios comerciales y muchas más industrias”, dijo Ian Buck, vicepresidente de computación acelerada de Nvidia, en un comunicado de prensa. “Con Grace Hopper Superchips en plena producción, los fabricantes de todo el mundo pronto proporcionarán la infraestructura acelerada que las empresas necesitan para construir e implementar aplicaciones de IA generativas que aprovechen sus datos patentados únicos”.

Según la compañía, las características clave del GH200 incluyen una nueva interfaz de memoria coherente (compartida) de 900 GB/s, que es siete veces más rápida que PCIe Gen5. El GH200 también ofrece un ancho de banda de memoria del sistema agregado 30 veces mayor a la GPU en comparación con el mencionado Nvidia DGX A100. Además, el GH200 puede ejecutar todas las plataformas de software de Nvidia, incluido el SDK de HPC de Nvidia, Nvidia IAy omniverso de nvidia.

En particular, Nvidia también Anunciado que incorporará este chip combinado de CPU/GPU en una nueva supercomputadora llamada DGX GH200, que puede utilizar la potencia combinada de 256 chips GH200 para funcionar como una sola GPU, proporcionando 1 exaflop de rendimiento y 144 terabytes de memoria compartida, casi 500 veces más memoria que la Nvidia DGX A100 de la generación anterior.

El DGX GH200 será capaz de entrenar modelos gigantes de IA de próxima generación (GPT-6, ¿alguien?) para aplicaciones de lenguaje generativo, sistemas de recomendación y análisis de datos. Nvidia no anunció el precio del GH200, pero según anandtechuna sola computadora DGX GH200 “fácilmente va a costar alrededor de los 8 dígitos bajos”.

En general, es razonable decir que gracias a los continuos avances en hardware de proveedores como Nvidia y Cerebras, es probable que los modelos de inteligencia artificial en la nube de alto nivel continúen siendo más capaces con el tiempo, procesando más datos y haciéndolo mucho más rápido que antes. Esperemos que no discutan con los periodistas tecnológicos.