Investigación de Google

El lunes, un grupo de investigadores de IA de Google y la Universidad Técnica de Berlín dio a conocer Palma-Eun modelo de lenguaje visual incorporado multimodal (VLM) con 562 mil millones parámetros que integra visión y lenguaje para control robótico. Afirman que es el VLM más grande jamás desarrollado y que puede realizar una variedad de tareas sin necesidad de volver a capacitarse.

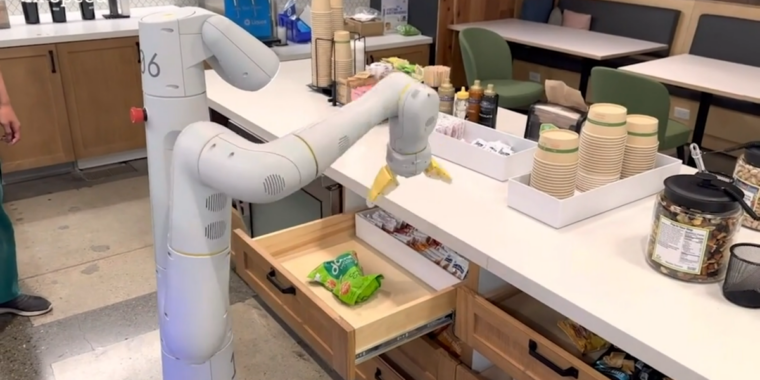

Según Google, cuando se le da un comando de alto nivel, como “tráeme los chips de arroz del cajón”, PaLM-E puede generar un plan de acción para una plataforma de robot móvil con un brazo (desarrollado por Google Robotics) y ejecutar las acciones por sí mismo.

PaLM-E hace esto mediante el análisis de datos de la cámara del robot sin necesidad de una representación de escena preprocesada. Esto elimina la necesidad de que un ser humano preprocese o anote los datos y permite un control robótico más autónomo.

En un video de demostración proporcionado por Google, PaLM-E ejecuta “tráeme los chips de arroz del cajón”, que incluye múltiples pasos de planificación, además de incorporar comentarios visuales de la cámara del robot.

También es resistente y puede reaccionar a su entorno. Por ejemplo, el modelo PaLM-E puede guiar a un robot para obtener una bolsa de papas fritas de una cocina, y con PaLM-E integrado en el circuito de control, se vuelve resistente a las interrupciones que pueden ocurrir durante la tarea. En un ejemplo de video, un investigador agarra las fichas del robot y las mueve, pero el robot localiza las fichas y las toma nuevamente.

En otro ejemplo, el mismo modelo PaLM-E controla de forma autónoma un robot a través de tareas con secuencias complejas que antes requerían la guía humana. de Google trabajo de investigación explica cómo PaLM-E convierte las instrucciones en acciones:

Demostramos el rendimiento de PaLM-E en tareas de manipulación móvil desafiantes y diversas. Seguimos en gran medida la configuración de Ahn et al. (2022), donde el robot necesita planificar una secuencia de acciones de navegación y manipulación basadas en una instrucción de un humano. Por ejemplo, dada la instrucción “Derramé mi bebida, ¿puedes traerme algo para limpiarla?”, el robot necesita planificar una secuencia que contenga “1. Encuentra una esponja, 2. Recoge la esponja, 3. Tráela al usuario, 4. Deje la esponja”. Inspirándonos en estas tareas, desarrollamos 3 casos de uso para probar las capacidades de razonamiento incorporadas de PaLM-E: predicción de disponibilidad, detección de fallas y planificación a largo plazo. Las políticas de bajo nivel son de RT-1 (Brohan et al., 2022), un mo delo de transformador que toma imágenes RGB e instrucción en lenguaje natural, y genera comandos de control de efectores finales.

PaLM-E es un predictor de siguiente token, y se llama “PaLM-E” porque se basa en el modelo de lenguaje grande (LLM) existente de Google llamado “Palmera(que es similar a la tecnología detrás de ChatGPT). Google ha “incorporado” a PaLM al agregar información sensorial y control robótico.

Dado que se basa en un modelo de lenguaje, PaLM-E toma observaciones continuas, como imágenes o datos de sensores, y las codifica en una secuencia de vectores que tienen el mismo tamaño que los tokens de lenguaje. Esto permite que el modelo “entienda” la información sensorial de la misma manera que procesa el lenguaje.

Un video de demostración proporcionado por Google que muestra un robot guiado por PaLM-E siguiendo la instrucción “Tráeme una estrella verde”. Los investigadores dicen que la estrella verde “es un objeto al que este robot no estuvo expuesto directamente”.

Además de Transformador robótico RT-1PaLM-E se basa en el trabajo anterior de Google sobre Vit-22B, un modelo de transformador de visión revelado en febrero. ViT-22B ha sido entrenado en varias tareas visuales, como clasificación de imágenes, detección de objetos, segmentación semántica y subtítulos de imágenes.

Google Robotics no es el único grupo de investigación que trabaja en control robótico con redes neuronales. Este trabajo en particular se parece al reciente artículo “ChatGPT for Robotics” de Microsoft, que experimentó con la combinación de datos visuales y modelos de lenguaje grandes para el control robótico de una manera similar.

Dejando a un lado la robótica, los investigadores de Google observaron varios efectos interesantes que aparentemente provienen del uso de un modelo de lenguaje grande como núcleo de PaLM-E. Por un lado, exhibe una “transferencia positiva”, lo que significa que puede transferir el conocimiento y las habilidades que ha aprendido de una tarea a otra, lo que resulta en un “rendimiento significativamente mayor” en comparación con los modelos de robots de una sola tarea.

Además, ellos observado una tendencia con la escala del modelo: “Cuanto más grande es el modelo de lenguaje, más mantiene sus capacidades de lenguaje cuando se entrena en tareas de lenguaje visual y robótica; cuantitativamente, el modelo 562B PaLM-E casi conserva todas sus capacidades de lenguaje”.

PaLM-E es el VLM más grande reportado hasta la fecha. Observamos capacidades emergentes como la cadena multimodal de razonamiento de pensamiento y la inferencia de múltiples imágenes, a pesar de haber sido entrenados solo con indicaciones de una sola imagen. Aunque no es el enfoque de nuestro trabajo, PaLM-E establece un nuevo SOTA en el punto de referencia OK-VQA. pic.twitter.com/9FHug25tOF

— Danny Driess (@DannyDriess) 7 de marzo de 2023

Y los investigadores afirmar que PaLM-E exhibe capacidades emergentes como razonamiento de cadena de pensamiento multimodal (permitiendo que el modelo analice una secuencia de entradas que incluyen lenguaje e información visual) e inferencia de múltiples imágenes (usando múltiples imágenes como entrada para hacer una inferencia o predicción ) a pesar de haber sido entrenado solo en indicaciones de una sola imagen. En ese sentido, PaLM-E parece continuar la tendencia de sorpresas que surgen a medida que los modelos de aprendizaje profundo se vuelven más complejos con el tiempo.

Los investigadores de Google planean explorar más aplicaciones de PaLM-E para escenarios del mundo real, como la automatización del hogar o la robótica industrial. Y esperan que PaLM-E inspire más investigaciones sobre el razonamiento multimodal y la IA incorporada.

“Multimodal” es una palabra de moda que escucharemos cada vez más a medida que las empresas recurran a la inteligencia artificial general que aparentemente podrá realizar tareas generales como un ser humano.