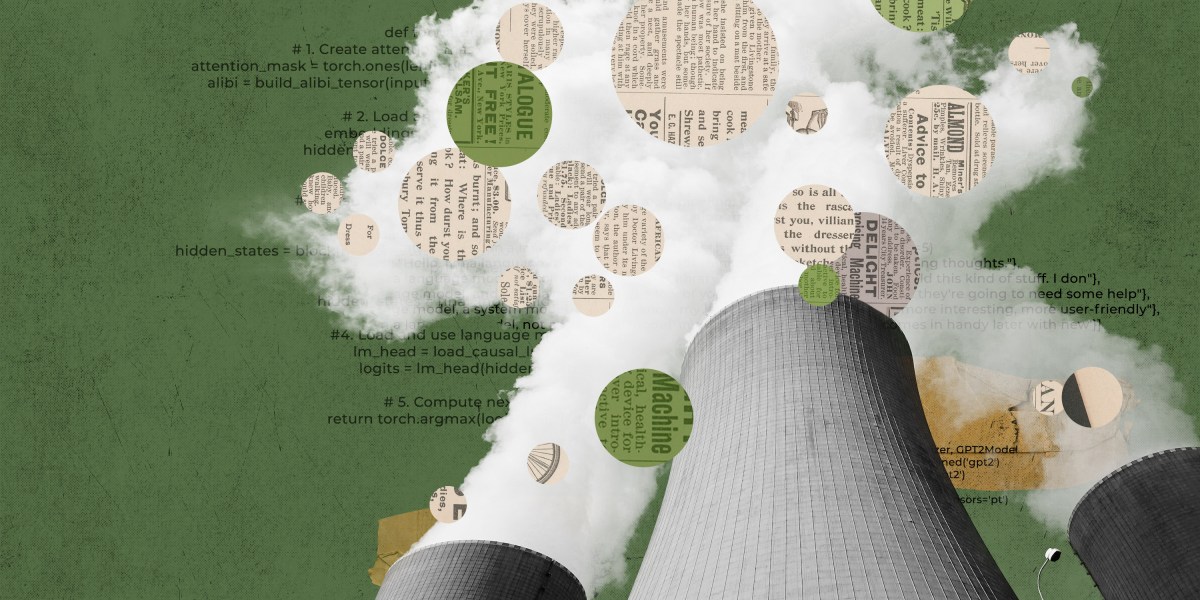

Para probar su nuevo enfoque, Hugging Face estimó las emisiones generales de su propio modelo de lenguaje grande, BLOOM, que se lanzó a principios de este año. Fue un proceso que implicó sumar muchos números diferentes: la cantidad de energía utilizada para entrenar el modelo en una supercomputadora, la energía necesaria para fabricar el hardware de la supercomputadora y mantener su infraestructura informática, y la energía utilizada para ejecutar BLOOM una vez que tuvo sido desplegado. Los investigadores calcularon esa parte final utilizando una herramienta de software llamada CodeCarbon, que rastreó las emisiones de carbono que BLOOM estaba produciendo en tiempo real durante un período de 18 días.

Hugging Face estimó que el entrenamiento de BLOOM generó 25 toneladas métricas de emisiones de carbono. Pero, según los investigadores, esa cifra se duplicó cuando se tomaron en cuenta las emisiones producidas por la fabricación del equipo informático utilizado para la capacitación, la infraestructura informática más amplia y la energía requerida para ejecutar BLOOM una vez que se entrenó.

Si bien eso puede parecer mucho para un modelo, 50 toneladas métricas de emisiones de carbono equivalen a alrededor de 60 vuelos

Después del lanzamiento de BLOOM, Hugging Face estimó que usar el modelo emitía alrededor de 19 kilogramos de dióxido de carbono por día, que es similar a las emisiones producidas al conducir alrededor de 54 millas en un auto nuevo promedio

A modo de comparación, OpenAI GPT-3 y los de Meta OPTAR se estimó que emitieron más de 500 y 75 toneladas métricas de dióxido de carbono, respectivamente, durante el entrenamiento. Las grandes emisiones de GPT-3 pueden explicarse en parte por el hecho de que se entrenó en hardware más antiguo y menos eficiente. Pero es difícil decir cuáles son las cifras con certeza; no existe una forma estandarizada de medir las emisiones de carbono y estas cifras se basan en estimaciones externas o, en el caso de Meta, en datos limitados que la empresa publicó.

“Nuestro objetivo era ir más allá de las emisiones de carbono de la electricidad consumida durante la capacitación y dar cuenta de una mayor parte del ciclo de vida para ayudar a la comunidad de IA a tener una mejor idea de su impacto en el medio ambiente y cómo podríamos comenzar a reducirlo”, dice Sasha Luccioni, investigadora de Hugging Face y autora principal del artículo.

El artículo de Hugging Face establece un nuevo estándar para las organizaciones que desarrollan modelos de IA, dice Emma Strubell, profesora asistente en la escuela de informática de la Universidad Carnegie Mellon, quien escribió un artículo seminal papel sobre el impacto de la IA en el clima en 2019. No participó en esta nueva investigación.

El documento “representa el análisis más completo, honesto y bien informado de la huella de carbono de un gran modelo de ML hasta la fecha, hasta donde yo sé, entrando en muchos más detalles… que cualquier otro documento [or] informe que yo sepa”, dice Strubell.