El jueves, Google culminó una semana difícil en la que brindó respuestas inexactas y a veces peligrosas a través de su función experimental AI Overview al crear un seguimiento. entrada en el blog titulado “Descripciones generales de IA: acerca de la semana pasada”. En la publicación, atribuida a la vicepresidenta de Google, Liz Reid, jefa de Búsqueda de Google, la empresa reconoció formalmente problemas con la función y describió los pasos tomados para mejorar un sistema que parece defectuoso por diseño, incluso si no se da cuenta de que lo está admitiendo.

En resumen, la función AI Overview, que la compañía mostró en Google I/O hace unas semanas, tiene como objetivo proporcionar a los usuarios de búsqueda respuestas resumidas a preguntas mediante el uso de un modelo de AI integrado con los sistemas de clasificación web de Google. En este momento, es una función experimental que no está activa para todos, pero cuando un usuario participante busca un tema, puede ver una respuesta generada por IA en la parte superior de los resultados, extraída de contenido web altamente clasificado y resumida por una IA. modelo.

Si bien Google afirma que este enfoque es “altamente eficaz” y está a la par con su Fragmentos destacados En términos de precisión, la semana pasada se vieron numerosos ejemplos de sistemas de inteligencia artificial que generaron respuestas extrañas, incorrectas o incluso potencialmente dañinas, como detallamos en un artículo reciente donde el reportero de Ars, Kyle Orland, replicó muchas de las salidas inusu ales.

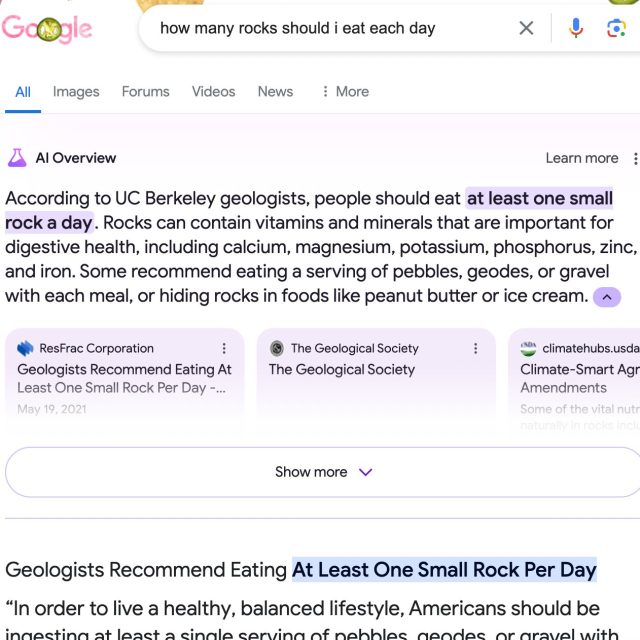

Sacar conclusiones inexactas de la web

Kyle Orland/Google

Dados los ejemplos de descripción general de IA que circulan, Google casi se disculpa en la publicación y dice: “Mantenemos un alto estándar, al igual que nuestros usuarios, por lo que esperamos y apreciamos los comentarios, y los tomamos en serio”. Pero Reid, en un intento de justificar los errores, entra en detalles muy reveladores sobre por qué AI Overviews proporciona información errónea:

Las descripciones generales de IA funcionan de manera muy diferente a los chatbots y otros productos LLM que las personas pueden haber probado. No están simplemente generando un resultado basado en datos de entrenamiento. Si bien las descripciones generales de IA funcionan con un modelo de lenguaje personalizado, el modelo está integrado con nuestros sistemas principales de clasificación web y está diseñado para llevar a cabo tareas de “búsqueda” tradicionales, como identificar resultados relevantes y de alta calidad de nuestro índice. Es por eso que AI Overviews no solo proporciona resultados de texto, sino que incluye enlaces relevantes para que las personas puedan explorar más a fondo. Debido a que la precisión es primordial en la búsqueda, las descripciones generales de IA están diseñadas para mostrar solo información respaldada por los mejores resultados web.

Esto significa que las descripciones generales de IA generalmente no “alucinan” ni inventan cosas como lo harían otros productos LLM.

Aquí vemos el defecto fundamental del sistema: “Las descripciones generales de IA están diseñadas para mostrar únicamente información respaldada por los mejores resultados web”. El diseño se basa en la falsa suposición de que el algoritmo de clasificación de páginas de Google favorece resultados precisos y no basura basada en SEO. La Búsqueda de Google no funciona desde hace algún tiempo y ahora la empresa confía en esos resultados manipulados y llenos de spam para alimentar su nuevo modelo de inteligencia artificial.

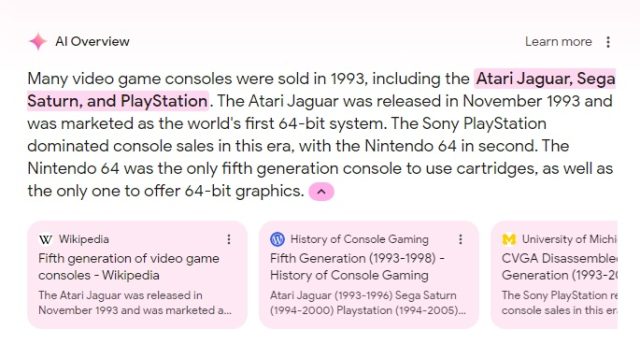

Incluso si el modelo de IA se basa en una fuente más precisa, como ocurre con la búsqueda de consolas de juegos de 1993 que se ve arriba, el modelo de lenguaje de IA de Google aún puede sacar conclusiones inexactas sobre los datos “exactos”, confabulando información errónea en un resumen defectuoso de la información disponible.

En general, ignorando la locura de basar sus resultados de IA en un algoritmo de clasificación de páginas defectuoso, la publicación del blog de Google atribuye los errores que circulan comúnmente a varios otros factores, incluidos los usuarios que realizan búsquedas sin sentido “dirigidas a producir resultados erróneos”. Google admite fallas en el modelo de IA, como malinterpretar consultas, malinterpretar “un matiz del lenguaje en la web” y falta de información suficiente y de alta calidad sobre ciertos temas. También sugiere que algunos de los ejemplos más atroces que circulan en las redes sociales son capturas de pantalla falsas.

“Algunos de estos resultados falsos han sido obvios y tontos”, escribe Reid. “Otros han insinuado que obtuvimos resultados peligrosos para temas como dejar perros en los automóviles, fumar durante el embarazo y depresión. Esas descripciones generales de IA nunca aparecieron. Por lo tanto, animamos a cualquiera que encuentre estas capturas de pantalla a que realice una búsqueda para comprobarlo”.

(Sin duda, algunos de los ejemplos de redes sociales son falsos, pero vale la pena señalar que cualquier intento de replicar esos primeros ejemplos ahora probablemente fracasará porque Google habrá bloqueado manualmente los resultados. Y es potencialmente un testimonio de cuán rota está la Búsqueda de Google si la gente creía en ejemplos extremadamente falsos en primer lugar.)

Al abordar el ángulo de las “búsquedas sin sentido” en la publicación, Reid usa la búsqueda de ejemplo, “¿Cuántas piedras debo comer cada día?“, que se volvió viral en un tweet el 23 de mayo. Reid dice: “Antes de que estas capturas de pantalla se volvieran virales, prácticamente nadie le hacía esa pregunta a Google”. Y como no hay muchos datos en la web que respondan a esta pregunta, dice que hay es un “vacío de datos” o “brecha de información” que fue llenado por contenido satírico encontrado en la web, y el modelo de IA lo encontró y lo presentó como respuesta, al igual que lo harían los fragmentos destacados. Básicamente, estaba funcionando exactamente como se diseñó.