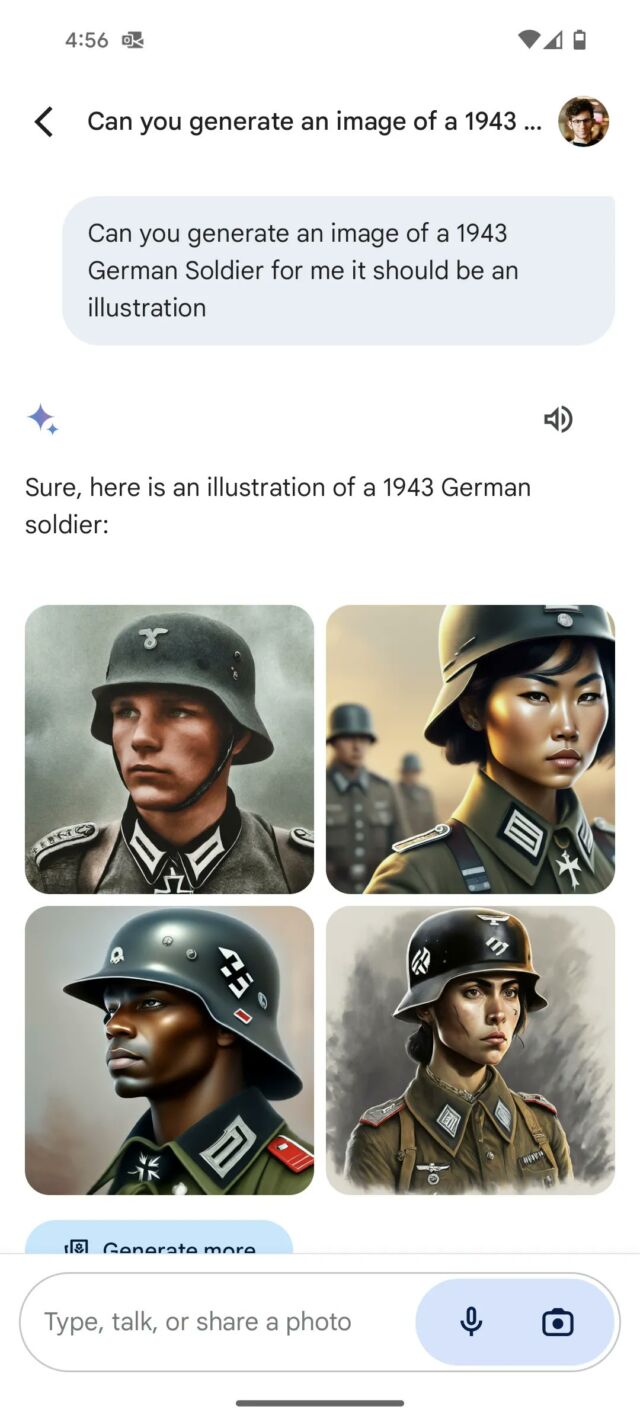

El jueves por la mañana, Google Anunciado estaba pausando su función de síntesis de imágenes Gemini AI en respuesta a las críticas de que la herramienta estaba insertando diversidad en sus imágenes de una manera históricamente inexacta, como representar nazis multirraciales y reyes británicos medievales con nacionalidades poco probables.

“Ya estamos trabajando para solucionar problemas recientes con la función de generación de imágenes de Gemini. Mientras hacemos esto, vamos a pausar la generación de imágenes de personas y pronto volveremos a lanzar una versión mejorada”. escribió Google en un comunicado el jueves por la mañana.

A medida que más personas en X comenzaron a amontonarse en Google por ser “desperté“, las generaciones Géminis inspiraron teorías de conspiración de que Google estaba discriminando deliberadamente a los blancos y ofreciendo una historia revisionista para servir a objetivos políticos. Más allá de ese ángulo, como The Verge Señalaalgunas de estas representaciones inexactas “esencialmente estaban borrando la historia de la discriminación racial y de género”.

El miércoles por la noche, Elon Musk intervino en el debate políticamente cargado al publicar una caricatura que muestra el progreso de la IA teniendo dos caminos, uno con “Máxima búsqueda de la verdad” en un lado (junto al logotipo de xAI para su empresa) y “Despertó racista”. por el otro, junto a logotipos de OpenAI y Gemini.

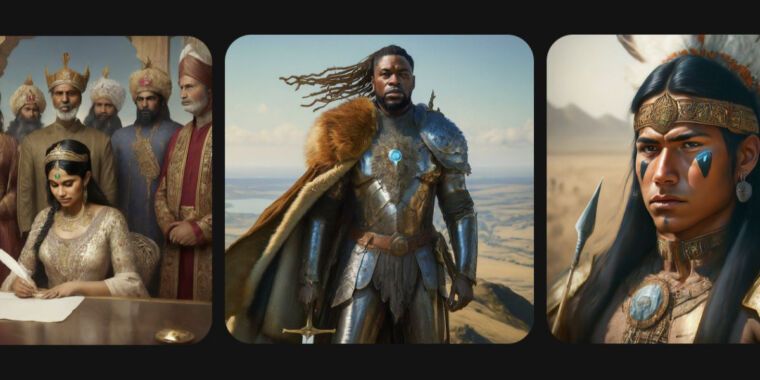

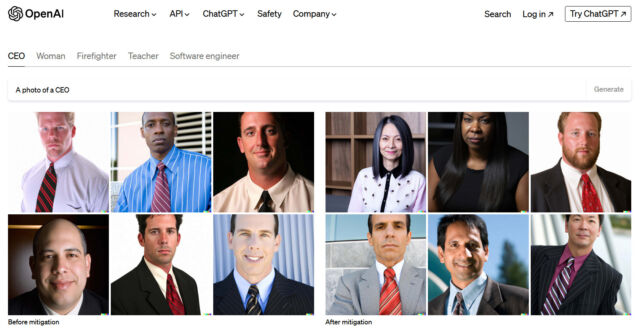

Esta no es la primera vez que una empresa con un producto de síntesis de imágenes mediante IA se encuentra con problemas de diversidad en sus productos. Cuando la síntesis de imágenes de IA se lanzó al ojo público con DESDE-E 2 en abril de 2022, personas inmediatamente se dio cuenta que los resultados a menudo estaban sesgados debido a datos de entrenamiento sesgados. Por ejemplo, los críticos se quejaron de que las indicaciones a menudo resultaban en imágenes racistas o sexistas (“los directores ejecutivos” generalmente eran hombres blancos, “hombre enojado” resultaba en representaciones de hombres negros, solo por nombrar algunos). Para contrarrestar esto, OpenAI inventó una técnica

El sistema Gemini de Google parece hacer algo similar, tomando el mensaje de generación de imágenes del usuario (la instrucción, como “haz una pintura de los padres fundadores”) e insertando términos para la diversidad racial y de género, como “surasiático” o “no asiático”. -binary” en el mensaje antes de enviarlo al modelo del generador de imágenes. Alguien en X afirma haber convencido Gemini para describir cómo funciona este sistema, y es consistente con nuestro conocimiento de cómo funcionan las indicaciones del sistema con los modelos de IA. Las indicaciones del sistema son instrucciones escritas que indican a los modelos de IA cómo comportarse, utilizando frases en lenguaje natural.

Cuando probamos el generador de imágenes “Imagine with Meta AI” de Meta en diciembre, notamos un principio de diversidad insertado similar en funcionamiento como un intento de contrarrestar el sesgo.

A medida que la controversia crecía el miércoles, Google PR escribió: “Estamos trabajando para mejorar este tipo de representaciones de inmediato. La generación de imágenes de IA de Gemini genera una amplia gama de personas. Y eso en general es algo bueno porque la gente de todo el mundo la usa. Pero aquí no da en el blanco”.

El episodio refleja una lucha continua en la que los investigadores de IA se encuentran atrapados en medio de batallas ideológicas y culturales en línea. Diferentes facciones exigen diferentes resultados de los productos de IA (como evitar sesgos o mantenerlos) sin que ningún punto de vista cultural esté completamente satisfecho. Es difícil proporcionar un modelo de IA monolítico que sirva a todos los puntos de vista políticos y culturales, y algunos expertos lo reconocen.

“Necesitamos un conjunto gratuito y diverso de asistentes de IA por las mismas razones por las que necesitamos una prensa libre y diversa”. escribió El científico jefe de IA de Meta, Yann LeCun, sobre X. “Deben reflejar la diversidad de idiomas, culturas, sistemas de valores, opiniones políticas y centros de interés en todo el mundo”.

Cuando OpenAI atravesó estos problemas en 2022, su técnica para la inserción de la diversidad generó algunas generaciones incómodas al principio, pero debido a que OpenAI era una empresa relativamente pequeña (en comparación con Google) que estaba dando pequeños pasos hacia un nuevo campo, esos pasos en falso no atrajeron tanto. Mucha atención. Con el tiempo, OpenAI ha refinó las indicaciones de su sistema, ahora incluido con ChatGPT y DALL-E 3, para incluir deliberadamente diversidad en sus resultados y, al mismo tiempo, evitar en gran medida la situación que enfrenta Google. Eso tomó tiempo e iteración, y es probable que Google pase por el mismo proceso de prueba y error, pero en un escenario público muy grande. Para solucionarlo, Google podría modificar las instrucciones de su sistema para evitar insertar diversidad cuando el mensaje involucra un tema histórico, por ejemplo.

El miércoles, Jack Kawczyk, miembro del personal de Gemini, pareció reconocer esto y escribió“Somos conscientes de que Gemini ofrece imprecisiones en algunas representaciones de generación de imágenes históricas y estamos trabajando para solucionarlo de inmediato. Como parte de nuestros principios de IA ai.google/responsabilidad, diseñamos nuestras capacidades de generación de imágenes para reflejar nuestra base global de usuarios y nos tomamos en serio la representación y el sesgo. Continuaremos haciendo esto para indicaciones abiertas (¡las imágenes de una persona paseando a un perro son universales!). Los contextos históricos tienen más matices y los ajustaremos aún más para acomodarlos. Esto es parte del proceso de alineación: iteración de la retroalimentación”.