Revista T3/imágenes falsas

Investigadores académicos han ideado una nueva hazaña de trabajo que se apodera de los altavoces inteligentes Amazon Echo y los obliga a desbloquear puertas, hacer llamadas telefónicas y compras no autorizadas, y controlar hornos, hornos de microondas y otros dispositivos inteligentes.

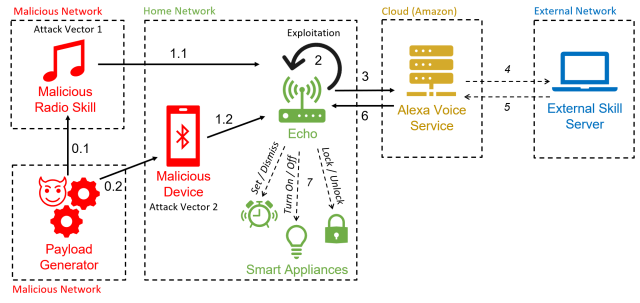

El ataque funciona utilizando el altavoz del dispositivo para emitir comandos de voz. Siempre que el discurso contenga la palabra de activación del dispositivo (generalmente “Alexa” o “Echo”) seguida de un comando permitido, Echo lo llevará a cabo, según descubrieron investigadores de la Universidad Royal Holloway en Londres y la Universidad de Catania en Italia. Incluso cuando los dispositivos requieren confirmación verbal antes de ejecutar comandos sensibles, es trivial eludir la medida agregando la palabra “sí” unos seis segundos después de emitir el comando. Los atacantes también pueden explotar lo que los investigadores llaman “FVV”, o vulnerabilidad de voz completa, que permite a Echos realizar comandos autoemitidos sin reducir temporalmente el volumen del dispositivo.

Alexa, ve a hackearte

Debido a que el truco utiliza la funcionalidad de Alexa para obligar a los dispositivos a realizar comandos autoemitidos, los investigadores lo han denominado “AvA”, abreviatura de Alexa vs. Alexa. Requiere solo unos segundos de proximidad a un dispositivo vulnerable mientras está encendido para que un atacante pueda pronunciar un comando de voz indicándole que se conecte con el dispositivo habilitado para Bluetooth de un atacante. Mientras el dispositivo permanezca dentro del alcance de radio del Echo, el atacante podrá emitir comandos.

El ataque “es el primero en explotar la vulnerabilidad de los comandos arbitrarios autoemitidos en los dispositivos Echo, lo que permite que un atacante los controle durante un período de tiempo prolongado”, escribieron los investigadores en un artículo. papel publicado hace dos semanas. “Con este trabajo, eliminamos la necesidad de tener un altavoz externo cerca del dispositivo de destino, lo que aumenta la probabilidad general de un ataque”.

Una variación del ataque utiliza una estación de radio maliciosa para generar los comandos autoemitidos. Ese ataque ya no es posible en la forma que se muestra en el documento después de los parches de seguridad que Amazon, fabricante de Echo, lanzó en respuesta a la investigación. Los investigadores han confirmado que los ataques funcionan contra dispositivos Echo Dot de tercera y cuarta generación.

Esposito et al.

AvA comienza cuando un dispositivo Echo vulnerable se conecta por Bluetooth al dispositivo del atacante (y para Echos sin parches, cuando reproducen la estación de radio maliciosa). A partir de ese momento, el atacante puede usar una aplicación de texto a voz u otros medios para transmitir comandos de voz. Aquí hay un video de AvA en acción. Todas las variaciones del ataque siguen siendo viables, con la excepción de lo que se muestra entre 1:40 y 2:14:

Alexa contra Alexa – Demostración.

Los investigadores descubrieron que podían usar AvA para obligar a los dispositivos a ejecutar una serie de comandos, muchos de ellos con graves consecuencias para la privacidad o la seguridad. Las posibles acciones maliciosas incluyen:

- Controlar otros electrodomésticos inteligentes, como apagar las luces, encender un horno de microondas inteligente, configurar la calefacción a una temperatura insegura o desbloquear cerraduras de puertas inteligentes. Como se señaló anteriormente, cuando Echos requiere confirmación, el adversario solo necesita agregar un “sí” al comando unos seis segundos después de la solicitud.

- Llame a cualquier número de teléfono, incluido uno controlado por el atacante, para que sea posible escuchar los sonidos cercanos. Si bien los Echos usan una luz para indicar que están haciendo una llamada, los dispositivos no siempre son visibles para los usuarios y es posible que los usuarios menos experimentados no sepan lo que significa la luz.

- Hacer compras no autorizadas utilizando la cuenta de Amazon de la víctima. Aunque Amazon enviará un correo electrónico notificando a la víctima de la compra, es posible que se pierda el correo electrónico o que el usuario pierda la confianza en Amazon. Alternativamente, los atacantes también pueden eliminar elementos que ya están en el carrito de compras de la cuenta.

- Manipular el calendario previamente vinculado de un usuario para agregar, mover, eliminar o modificar eventos.

- Suplantar habilidades o iniciar cualquier habilidad a elección del atacante. Esto, a su vez, podría permitir a los atacantes obtener contraseñas y datos personales.

- Recuperar todas las declaraciones hechas por la víctima. Usando lo que los investigadores llaman un “ataque de máscara”, un adversario puede interceptar comandos y almacenarlos en una base de datos. Esto podría permitir al adversario extraer datos privados, recopilar información sobre las habilidades utilizadas e inferir los hábitos de los usuarios.

Los investigadores escribieron:

Con estas pruebas, demostramos que AvA se puede usar para dar comandos arbitrarios de cualquier tipo y duración, con resultados óptimos; en particular, un atacante puede controlar luces inteligentes con una tasa de éxito del 93 %, comprar con éxito artículos no deseados en Amazon el 100 % de los tiempos, y manipular [with] un calendario vinculado con una tasa de éxito del 88 %. Los comandos complejos que deben reconocerse correctamente en su totalidad para tener éxito, como llamar a un número de teléfono, tienen una tasa de éxito casi óptima, en este caso del 73 %. Además, los resultados que se muestran en la Tabla 7 demuestran que el atacante puede configurar con éxito un ataque de enmascaramiento de voz a través de nuestra habilidad Mask Attack sin ser detectado, y todas las declaraciones emitidas se pueden recuperar y almacenar en la base de datos del atacante, es decir, 41 en nuestro caso.