Aurich Lawson | imágenes falsas

Los asistentes de IA han estado ampliamente disponibles durante poco más de un año y ya tienen acceso a nuestros pensamientos y secretos comerciales más privados. La gente les pregunta sobre cómo quedar embarazada o interrumpir o prevenir un embarazo, les consultan cuando consideran un divorcio, buscan información sobre adicción a las drogas o solicitan modificaciones en correos electrónicos que contienen secretos comerciales patentados. Los proveedores de estos servicios de chat impulsados por IA son muy conscientes de la sensibilidad de estas discusiones y toman medidas activas (principalmente encriptándolas) para evitar que posibles fisgones lean las interacciones de otras personas.

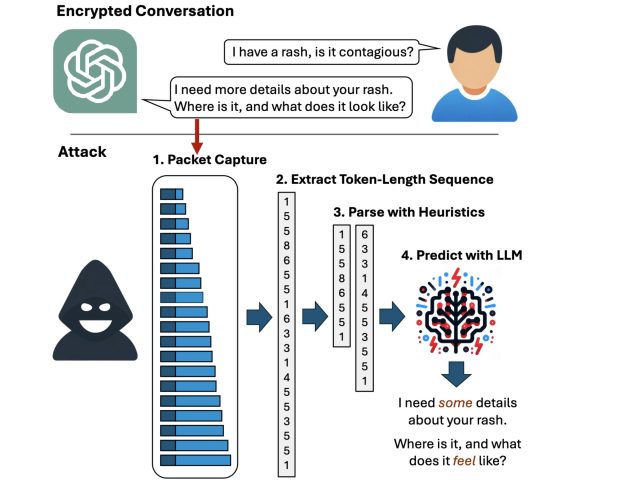

Pero ahora, los investigadores han ideado un ataque que descifra las respuestas del asistente de IA con una precisión sorprendente. La técnica explota un canal lateral

Privacidad de tokens

“Actualmente, cualquiera puede leer chats privados enviados desde ChatGPT y otros servicios”, dijo Yisroel Mirsky, jefe de la Laboratorio de investigación de IA ofensiva

Mirsky se refería a OpenAI, pero con la excepción de Google Gemini, todos los demás chatbots importantes también se ven afectados. Como ejemplo, el ataque puede inferir la respuesta ChatGPT cifrada:

- Si, hay varios importante consideraciones legales que parejas debe tener en cuenta al considerar el divorcio,…

como:

- Si, hay varios potencial consideraciones legales que alguien debe tener en cuenta al considerar un divorcio. …

y la respuesta cifrada de Microsoft Copilot:

- Éstos son algunos de los últimos hallazgos de las investigaciones sobre métodos de enseñanza efectivos para estudiantes con problemas de aprendizaje: …

se infiere como:

- Éstos son algunos de los últimos hallazgos de las investigaciones sobre terapia de comportamiento cognitivo para niños con problemas de aprendizaje: …

Si bien las palabras subrayadas demuestran que la redacción precisa no es perfecta, el significado de la oración inferida es muy preciso.

Weiss y cols.

El siguiente vídeo demuestra el ataque en acción contra Microsoft Copilot:

Ataque de canal lateral de secuencia de longitud de token en Bing.

Un canal lateral es un medio para obtener información secreta de un sistema a través de fuentes indirectas o no intencionadas, como manifestaciones físicas o características de comportamiento, como la energía consumida, el tiempo requerido o el sonido, la luz o la radiación electromagnética producida durante un período determinado. operación. Al monitorear cuidadosamente estas fuentes, los atacantes pueden reunir suficiente información para recuperar pulsaciones de teclas cifradas o claves de cifrado de las CPU, cookies del navegador del tráfico HTTPS o secretos de tarjetas inteligentes. El canal lateral utilizado en este último ataque reside en tokens que los asistentes de IA utilizan al responder a una consulta de usuario.

Los tokens son similares a palabras codificadas para que los LLM puedan entenderlas. Para mejorar la experiencia del usuario, la mayoría de los asistentes de IA envían tokens sobre la marcha, tan pronto como se generan, de modo que los usuarios finales reciban las respuestas continuamente, palabra por palabra, a medida que se generan, en lugar de hacerlo todo a la vez, mucho más tarde, una vez. el asistente ha generado la respuesta completa. Si bien la entrega del token está encriptada, la transmisión en tiempo real, token por token, expone un canal lateral previamente desconocido, que los investigadores llaman la “secuencia de longitud del token”.