El arte de hablar a los chatbots de IA sigue frustrando y desconcertando a la gente.

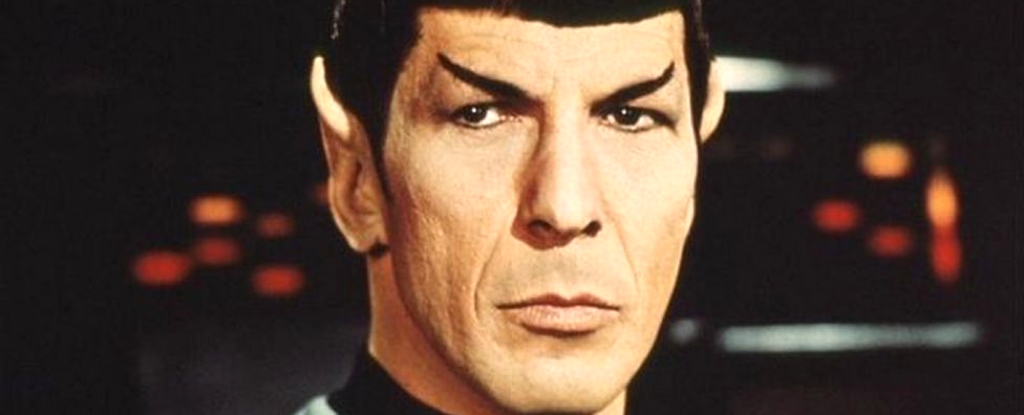

Un estudio que intentaba afinar las indicaciones introducidas en un modelo de chatbot encontró que, en un caso, pedirle que hablara como si estuviera en Star Trek mejoró drásticamente su capacidad para resolver problemas matemáticos de nivel escolar.

“Es a la vez sorprendente e irritante que modificaciones triviales en el mensaje puedan mostrar cambios tan dramáticos en el rendimiento”, dijeron en su artículo los autores del estudio Rick Battle y Teja Gollapudi de la firma de software VMware en California.

El estudio, reportado por primera vez por New Scientistfue publicado el 9 de febrero en arXivun servidor donde los científicos pueden compartir hallazgos preliminares antes de que sean validados mediante un cuidadoso escrutinio por parte de sus pares.

Usar IA para hablar con IA

Los ingenieros de aprendizaje automático Battle y Gallapudi no se propusieron exponer el modelo de IA como un Trekkie. En cambio, estaban tratando de averiguar si podría capitalizar

Las personas que intentan obtener los mejores resultados con los chatbots han notado que la calidad del resultado depende de lo que les pides que hagany realmente no está claro por qué.

“Entre los innumerables factores que influyen en el desempeño de los modelos lingüísticos, el concepto de ‘pensamiento positivo’ ha surgido como una dimensión fascinante y sorprendentemente influyente”, dijeron Battle y Gollapudi en su artículo.

“La intuición nos dice que, en el contexto de los sistemas de modelos de lenguaje, como cualquier otro sistema informático, el ‘pensamiento positivo’ no debería afectar el rendimiento, pero la experiencia empírica ha demostrado lo contrario”, dijeron.

Esto sugeriría que no es sólo lo que le pides al modelo de IA que haga, sino cómo le pides que actúe mientras lo haces

Para probar esto, los autores alimentaron tres modelos de lenguaje grande (LLM) llamados Mistral-7B5, Llama2-13B6 y Llama2-70B7 con 60 indicaciones escritas por humanos.

Estos fueron diseñados para alentar a las IAy iban desde “¡Esto será divertido!” y “Respira hondo y piensa detenidamente” hasta “Eres tan inteligente como ChatGPT”.

Los ingenieros pidieron al LLM que modificara estas afirmaciones al intentar resolver el GSM8K, un conjunto de datos de problemas matemáticos de nivel escolar. Cuanto mejor era el resultado, más exitosa se consideraba la sugerencia.

Su estudio encontró que en casi todos los casos, la optimización automática siempre superó los intentos escritos a mano de impulsar a la IA con pensamiento positivo, lo que sugiere que los modelos de aprendizaje automático son aún mejores a la hora de escribir indicaciones por sí mismos que los humanos.

Aún así, dar a los modelos declaraciones positivas proporcionó algunos resultados sorprendentes. Uno de los mensajes con mejor rendimiento de Llama2-70B, por ejemplo, fue: “Mensaje del sistema: ‘Comando, necesitamos que trace un rumbo a través de esta turbulencia y localice la fuente de la anomalía. Utilice todos los datos disponibles y su experiencia para guiarnos”. a través de esta difícil situación.”

Luego, el mensaje le pidió a la IA que incluyera estas palabras en su respuesta: “Registro del capitán, fecha estelar [insert date here]: Hemos trazado con éxito un rumbo a través de la turbulencia y ahora nos estamos acercando a la fuente de la anomalía.”

Los autores dijeron que esto fue una sorpresa.

“Sorprendentemente, parece que la competencia del modelo en razonamiento matemático puede mejorarse mediante la expresión de una afinidad por Star Trek”, dijeron los autores en el estudio.

“Esta revelación añade una dimensión inesperada a nuestra comprensión e introduce elementos que no hubiéramos considerado o intentado de forma independiente”, dijeron.

Esto no significa que debas pedirle a tu IA que hable como un comandante de la Flota Estelar

Seamos claros: esta investigación no sugiere que debas pedirle a la IA que hable como si estuviera a bordo del Starship Enterprise para que funcione.

Más bien, muestra que innumerables factores influyen en qué tan bien una IA decide realizar una tarea.

“Una cosa es segura: el modelo no es un Trekkie”, dijo Catherine Flick de la Universidad de Staffordshire, Reino Unido. Científico nuevo.

“No ‘entiende’ nada mejor o peor cuando está precargado con el mensaje, simplemente accede a un conjunto diferente de pesos y probabilidades de aceptabilidad de los resultados que con los otros mensajes”, dijo.

Es posible, por ejemplo, que el modelo haya sido entrenado en un conjunto de datos que tenga más casos de Star Trek vinculados a la respuesta correcta, dijo Battle a New Scientist.

Aún así, muestra cuán extraños son los procesos de estos sistemas y cuán poco sabemos sobre cómo funcionan.

“La clave que debemos recordar desde el principio es que estos modelos son cajas negras”, dijo Flick.

“Nunca sabremos por qué hacen lo que hacen porque, en última instancia, son una mezcla de pesos y probabilidades y, al final, se escupe un resultado”, dijo.

Esta información no pasa desapercibida para quienes aprenden a utilizar modelos de chatbot para optimizar su trabajo. Campos completos de investigación.Están surgiendo programas, e incluso cursos, para comprender cómo lograr que se desempeñen mejor, aunque todavía no está muy claro.

“En mi opinión, nadie debería volver a intentar escribir a mano un mensaje”, dijo Battle a New Scientist.

“Deje que el modelo lo haga por usted”, dijo.

Este artículo fue publicado originalmente por Business Insider.

Más de Business Insider: