Por Jack M. Germain

20 de agosto de 2019 2:36 AM PT

Desarrollador de chips de inicio

Cerebras El lunes anunció un avance en el diseño de procesadores de alta velocidad que acelerará el desarrollo de tecnologías de inteligencia artificial.

Cerebras presentó el chip de procesamiento informático más grande jamás construido. El nuevo chip, denominado "Wafer-Scale Engine" (WSE), pronunciado "sabio", es el latido del corazón de la máquina de aprendizaje profundo de la compañía creada para alimentar sistemas de inteligencia artificial.

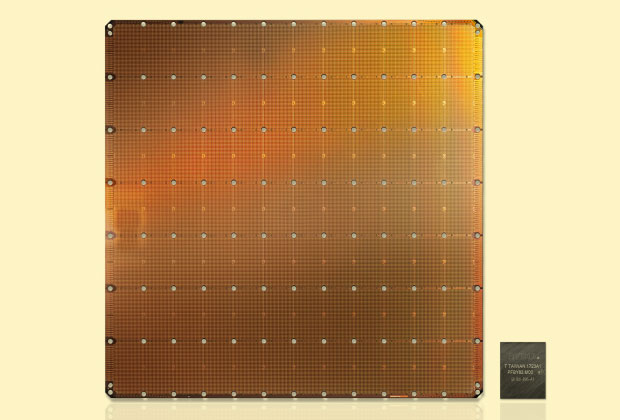

WSE revierte la tendencia de la industria de chips de incluir más potencia informática en chips de factor de forma más pequeños. Su tamaño masivo mide ocho pulgadas y media en cada lado. En comparación, la mayoría de los chips se ajustan a la punta del dedo y no son más grandes que un centímetro por lado.

La superficie del nuevo chip contiene 400,000 pequeñas computadoras, conocidas como "núcleos", con 1.2 trillones de transistores. La unidad de procesamiento de gráficos (GPU) más grande es de 815 mm2 y tiene 21.1 mil millones de transistores.

Aquí se muestra el Cerebras Wafer-Scale Engine, el chip más grande jamás construido, junto con la unidad de procesamiento de gráficos más grande.

El chip ya está en uso por algunos clientes, y la compañía está tomando pedidos, dijo un portavoz de Cerebras en comentarios proporcionados a TechNewsWorld por el representante de la compañía Kim Ziesemer.

"El tamaño del chip es profundamente importante en la IA, ya que los chips grandes procesan la información más rápidamente, produciendo respuestas en menos tiempo", señaló el portavoz. La nueva tecnología de chips tardó tres años en desarrollarse.

Más grande es mejor entrenar IA

Reducir el tiempo de comprensión de las redes neuronales, o el tiempo de entrenamiento, permite a los investigadores probar más ideas, usar más datos y resolver nuevos problemas. Google, Facebook, OpenAI, Tencent, Baidu y muchos otros han argumentado que la limitación fundamental de la IA de hoy es que lleva mucho tiempo entrenar modelos, explicó el portavoz de Cerebras, señalando que "reducir el tiempo de entrenamiento elimina así un importante cuello de botella para la industria- amplio progreso ".

Acelerar la capacitación utilizando la tecnología WSE permite a los investigadores capacitar a miles de modelos en el tiempo que anteriormente tomaba capacitar a un solo modelo. Además, WSE permite modelos nuevos y diferentes.

Esos beneficios son el resultado del gran universo de algoritmos entrenables. El subconjunto que funciona en las GPU es muy pequeño. WSE permite la exploración de algoritmos nuevos y diferentes.

El entrenamiento de modelos existentes en una fracción del tiempo y el entrenamiento de modelos nuevos para realizar tareas previamente imposibles cambiará profundamente la etapa de inferencia de la inteligencia artificial, dijo el portavoz de Cerebras.

Entendiendo la terminología

Para poner en perspectiva los resultados avanzados anticipados, es esencial comprender tres conceptos sobre las redes neuronales:

- El entrenamiento es aprender;

- La inferencia es aplicar el aprendizaje a las tareas; y

- Inferencia es usar el aprendizaje para clasificar.

Por ejemplo, primero debes enseñarle a un algoritmo cómo se ven los animales. Esto es entrenamiento. Luego puedes mostrarle una imagen y reconocer una hiena. Eso es inferencia.

Permitir un entrenamiento mucho más rápido y modelos nuevos y mejorados cambia para siempre la inferencia. Los investigadores podrán empacar más inferencia en cómputo más pequeño y permitir que cómputo más eficiente en el consumo de energía haga inferencia excepcional.

Este proceso es particularmente importante ya que la mayor parte de la inferencia se realiza en máquinas que usan baterías o que de alguna otra manera tienen limitaciones de potencia. Por lo tanto, una mejor capacitación y nuevos modelos permiten realizar inferencias más efectivas desde teléfonos, GoPros, relojes, cámaras, automóviles, cámaras de seguridad / CCTV, equipos agrícolas, equipos de fabricación, asistentes digitales personales, audífonos, purificadores de agua y miles de otros dispositivos. , según Cerebras.

El Cerebras Wafer Scale Engine es sin duda una gran hazaña para el avance de la tecnología de inteligencia artificial, señaló Chris Jann, CEO de

Medicus IT)

"Este es un fuerte indicador de que estamos comprometidos con el avance de la inteligencia artificial y, como tal, la presencia de AI continuará aumentando en nuestras vidas", dijo a TechNewsWorld. "Esperaría que esta industria continúe creciendo a un ritmo exponencial a medida que cada nuevo desarrollo de IA continúe aumentando su demanda".

El tamaño de WSE importa

El chip de Cerebras es 57 veces el tamaño del chip líder de Nvidia, el "V100", que domina la IA de hoy. El nuevo chip tiene más circuitos de memoria que cualquier otro chip: 18 gigabytes, que es 3.000 veces más que la parte de Nvidia, según Cerebras.

Las compañías de chips siempre han buscado un avance en la construcción de un solo chip del tamaño de una oblea de silicio. Cerebras parece ser el primero en tener éxito con un producto comercialmente viable.

Cerebras recibió alre dedor de US $ 200 millones de prominentes capitalistas de riesgo para sembrar ese logro.

El nuevo chip estimulará la reinvención de la inteligencia artificial, sugirió el CEO de Cerebras, Andrew Feldman. Proporciona la velocidad de procesamiento paralelo que Google y otros necesitarán para construir redes neuronales de un tamaño sin precedentes.

Es difícil decir qué tipo de impacto tendrá una empresa como Cerebras o sus chips a largo plazo, dijo Charles King, analista principal de Pandit.

"Eso se debe en parte a que su tecnología es esencialmente nueva, lo que significa que tienen que encontrar socios y desarrolladores dispuestos, y mucho menos clientes para registrarse en el viaje", dijo a TechNewsWorld.

Expansión rápida de AI

Aún así, el mercado de conjuntos de chips de inteligencia artificial en la nube se ha expandido rápidamente, y la industria está viendo la aparición de una amplia gama de casos de uso impulsados por varios modelos de inteligencia artificial, según Lian Jye Su, analista principal de ABI Research.

"Para abordar la diversidad en los casos de uso, muchos desarrolladores y usuarios finales necesitan identificar su propio equilibrio entre el costo de la infraestructura, el presupuesto de energía, la flexibilidad y escalabilidad del chipset, así como el ecosistema del desarrollador", dijo a TechNewsWorld.

En muchos casos, los desarrolladores y usuarios finales adoptan un enfoque híbrido para determinar la cartera correcta de conjuntos de chips de inteligencia artificial en la nube. Cerebras WSE está bien posicionada para atender ese segmento, señaló Su.

Qué ofrece WSE

La nueva tecnología Cerebras aborda los dos desafíos principales en las cargas de trabajo de aprendizaje profundo: potencia computacional y transmisión de datos. Su gran tamaño de silicio proporciona más memoria de chip y núcleos de procesamiento, mientras que su tejido de comunicación de datos patentado acelera la transmisión de datos, explicó Su.

Con WSE, Cerebras Systems puede enfocarse en la construcción de ecosistemas a través de su Pila de software Cerebras y ser un jugador clave en la industria de chipsets de inteligencia artificial en la nube, señaló Su.

El proceso de IA implica lo siguiente:

- Herramientas de software construidas por Cerebras para el diseño; y

- construyendo circuitos redundantes para enrutar los defectos en la fabricación de silicio con el fin de entregar 400,000 núcleos optimizados de trabajo, como un Internet en miniatura que continúa cuando las computadoras de servidores individuales caen;

- mover datos de nuevas maneras para una mejor capacitación de una red neuronal que requiere que miles de operaciones sucedan en paralelo en cada momento en el tiempo.

El problema que resuelve el chip WSE más grande es que las computadoras con múltiples chips se ralentizan al enviar datos entre los chips a través de los cables más lentos que los unen en una placa de circuito.

Las obleas se produjeron en asociación con Taiwan Semiconductor Manufacturing, el fabricante de chips más grande del mundo, pero Cerebras tiene derechos exclusivos sobre la propiedad intelectual que hace posible el proceso.

Disponible ahora pero …

Cerebras no venderá el chip por sí solo. En cambio, la compañía lo empaquetará como parte de un dispositivo informático diseñado por Cerebras.

Es necesario un sistema complejo de refrigeración por agua, una red de riego, para contrarrestar el calor extremo que genera el nuevo chip que funciona a 15 kilovatios de potencia.

La computadora Cerebras será 150 veces más potente que un servidor con múltiples chips Nvidia, a una fracción del consumo de energía y una fracción del espacio físico requerido en un rack de servidores, dijo Feldman. Eso hará que las tareas de entrenamiento neuronal que cuestan decenas de miles de dólares se ejecuten en instalaciones de computación en la nube un orden de magnitud menos costoso.