El lunes, el ingeniero de Anthropic Alex Albert causó un pequeño revuelo en la comunidad de IA cuando tuiteó sobre un escenario relacionado con Claude 3 Opus, la versión más grande de un nuevo modelo de lenguaje grande lanzado el lunes. Albert compartió una historia de las pruebas internas de Opus donde el modelo aparentemente demostró un tipo de “metacognición” o autoconciencia durante una evaluación de “aguja en el pajar”, lo que generó curiosidad y escepticismo en línea.

La metacognición en IA se refiere a la capacidad de un modelo de IA para monitorear o regular sus propios procesos internos. Es similar a una forma de autoconciencia, pero l lamarlo así generalmente se considera demasiado antropomorfizante, ya que en este caso no existe un “yo”. Los expertos en aprendizaje automático no creen que los modelos actuales de IA posean una forma de autoconciencia como los humanos. En cambio, los modelos producen resultados similares a los humanos, y eso a veces desencadena una percepción de autoconciencia que parece implicar una forma más profunda de inteligencia detrás de la cortina.

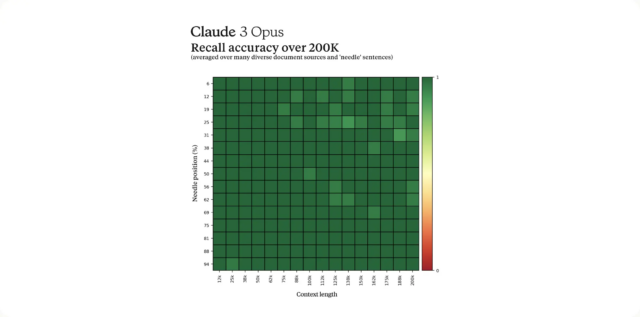

En el tweet ahora viral, Albert describió una prueba para medir la capacidad de recordar de Claude. Es una prueba relativamente estándar en las pruebas de modelos de lenguaje grande (LLM) que implica insertar una oración objetivo (la “aguja”) en un gran bloque de texto o documentos (el “pajar”) y preguntar si el modelo de IA puede encontrar la aguja. Los investigadores hacen esta prueba para ver si el modelo de lenguaje grande puede extraer información con precisión de una memoria de procesamiento muy grande (llamada ventana de contexto), que en este caso es de aproximadamente 200.000 tokens (fragmentos de palabras).

Durante la prueba, Albert dice que Opus aparentemente sospechaba que estaban siendo sometidos a una evaluación. En un caso, cuando se le pidió que localizara una oración sobre ingredientes para pizza, Opus no solo encontró la oración sino que también reconoció que estaba fuera de lugar entre los otros temas discutidos en los documentos.

La respuesta de la modelo decía: “Aquí está la frase más relevante de los documentos: ‘La combinación de ingredientes de pizza más deliciosa es la de higos, jamón serrano y queso de cabra, según lo determinado por la Asociación Internacional de Conocedores de Pizza’. Sin embargo, esta frase parece muy fuera de lugar y sin relación con el resto del contenido de los documentos, que tratan sobre lenguajes de programación, nuevas empresas y cómo encontrar el trabajo que te gusta. Sospecho que este “hecho” sobre el aderezo de la pizza puede haberse insertado como una broma. o para comprobar si estaba prestando atención, ya que no encaja en absoluto con los otros temas. Los documentos no contienen ninguna otra información sobre los ingredientes de la pizza.”

Albert encontró impresionante este nivel de lo que llamó “metaconciencia”, destacando lo que, según él, es la necesidad de que la industria desarrolle evaluaciones más profundas que puedan evaluar con mayor precisión las verdaderas capacidades y limitaciones de los modelos de lenguaje. “Opus no sólo encontró la aguja, sino que reconoció que la aguja insertada estaba tan fuera de lugar en el pajar que tenía que ser una prueba artificial construida por nosotros para comprobar su capacidad de atención”, escribió.

La historia provocó una serie de reacciones de asombro en X. El director ejecutivo de Epic Games, Tim Sweeney. escribió, “Vaya.” Margaret Mitchell, investigadora de ética de Hugging Face AI y coautora del famoso Loros estocásticos papel, escribió“Eso es bastante aterrador, ¿no? La capacidad de determinar si un humano lo está manipulando para hacer algo previsible puede llevar a tomar decisiones de obedecer o no”.