Internet está lleno de artefactos personales, muchos de los cuales pueden permanecer en línea mucho después de que alguien muere. Pero ¿qué pasa si esas reliquias se utilizan para simular a seres queridos muertos? Ya está sucediendo, y los especialistas en ética de la IA advierten que esta realidad nos está abriendo a un nuevo tipo de “persecución digital” por parte de “robots muertos”.

La gente ha intentado conversar con sus seres queridos fallecidos a través de ritos religiosos, médiums espirituales e incluso enfoques tecnológicos pseudocientíficos durante milenios. Pero el interés actual en la inteligencia artificial generativa presenta una posibilidad completamente nueva para amigos y familiares en duelo: la posibilidad de interactuar con avatares de chatbot entrenados en la presencia en línea y los datos de un individuo fallecido, incluida la voz y la imagen visual. Si bien todavía se anuncian explícitamente como aproximaciones digitales, algunos de los productos ofrecidos por empresas como Replika, HereAfter y Persona

Y si bien puede resultar difícil para algunos procesar esta nueva realidad, o incluso tomarla en serio, es importante recordar que la industria del “más allá digital” no es sólo un nicho de mercado limitado a nuevas empresas más pequeñas. El año pasado, Amazon se mostró el potencial de su asistente Alexa para imitar las voces de un ser querido fallecido usando solo un breve clip de audio.

[Related: Watch a tech billionaire talk to his AI-generated clone.]

Los especialistas en ética de la IA y los autores de ciencia ficción han explorado y anticipado estas situaciones potenciales durante décadas. Pero para los investigadores de Centro Leverhulme para el futuro de la inteligencia de la Universidad de Cambridge

En un nuevo estudio publicado en Filosofía y Tecnología, los especialistas en ética de la IA Tomasz Hollanek y Katarzyna Nowaczyk-Basińska se basaron en una estrategia llamada “ficción de diseño”. Acuñada por primera vez por el autor de ciencia ficción Bruce Sterling, la ficción de diseño se refiere a “una suspensión de la incredulidad sobre el cambio logrado mediante el uso de prototipos diegéticos”. Básicamente, los investigadores escriben eventos plausibles junto con ayudas visuales fabricadas.

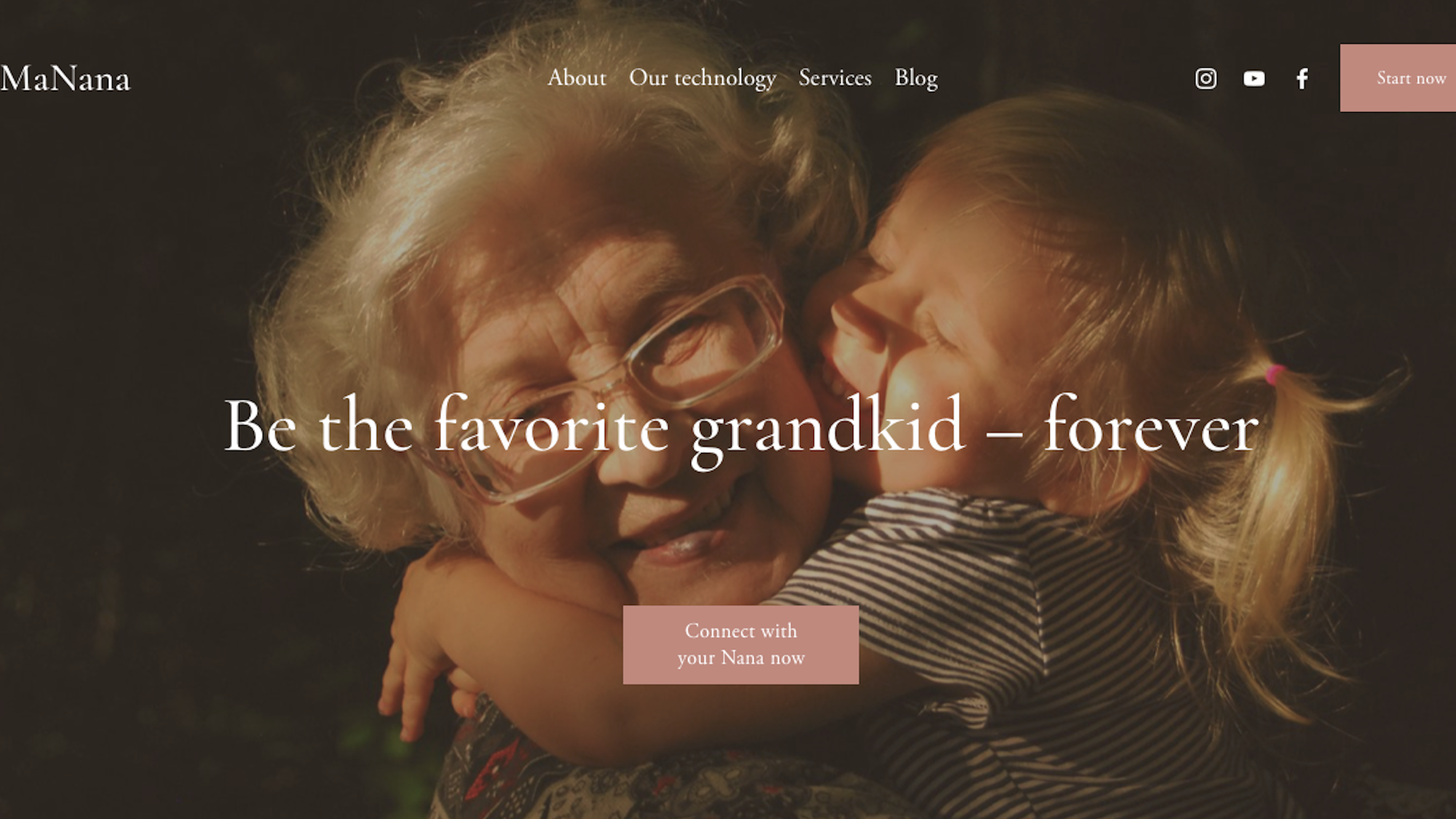

Para su investigación, Hollanek y Nowaczyk-Basińska imaginaron tres escenarios hiperrealistas de individuos ficticios que tienen problemas con varias empresas de “presencia post mortem”, y luego crearon accesorios digitales como sitios web falsos y capturas de pantalla de teléfonos. Los investigadores se centraron en tres datos demográficos distintos: donantes de datos, receptores de datos e interactuantes de servicios. Los “donantes de datos” son las personas en las que se basa un programa de IA, mientras que los “destinatarios de datos” se definen como las empresas o entidades que pueden poseer la información digital. Mientras tanto, los “interactuantes del servicio” son los familiares, amigos y cualquier otra persona que pueda utilizar un “robot muerto” o un “robot fantasma”.

En una pieza de ficción de diseño, un usuario adulto queda impresionado por el realismo del chatbot de sus abuelos fallecidos, solo para pronto recibir anuncios de “prueba premium” y de servicios de entrega de alimentos con el estilo de la voz de su familiar. En otro, una madre con una enfermedad terminal crea un robot muerto para que su hijo de ocho años los ayude en su duelo. Pero al adaptarse a las respuestas del niño, la IA comienza a sugerir reuniones en persona, causando así daño psicológico.

En un escenario final, un cliente mayor se inscribe en una suscripción de 20 años a un programa de inteligencia artificial con la esperanza de consolar a su familia. Sin embargo, debido a los términos de servicio de la empresa, sus hijos y nietos no pueden suspender el servicio incluso si no quieren utilizarlo.

“Los rápidos avances en la IA generativa significan que casi cualquier persona con acceso a Internet y algunos conocimientos básicos puede revivir a un ser querido fallecido”, afirmó Nowaczyk-Basińska. “Al mismo tiempo, una persona puede dejar una simulación de IA como regalo de despedida a sus seres queridos que no están preparados para procesar su dolor de esta manera. Los derechos tanto de los donantes de datos como de aquellos que interactúan con los servicios de inteligencia artificial después de la muerte deben salvaguardarse por igual”.

[Related: A deepfake ‘Joe Biden’ robocall told voters to stay home for primary election.]

“Estos servicios corren el riesgo de causar una gran angustia a las personas si se ven sometidas a apariciones digitales no deseadas de recreaciones de IA alarmantemente precisas de aquellos que han perdido”, añadió Hollanek. “El posible efecto psicológico, especialmente en un momento que ya es difícil, podría ser devastador”.

Los especialistas en ética creen que ciertas salvaguardias pueden y deben implementarse lo antes posible para evitar tales resultados. Las empresas deben desarrollar procedimientos sensibles para “retirar” un avatar, así como mantener la transparencia en el funcionamiento de sus servicios a través de exenciones de responsabilidad sobre riesgos. Mientras tanto, los “servicios de recreación” deben restringirse únicamente a usuarios adultos, respetando al mismo tiempo el consentimiento mutuo tanto de los donantes de datos como de sus destinatarios.

“Tenemos que empezar a pensar ahora en cómo mitigar los riesgos sociales y psicológicos de la inmortalidad digital”, sostiene Nowaczyk-Basińska.