Difusión estable

El martes, OpenAI publicado un nuevo artículo de investigación que detalla una técnica que usa su modelo de lenguaje GPT-4 para escribir explicaciones del comportamiento de las neuronas en su modelo GPT-2 más antiguo, aunque de manera imperfecta. Es un paso adelante para la “interpretabilidad”, que es un campo de la IA que busca explicar por qué las redes neuronales crean los resultados que generan.

Si bien los modelos de lenguaje extenso (LLM) están conquistando el mundo de la tecnología, los investigadores de IA aún no saben mucho sobre su funcionalidad y capacidades internas. En la primera oración del artículo de OpenAI, los autores escriben: “Los modelos de lenguaje se han vuelto más capaces y más ampliamente implementados, pero no entendemos cómo funcionan”.

Para los de afuera, eso probablemente suene como una sorprendente admisión de una compañía que no solo depende de los ingresos de los LLM sino también espera acelerarlos

Pero esta propiedad de “no saber” exactamente cómo las neuronas individuales de una red neuronal trabajan juntas para producir sus resultados tiene un nombre bien conocido: la caja negra. Alimenta las entradas de la red (como una pregunta) y obtiene salidas (como una respuesta), pero pase lo que pase en el medio (dentro de la “caja negra”) es un misterio.

En un intento por mirar dentro de la caja negra, los investigadores de OpenAI utilizaron su modelo de lenguaje GPT-4 para generar y evaluar explicaciones en lenguaje natural para el comportamiento de las neuronas en un modelo de lenguaje mucho menos complejo, como GPT-2. Idealmente, tener un modelo de IA interpretable ayudaría a contribuir al objetivo más amplio de lo que algunas personas llaman “alineación de IA”, asegurando que los sistemas de IA se comporten según lo previsto y reflejen los valores humanos. Y al automatizar el proceso de interpretación, OpenAI busca superar las limitaciones de la inspección humana manual tradicional, que no es escalable para redes neuronales más grandes con miles de millones de parámetros.

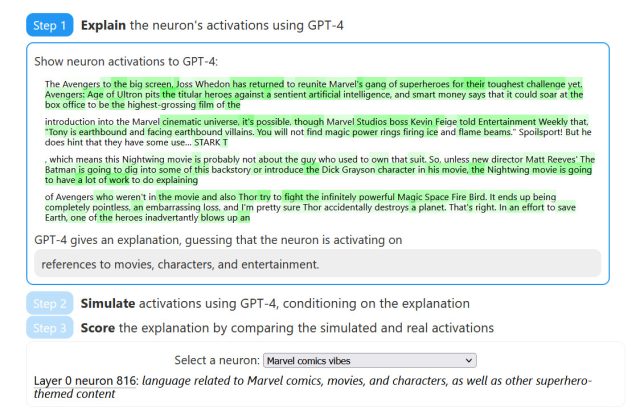

La técnica de OpenAI “busca explicar qué patrones en el texto hacen que se active una neurona”. Su metodología consta de tres pasos:

- Explicar las activaciones de la neurona usando GPT-4

- Simule el comportamiento de activación de neuronas usando GPT-4

- Compare las activaciones simuladas con activaciones reales.

Para comprender cómo funciona el método de OpenAI, debe conocer algunos términos: neurona, circuito y cabeza de atención. En una red neuronal, una neurona es como una pequeña unidad de toma de decisiones que recibe información, la procesa y produce una salida, al igual que una pequeña célula cerebral que toma una decisión en función de las señales que recibe. Un circuito en una red neuronal es como una red de neuronas interconectadas que trabajan juntas, pasando información y tomando decisiones colectivamente, similar a un grupo de personas que colaboran y se comunican para resolver un problema. Y un cabezal de atención es como un foco que ayuda a un modelo de lenguaje a prestar más atención a palabras específicas o partes de una oración, lo que le permite comprender y capturar mejor información importante mientras procesa el texto.

Mediante la identificación de neuronas y cabezas de atención específicas dentro del modelo que deben interpretarse, GPT-4 crea explicaciones legibles por humanos para la función o el papel de estos componentes. También genera una puntuación de explicación, que OpenAI llama “una medida de la capacidad de un modelo de lenguaje para comprimir y reconstruir las activaciones de las neuronas utilizando el lenguaje natural”. Los investigadores esperan que la naturaleza cuantificable del sistema de puntuación permita un progreso medible para hacer que los cálculos de redes neuronales sean comprensibles para los humanos.

Entonces, ¿qué tan bien funciona? En este momento, no es tan bueno. Durante las pruebas, OpenAI enfrentó su técnica con un contratista humano que realizó evaluaciones similares de forma manual, y descubrieron que tanto GPT-4 como el contratista humano “obtuvieron una puntuación baja en términos absolutos”, lo que significa que interpretar las neuronas es difícil.

Una explicación propuesta por OpenAI para esta falla es que las neuronas pueden ser “polisemánticas”, lo que significa que la neurona típica en el contexto del estudio puede exhibir múltiples significados o estar asociada con múltiples conceptos. En una sección sobre limitaciones, los investigadores de OpenAI discuten tanto las neuronas polisemánticas como las “características alienígenas” como limitaciones de su método:

Además, los modelos de lenguaje pueden representar conceptos extraños para los que los humanos no tienen palabras. Esto podría suceder porque los modelos de lenguaje se preocupan por diferentes cosas, por ejemplo, construcciones estadísticas útiles para tareas de predicción del siguiente token, o porque el modelo ha descubierto abstracciones naturales que los humanos aún tienen que descubrir, por ejemplo, alguna familia de conceptos análogos en dominios dispares.

Otras limitaciones incluyen el uso intensivo de cómputo y solo proporcionar explicaciones breves en lenguaje natural. Pero los investigadores de OpenAI todavía son optimistas de que han creado un marco tanto para la interpretabilidad mediada por máquinas como para los medios cuantificables de medir las mejoras en la interpretabilidad a medida que mejoran sus técnicas en el futuro. A medida que los modelos de IA se vuelven más avanzados, los investigadores de OpenAI esperan que la calidad de las explicaciones generadas mejore, ofreciendo mejores conocimientos sobre el funcionamiento interno de estos sistemas complejos.

OpenAI ha publicado su trabajo de investigación sobre un sitio web interactivo que contiene desgloses de ejemplo de cada paso, mostrando partes resaltadas del texto y cómo se corresponden con ciertas neuronas. Además. OpenAI ha proporcionado código de “interpretabilidad automatizada” y su Conjuntos de datos de neuronas y explicaciones de GPT-2 XL en GitHub.

Si alguna vez descubren exactamente por qué ChatGPT inventa las cosas, todo el esfuerzo valdrá la pena.