Los estafadores en línea están utilizando tecnología de clonación de voz mediante IA para que parezca que celebridades como Steve Harvey y Taylor Swift están animando a sus fans a caer en estafas relacionadas con beneficios médicos en YouTube. 404 Medios informó por primera vez sobre la tendencia esta semana. Estos son solo algunos de los últimos ejemplos de estafadores que aprovechan herramientas de IA generativa cada vez más accesibles para atacar. comunidades a menudo económicamente empobrecidas y hacerse pasar por personajes famosos para obtener ganancias financieras rápidas.

404 Medios fue contactado por un informante que dirigió la publicación hacia más de 1.600 vídeos en YouTube, donde las voces de celebridades falsificadas funcionan tan bien como las de personas que no son celebridades para impulsar las estafas. Esos videos, muchos de los cuales permanecen activos al momento de escribir este artículo, supuestamente acumularon 195 millones de visitas. Los videos parecen violar varias de las políticas de YouTube, particularmente aquellas relacionadas con tergiversación

¿Cómo funciona la estafa?

Los estafadores intentan engañar a los espectadores utilizando clips cortados de celebridades y con voces en off creadas con herramientas de inteligencia artificial que imitan las propias voces de las celebridades. Steve Harvey, oprah, Taylor Swiftpresentador de podcasts Joe Rogany comediante Kevin Hart todos tienen versiones deepfake de sus voces que parecen promover la estafa. Algunos de los videos no usan deepfakes de celebridades en absoluto, sino que parecen usar un elenco recurrente de humanos reales que presentan diferentes variaciones de una historia similar. Los videos a menudo son publicados por cuentas de YouTube con nombres engañosos como “USReliefGuide”, “ReliefConnection” y “Health Market Navigators”.

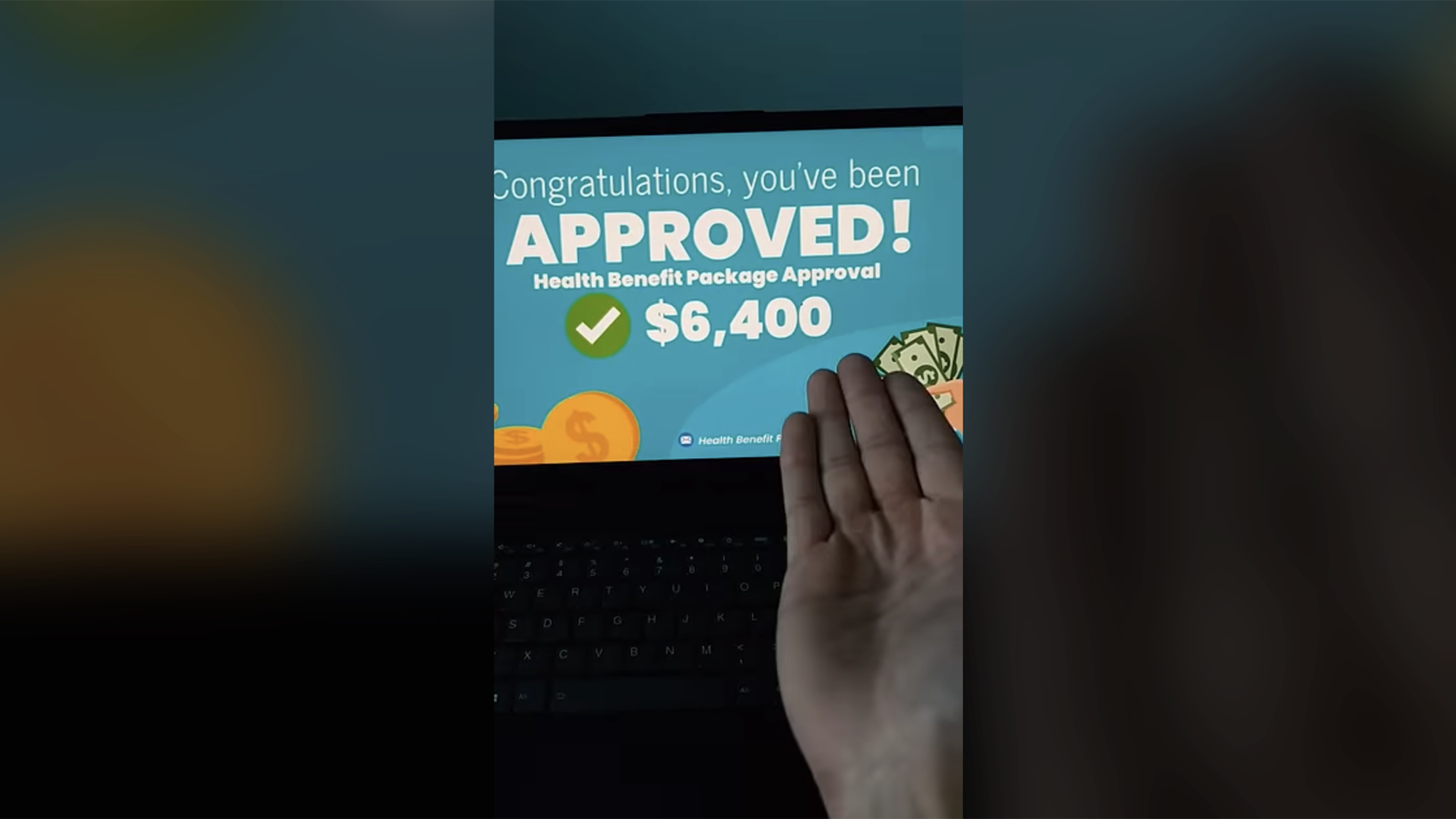

“Les he estado diciendo durante meses que reclamen estos $6,400”, clona un deepfake intentando hacerse pasar por Disputa familiar el presentador Steve Harvey dice. “¡Cualquiera puede conseguir esto incluso si no tiene trabajo!” Sólo ese vídeo, que todavía estaba en YouTube en el momento de escribir este artículo, había acumulado más de 18 millones de visitas.

Aunque la redacción exacta de las estafas varía según el vídeo, generalmente siguen una plantilla básica. En primer lugar, la celebridad o el actor falsificado se dirige a la audiencia y les alerta sobre un cheque de estímulo de fin de año de 6.400 dólares proporcionado por el gobierno de EE. UU. a través de una “tarjeta de gastos de salud”. Luego, la voz de la celebridad dice que cualquiera puede solicitar el estímulo siempre que no esté inscrito en Medicare o Medicaid. Luego, generalmente se indica a los espectadores que hagan clic en un enlace para solicitar los beneficios. Como muchas estafas efectivas, el video también introduce una sensación de urgencia al tratar de convencer a los espectadores de que el acuerdo falso no durará mucho.

En realidad, las víctimas que hacen clic en esos enlaces a menudo son redirigidas a URL con nombres como “secret Savingsusa.com” que en realidad no están afiliadas al gobierno de EE. UU. Reporteros de PolitiFact llamó a un número de registro

Existen numerosos programas y subsidios gubernamentales para ayudar a las personas necesitadas, pero las afirmaciones genéricas que ofrecen “dinero gratis” del gobierno de los EE. UU. generalmente una bandera roja. Reducir los costos asociados con la tecnología de inteligencia artificial generativa capaz de crear imitaciones algo convincentes de las voces de las celebridades puede hacer que estas estafas sean aún más convincentes. La Comisión Federal de Comercio (FTC) advirtió sobre esta posibilidad en un publicación de blog el año pasado donde citó ejemplos sencillos de estafadores que utilizan deepfakes y clones de voz para participar en extorsión y fraude financiero, entre otras actividades ilegales. Una encuesta reciente realizada por Más uno El año pasado se descubrió que el audio deepfake ya puede engañar a los oyentes humanos casi el 25% de las veces.

La FTC se negó a comentar sobre esta reciente serie de estafas de celebridades.

La tecnología de inteligencia artificial asequible y fácil de usar ha provocado un aumento en las estafas deepfake de celebridades

Este no es el primer caso de estafas de celebridades con deepfake y es casi seguro que no será el último. La leyenda de Hollywood Tom Hanks Recientemente se disculpó con sus fans en Instagram. después de que se descubriera un clon falso de sí mismo promocionando una estafa de un plan dental. Poco después, la presentadora de CBS, Gayle King, dijo Los estafadores estaban usando métodos deepfake similares. para que pareciera que estaba promocionando un producto para bajar de peso. Más recientemente, los estafadores según se informa combinó un clon de IA de la voz de la estrella del pop Taylor Swift junto con imágenes reales de ella usando utensilios de cocina Le Creuset para intentar convencer a los espectadores de que se inscribieran en un sorteo de utensilios de cocina. Los fanáticos nunca recibieron las brillantes ollas y sartenes.

Los legisladores están luchando por redactar nuevas leyes o aclarar la legislación existente para tratar de abordar los crecientes problemas. Varios proyectos de ley propuestos como el Ley de Responsabilidad de Deepfakes y el Ley contra las falsificaciones daría a los individuos más poder para controlar las representaciones digitales a su semejanza. Esta misma semana, un grupo bipartidista de cinco legisladores de la Cámara presentó la Ley contra el FRAUDE de IA que intenta establecer un marco federal para proteger los derechos de las personas a su imagen digital, con énfasis en artistas e intérpretes. Aún así, no está claro qué probabilidades hay de que se aprueben en medio de una avalancha de nuevas, Rápidamente se ideó una legislación sobre IA que ingresa al Congreso.