En el mundo de la IA de aprendizaje profundo, el antiguo juego de mesa Vamos se hace grande. Hasta 2016, el mejor jugador humano de Go aún podía derrotar a la IA más fuerte que jugaba Go. Eso cambió con AlphaGo de DeepMind, que utilizó redes neuronales de aprendizaje profundo para enseñarse a sí mismo el juego a un nivel que los humanos no pueden igualar. Más recientemente, katago se ha vuelto popular como una IA Go-playing de código abierto que puedes ganar jugadores humanos de Go de primer nivel.

La semana pasada, un grupo de investigadores de IA publicó un papel esbozando un método para derrotar a KataGo mediante el uso de técnicas adversarias que aprovechan los puntos ciegos de KataGo. Al jugar movimientos inesperados fuera del conjunto de entrenamiento de KataGo, un programa de juego de Go adversario mucho más débil (que los humanos aficionados pueden derrotar) puede engañar a KataGo para que pierda.

Para entender mejor este logro y sus implicaciones, hablamos con uno de los coautores del artículo, adam gleave, un doctorado candidato en UC Berkeley. Gleave (junto con los coautores Tony Wang, Nora Belrose, Tom Tseng, Joseph Miller, Michael D. Dennis, Yawen Duan, Viktor Pogrebniak, Sergey Levine y Stuart Russell) desarrolló lo que los investigadores de IA llaman un “política contradictoria

La IA de clase mundial de KataGo aprendió Go jugando millones de juegos contra sí misma. Pero esa aún no es suficiente experiencia para cubrir todos los escenarios posibles, lo que deja espacio para vulnerabilidades de comportamiento inesperado. “KataGo se generaliza bien en muchas estrategias novedosas, pero se vuelve más débil cuanto más se aleja de los juegos que vio durante el entrenamiento”, dice Gleave. “Nuestro adversario ha descubierto una de esas estrategias ‘fuera de distribución’ a la que KataGo es particularmente vulnerable, pero es probable que haya muchas otras”.

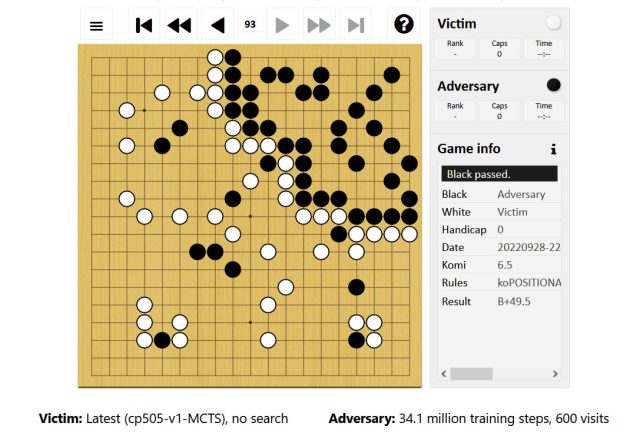

Gleave explica que, durante un partido de Go, la política contradictoria funciona al reclamar primero una pequeña esquina del tablero. Él proporcionó un enlace a un ejemplo en el que el adversario, controlando las piedras negras, juega mayoritariamente en la parte superior derecha del tablero. El adversario permite que KataGo (jugando con blancas) reclame el resto del tablero, mientras que el adversario juega algunas piedras fáciles de capturar en ese territorio.

adam gleave

“Esto engaña a KataGo para que piense que ya ganó”, dice Gleave, “ya que su territorio (abajo a la izquierda) es mucho más grande que el del adversario. Pero el territorio de abajo a la izquierda en realidad no contribuye a su puntuación (solo las piedras blancas que contiene). ha jugado) debido a la presencia de piedras negras allí, lo que significa que no está completamente asegurado”.

Como resultado de su exceso de confianza en una victoria, suponiendo que ganará si el juego termina y se cuentan los puntos, KataGo realiza un movimiento de pase, lo que permite que el adversario también pase intencionalmente, finalizando el juego. (Dos pases consecutivos terminan el juego en Go). Después de eso, comienza una cuenta de puntos. Como explica el documento, “El adversario obtiene puntos por su territorio de esquina (desprovisto de piedras de la víctima) mientras que la víctima [KataGo] no recibe puntos por su territorio no asegurado debido a la presencia de las piedras del adversario”.

A pesar de este ingenioso truco, la política contradictoria por sí sola no es tan buena en Go. De hecho, los aficionados humanos pueden derrotarlo con relativa facilidad. En cambio, el único propósito del adversario es atacar una vulnerabilidad imprevista de KataGo. Un escenario similar podría ser el caso en casi cualquier sistema de inteligencia artificial de aprendizaje profundo, lo que le da a este trabajo implicaciones mucho más amplias.

“La investigación muestra que los sistemas de IA que parecen funcionar a un nivel humano a menudo lo hacen de una manera muy extraña y, por lo tanto, pueden fallar de formas que sorprenden a los humanos”, explica Gleave. “Este resultado es entretenido en Go, pero fallas similares en sistemas críticos para la seguridad podrían ser peligrosas”.

Imagine la IA de un automóvil autónomo que se encuentra con un escenario tremendamente improbable que no espera, lo que le permite a un ser humano engañarlo en realizar comportamientos peligrosos, por ejemplo. “[This research] subraya la necesidad de una mejor prueba automatizada de los sistemas de IA para encontrar los peores modos de falla”, dice Gleave, “no solo probar el rendimiento del caso promedio”.

Media década después de que la IA finalmente triunfara sobre los mejores jugadores humanos de Go, el antiguo juego continúa con su influyente papel en el aprendizaje automático. Los conocimientos sobre las debilidades de la IA Go-playing, una vez que se apliquen ampliamente, pueden incluso terminar salvando vidas.