imágenes falsas

Microsoft trajo DirectStorage a las PC con Windows esta semana. La API promete tiempos de carga más rápidos y gráficos más detallados al permitir que los desarrolladores de juegos creen aplicaciones que carguen datos gráficos desde el SSD directamente a la GPU. Ahora, Nvidia e IBM han creado una tecnología SSD/GPU similar, pero la apuntan a los conjuntos de datos masivos en los centros de datos.

En lugar de apuntar a juegos de consola o PC como DirectStorage, Big Accelerator Memory (BaM) está destinado a proporcionar a los centros de datos acceso rápido a grandes cantidades de datos en aplicaciones intensivas en GPU, como capacitación de aprendizaje automático, análisis y computación de alto rendimiento, según a un trabajo de investigación descubierto por El registro

BaM también difiere de DirectStorage en que los creadores de la arquitectura del sistema planean hacerlo de código abierto.

El documento dice que si bien el acceso a datos de almacenamiento orquestado por CPU es adecuado para aplicaciones de GPU “clásicas”, como el entrenamiento de redes neuronales densas con patrones de acceso a datos “predefinidos, regulares y densos”, causa demasiada “sobrecarga de sincronización CPU-GPU y / o amplificación de tráfico de E/S”. Eso lo hace menos adecuado para las aplicaciones de próxima generación que utilizan gráficos y análisis de datos, sistemas de recomendación, redes neuronales gráficas y otros “patrones de acceso dependientes de datos de grano fino”, escriben los autores.

Al igual que DirectStorage, BaM funciona junto con un SSD NVMe. Según el documento, BaM “mitiga la amplificación del tráfico de E/S al permitir que los subprocesos de la GPU lean o escriban pequeñas cantidades de datos bajo demanda, según lo determine la computadora”.

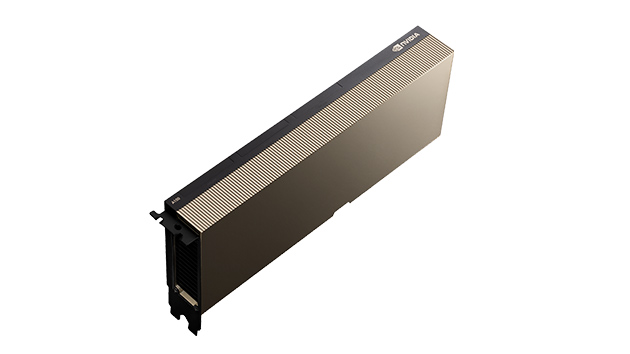

Más específicamente, BaM utiliza la memoria integrada de una GPU, que es un caché administrado por software, además de una biblioteca de software de subprocesos de GPU. Los subprocesos reciben datos del SSD y los mueven con la ayuda de un controlador de kernel de Linux personalizado. Los investigadores realizaron pruebas en un sistema prototipo con una GPU PCIe Nvidia A100 de 40 GB, dos CPU AMD EPYC 7702 con 64 núcleos cada una y 1 TB de memoria DDR4-3200. El sistema ejecuta Ubuntu 20.04 LTS.

El sistema prototipo de los investigadores incluía una GPU PCIe Nvidia A100 de 40 GB (en la foto).

Los autores señalaron que incluso un SSD de “grado de consumidor” podría admitir BaM con un rendimiento de la aplicación que es “competitivo frente a una solución mucho más costosa de solo DRAM”.