Ars Technica

El miércoles, Estabilidad AI Anunciado permitiría a los artistas eliminar su trabajo del conjunto de datos de entrenamiento para una próxima versión de Stable Diffusion 3.0. El movimiento se produce como un grupo de defensa de los artistas llamado Spawning tuiteó que Stability AI cumpliría con las solicitudes de exclusión voluntaria recopiladas en su sitio web Have I Been Trained. Sin embargo, los detalles de cómo se implementará el plan siguen siendo incompletos y poco claros.

Como breve resumen, Stable Diffusion, un modelo de síntesis de imágenes de IA, ganó su capacidad de generar imágenes al “aprender” de un gran conjunto de datos de imágenes extraídas de Internet sin consultar a los titulares de derechos para obtener permiso. Algunos artistas están molestos porque Stable Diffusion genera imágenes que potencialmente pueden rivalizar con los artistas humanos en una cantidad ilimitada. Hemos estado siguiendo el debate ético desde el lanzamiento público de Stable Diffusion en agosto de 2022.

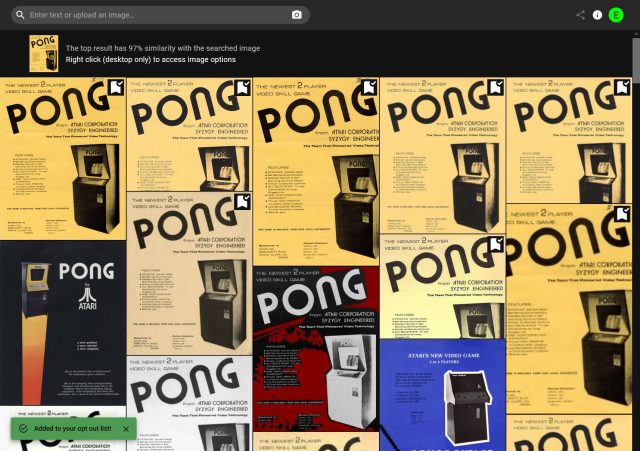

Para comprender cómo se supone que funciona el sistema de exclusión de Stable Diffusion 3, creamos una cuenta en ¿He sido entrenado? y subí una imagen del Atari Apestar folleto de arcade (que no poseemos). Después de que el motor de búsqueda del sitio encontró coincidencias en la Red Abierta de Inteligencia Artificial a Gran Escala (LAION

Una vez marcadas, podíamos ver las imágenes en una lista de imágenes que habíamos marcado como deshabilitadas. No encontramos ningún intento de verificar nuestra identidad ni ningún control legal sobre las imágenes que supuestamente “excluimos”.

Ars Technica

Otros inconvenientes: para eliminar una imagen del entrenamiento, ya debe estar en el conjunto de datos de LAION y debe poder buscarse en Have I Been Trained. Y actualmente no hay forma de excluir grandes grupos de imágenes o las muchas copias de la misma imagen que podrían estar en el conjunto de datos.

El sistema, tal como se implementa actualmente, plantea preguntas que se han hecho eco en los hilos de anuncios en Gorjeo

Un video de Spawning anunciando la opción de exclusión.

Además, poner la responsabilidad sobre el artista de registrarse en un sitio con un conexión no vinculante a Stability AI o LAION y luego esperar que su solicitud sea respetada parece impopular. En respuesta a las declaraciones sobre el consentimiento de Spawning en su video de anuncio, algunas personas señalado que el proceso de exclusión voluntaria no se ajusta a las definición de consentimiento en el Reglamento General de Protección de Datos de Europa, que establece que el consentimiento debe otorgarse activamente, no asumirse por defecto (“El consentimiento debe otorgarse libremente, específico, informado e inequívoco. Para obtener el consentimiento otorgado libremente, debe otorgarse de forma voluntaria .”) En ese sentido, muchos discutir que el proceso debe ser solo opcional, y todas las ilustraciones deben excluirse de la capacitación de IA de forma predeterminada.

Actualmente, parece que Stability AI está operando dentro de las leyes de EE. UU. y Europa para entrenar Stable Diffusion utilizando imágenes raspadas recopiladas sin permiso (aunque este problema aún no se ha probado en los tribunales). Pero la compañía también está tomando medidas para reconocer el debate ético que ha provocado una gran protesta contra el arte generado por IA en línea.

¿Existe un equilibrio que pueda satisfacer a los artistas y permitir que continúe el progreso en la tecnología de síntesis de imágenes de IA? Por ahora, el CEO de Stability, Emad Mostaque, está abierto a sugerencias. tuiteando“El equipo @laion_ai está muy abierto a recibir comentarios y quiere crear mejores conjuntos de datos para todos y está haciendo un gran trabajo. Por nuestra parte, creemos que esta es una tecnología transformadora y estamos felices de interactuar con todos los lados y tratar de ser tan transparentes como posible. Todos se mueven y maduran, rápido”.