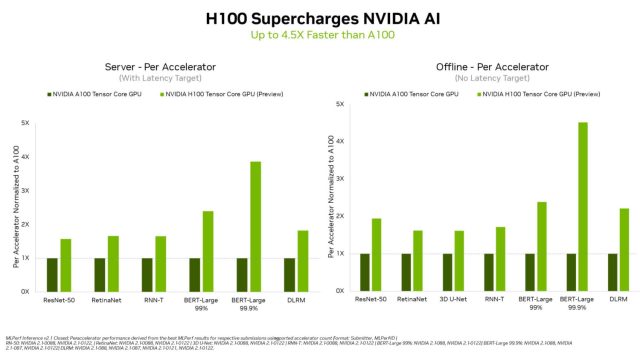

nvidia Anunciado ayer que se acerca H100 La GPU Tensor Core “Hopper” estableció nuevos récords de rendimiento durante su debut en el estándar de la industria MLPerf puntos de referencia, ofreciendo resultados hasta 4,5 veces más rápido que el A100, que actualmente es el chip de IA de producción más rápido de Nvidia.

Los puntos de referencia de MPerf (técnicamente llamados “Inferencia MLPerfTM 2.1

nvidia

En particular, al H100 le fue bien en el BERT-Grande Benchmark, que mide el rendimiento del procesamiento del lenguaje natural utilizando el modelo BERT desarrollado por Google. Nvidia atribuye este resultado particular a la arquitectura Hopper motor transformador, que acelera específicamente los modelos de transformadores de entrenamiento. Esto significa que el H100 podría acelerar futuros modelos de lenguaje natural similares a los de OpenAI. GPT-3que puede componer obras escritas en muchos estilos diferentes y mantener chats conversacionales.

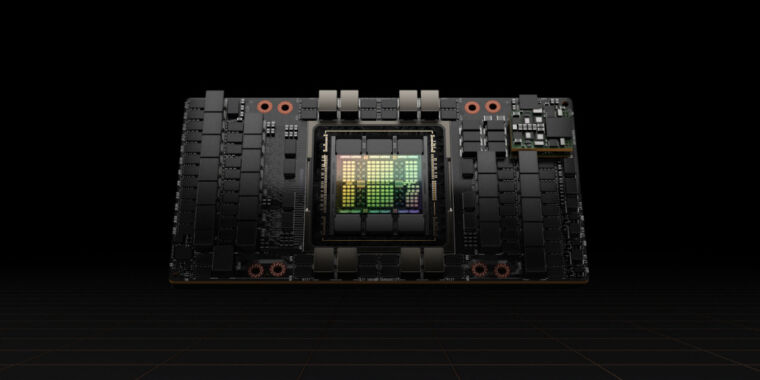

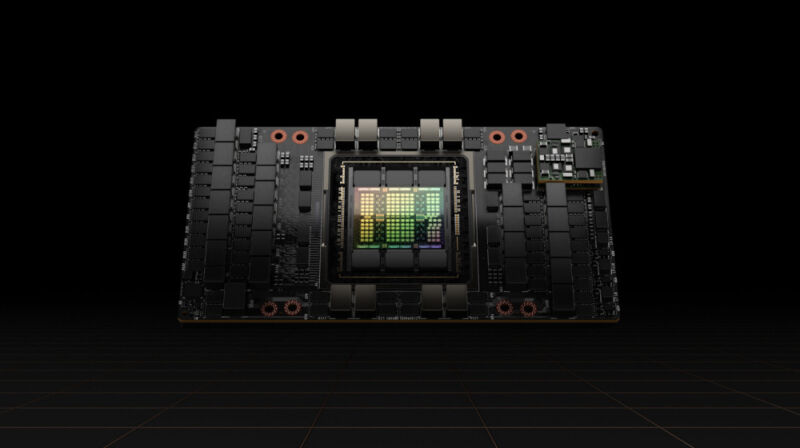

Nvidia posiciona el H100 como un chip de GPU de centro de datos de gama alta diseñado para aplicaciones de inteligencia artificial y supercomputadoras, como reconocimiento de imágenes, modelos de lenguaje grande, síntesis de imágenes y más. Los analistas esperan que reemplace a la A100 como la GPU insignia del centro de datos de Nvidia, pero aún está en desarrollo. Las restricciones del gobierno de EE. UU. impuestas la semana pasada a las exportaciones de chips a China generaron temores de que Nvidia no pueda entregar el H100 para fines de 2022, ya que parte de su desarrollo se lleva a cabo allí.

nvidia aclarado en una segunda presentación de la Comisión de Bolsa y Valores la semana pasada, el gobierno de EE. UU. Permitirá el desarrollo continuo del H100 en China, por lo que el proyecto parece volver a la normalidad por ahora. Según Nvidia, el H100 será disponible “después en este año.” Si el éxito del chip A100 de la generación anterior es una indicación, el H100 puede impulsar una gran variedad de aplicaciones innovadoras de IA en los próximos años.